3700次预训练总结超参规律,开源海量实验,告别盲猜

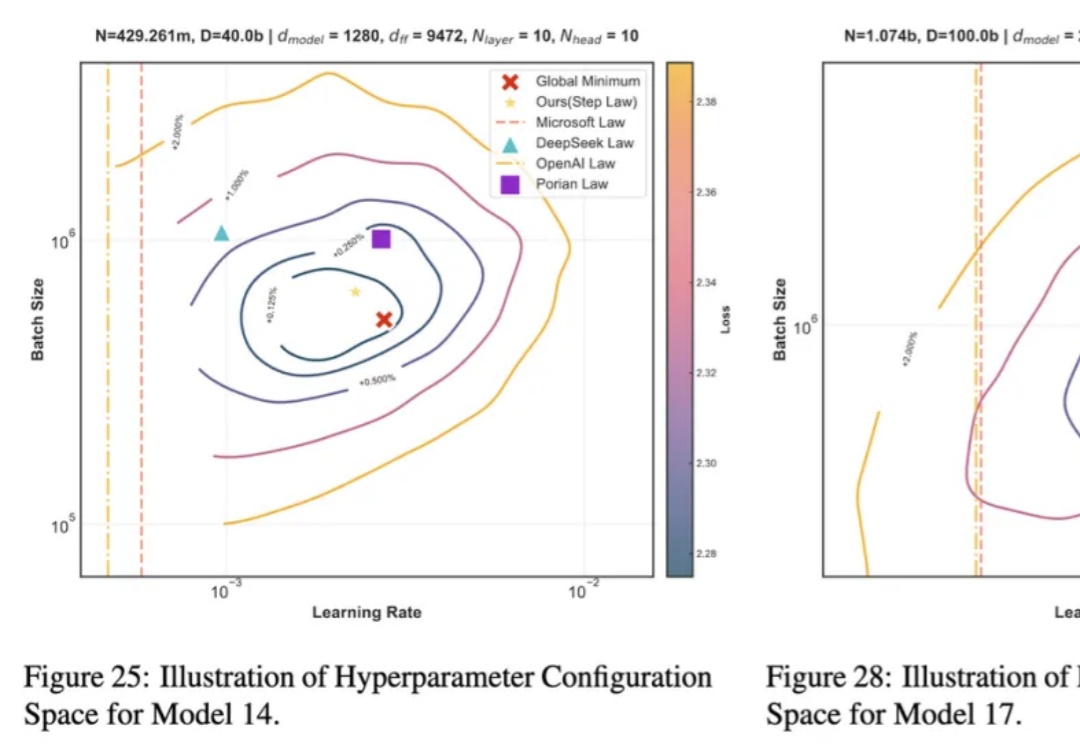

3700次预训练总结超参规律,开源海量实验,告别盲猜近年来,大语言模型 LLMs 在多种任务上的卓越表现已得到广泛认可。然而,要实现其高效部署,精细的超参数优化至关重要。为了探究最佳超参数的规律,我们开展了大规模的实证研究,通过在不同配置上进行网格搜索,我们揭示了一套通用的最优超参数缩放定律(Optimal Hyperparameter Scaling Law)。

近年来,大语言模型 LLMs 在多种任务上的卓越表现已得到广泛认可。然而,要实现其高效部署,精细的超参数优化至关重要。为了探究最佳超参数的规律,我们开展了大规模的实证研究,通过在不同配置上进行网格搜索,我们揭示了一套通用的最优超参数缩放定律(Optimal Hyperparameter Scaling Law)。

Anthropic 昨晚发布了他们最新的 Claude 3.7 Sonnet 混合推理模型,并在官网同步更新了 Claude 3.7 的系统提示词。

近日,记者发现,国内权威医疗大模型评测平台MedBench在官网更新了榜单。多个医疗AI产品及研究团队入榜,其中蚂蚁AI健康管家团队研发的蚂蚁医疗大模型以评测榜单97.5、自测榜单98.2的高分再度夺得双料冠军。

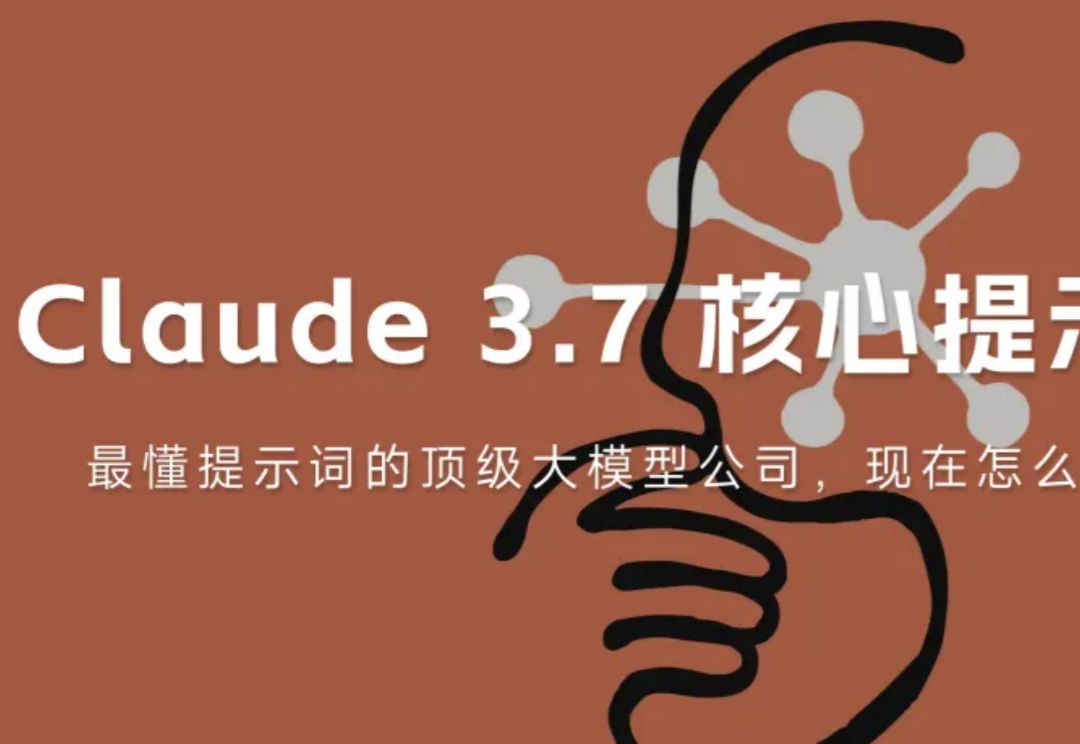

在实际应用过程中,闭源模型(GPT-4o)等在回复的全面性、完备性、美观性等方面展示出了不俗的表现。

今天,外媒披露了谷歌在美国大模型独角兽Anthropic中的持股细节。相关文件显示,谷歌数年来累计对Anthropic注资30亿美元(约合人民币217亿元),换取了后者14%的股份。令人意外的是,这些投资并未让谷歌在Anthropic的运营中享有过多的话语权,但谷歌仍计划在今年9月以可转债的形式再追加7.5亿美元(约合人民币54亿元)投资。

就在刚刚,谷歌Gemma 3来了,1B、4B、12B和27B四种参数,一块GPU/TPU就能跑!而Gemma 3仅以27B就击败了DeepSeek 671B模型,成为仅次于DeepSeek R1最优开源模型。

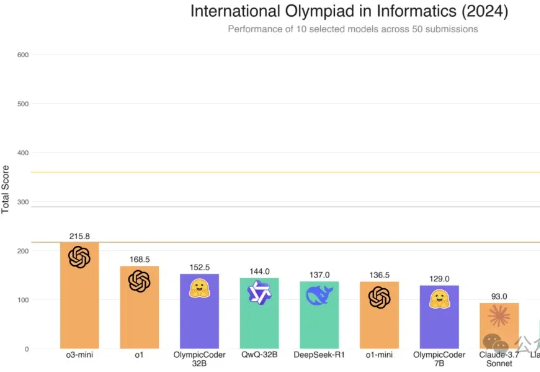

Hugging Face的Open R1重磅升级,7B击败Claude 3.7 Sonnet等一众前沿模型。凭借CodeForces-CoTs数据集的10万高质量样本、IOI难题的严苛测试,以及模拟真实竞赛的提交策略优化,这款模型展现了惊艳的性能。

几年前,由于元宇宙的热潮,几家专注于数字虚拟人的初创公司应运而生。虽然这股热潮已经消退,但生成式人工智能为虚拟人注入了新的活力,因为创建不同的虚拟身份变得更加容易。

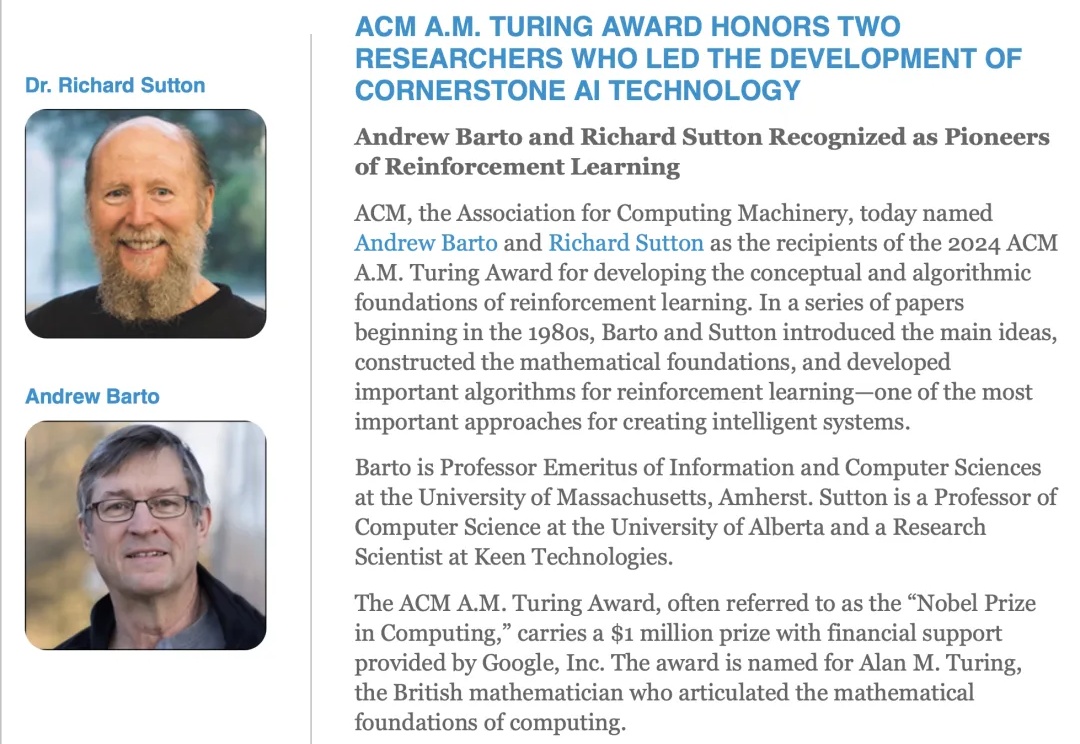

1947 年,艾伦·图灵在一次演讲中提到「我们想要的是一台能够从经验中学习的机器」。

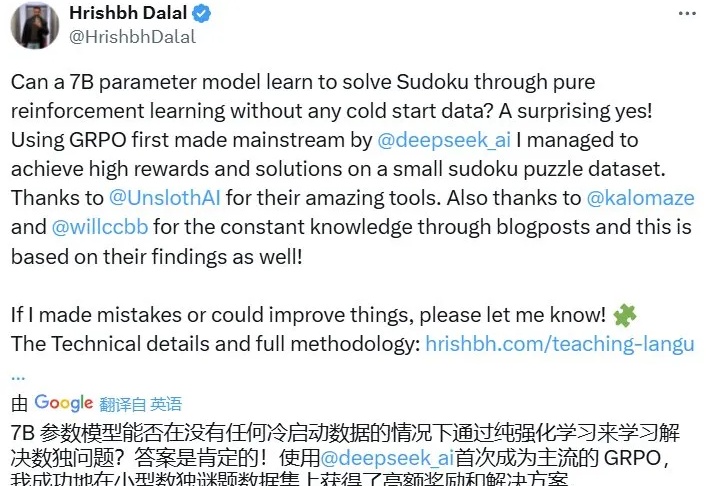

没有任何冷启动数据,7B 参数模型能单纯通过强化学习学会玩数独吗?