DeepSeek前实习生魔改MoE,用迭代机制把内存需求砍了42%,团队:“免费午餐”优化方法

DeepSeek前实习生魔改MoE,用迭代机制把内存需求砍了42%,团队:“免费午餐”优化方法DeepSeek MoE“变体”来了,200美元以内,内存需求减少17.6-42%! 名叫CoE(Chain-of-Experts),被认为是一种“免费午餐”优化方法,突破了MoE并行独立处理token、整体参数数量较大需要大量内存资源的局限。

DeepSeek MoE“变体”来了,200美元以内,内存需求减少17.6-42%! 名叫CoE(Chain-of-Experts),被认为是一种“免费午餐”优化方法,突破了MoE并行独立处理token、整体参数数量较大需要大量内存资源的局限。

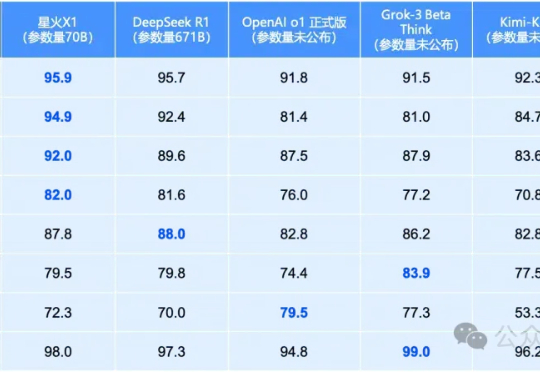

就在昨天,全国产算力训出的讯飞星火X1全面升级!70B小身板在数学领域全面领先,性能直接对标OpenAI o1和DeepSeek-R1。单机部署成本骤降,彻底颠覆行业应用门槛。

给DeepSeek-R1推理指导,它的数学推理能力就开始暴涨。更令人吃惊是,Qwen2.5-14B居然给出了此前从未见过的希尔伯特问题的反例!而人类为此耗费了27年。研究者预言:LLM离破解NP-hard问题,已经又近了一步。

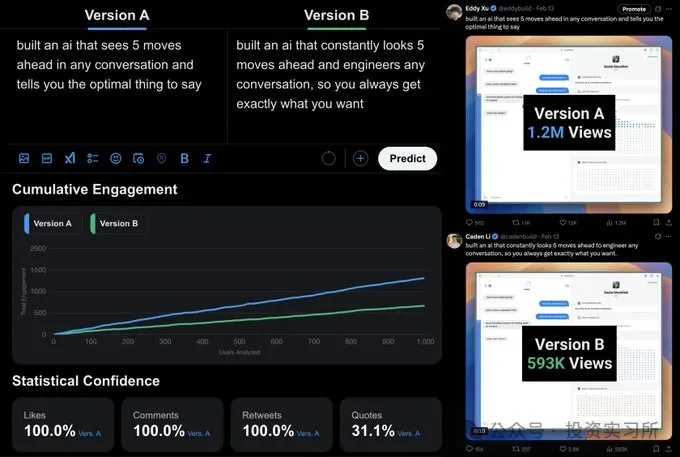

今天想介绍一个 17 岁的华裔大学生,他最近做的一个 AI Wrapper 产品,发布 5 小时收入就突破了 1 万美金,随后在发布的推文火了之后又通过线上会议 Google Meet 的售后承诺在 24 小时赚到了 3 万美金。

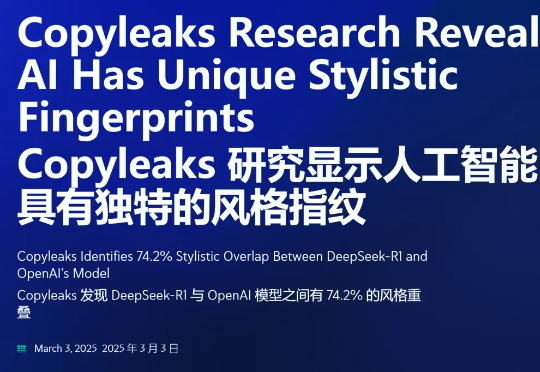

在 DeepSeek 生成的文本中,有 74.2% 的文本在风格上与 OpenAI 模型具有惊人的相似性?这是一项新研究得出的结论。这项研究来自 Copyleaks—— 一个专注于检测文本中的抄袭和 AI 生成内容的平台。

2025年2月27日,由前扩散模型领域顶尖研究者创立的Inception Labs正式发布了全球首个商业级扩散大语言模型(dLLM)——“Mercury”。这一里程碑式产品不仅在生成速度、硬件效率和成本控制上实现突破,更标志着自然语言处理技术从自回归(Autoregressive)范式向扩散(Diffusion)范式的重大跃迁。

当地时间2月17日,埃隆·马斯克旗下人工智能公司xAI直播发布新一代人工智能大模型Grok 3,马斯克直接说这是“地表最聪明AI”。 而更吸引国内观众注意的,则是直播画面里的几张华人面孔。据统计,xAI创始团队四成是华人,其中还包括一位浙江大学毕业的张国栋。

本文介绍了英特尔®至强®处理器在AI推理领域的优势,如何使用一键部署的镜像进行纯CPU环境下基于AMX加速后的DeepSeek-R1 7B蒸馏模型推理,以及纯CPU环境下部署DeepSeek-R1 671B满血版模型实践。

继上周发布全球首个混合推理模型 Claude 3.7 Sonnet 之后,Anthropic 又迎来了一个好消息。今天凌晨,Anthropic 官宣完成 E 轮融资,筹集到了 35 亿美元,投后估值 615 亿美元。

智东西3月3日报道,继2月22日超过豆包后,今日,腾讯旗下AI大模型应用腾讯元宝超过DeepSeek,登顶iOS免费App榜。近期借势DeepSeek,腾讯元宝存在感爆棚,密集上新:2月17日宣布已上线DeepSeek-R1 671B和腾讯混元深度思考模型Thinker(T1);2月18日宣布调用腾讯元宝紧急支持微信搜索,让大家都能稳定体验和使用DeepSeek-R1;