DeepSeek MoE“变体”来了,200美元以内,内存需求减少17.6-42%!

名叫CoE(Chain-of-Experts),被认为是一种“免费午餐”优化方法,突破了MoE并行独立处理token、整体参数数量较大需要大量内存资源的局限。

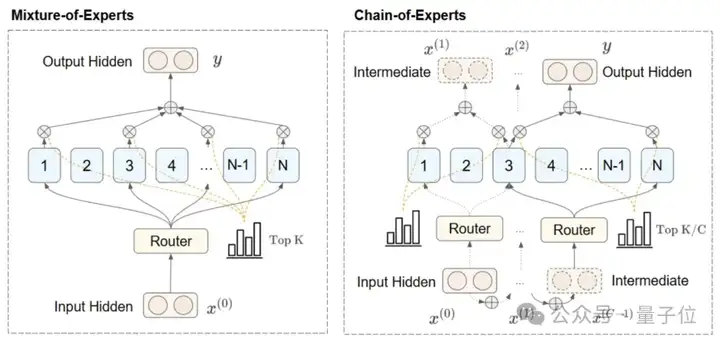

与并行处理不同,CoE使专家能在单层内串行通信,形成一种迭代机制,即专家能“沟通”,在其它专家输出之上处理token。

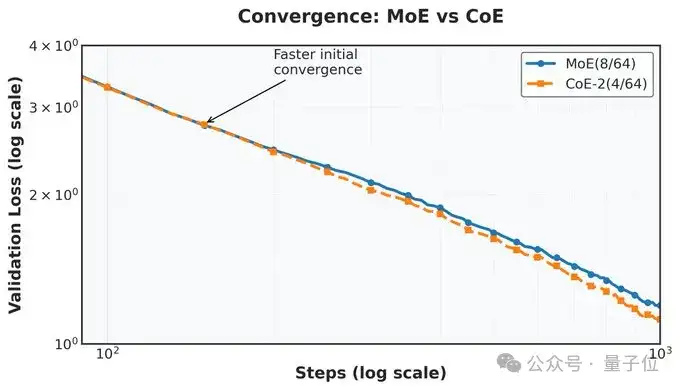

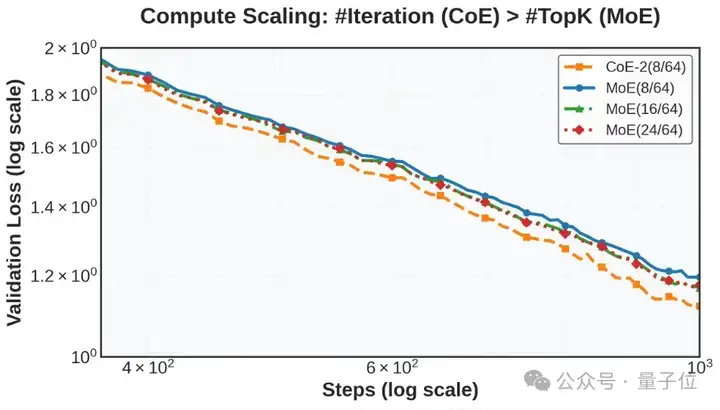

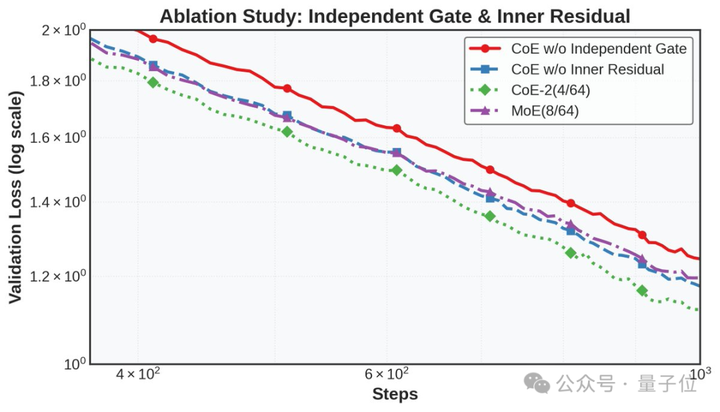

研究团队在实验中发现,经过2次迭代的CoE,在相同的计算预算下将数学任务的验证损失从1.20降低至1.12,仅仅通过重构信息流就获得了性能提升。

通过扩展CoE的迭代次数,在性能相当的情况下,内存使用比通过增加模型层数或扩展专家选择数量的方法降低了17.6-42%。

另外,在专家组合自由度、专家使用效率等其它方面,CoE也都具有显著优势,专家组合增加823倍。

目前,研究团队晒出了CoE技术Blog(完整论文即将发布),引起不少网友围观。

翻看作者主页,还发现作者Zihan Wang真曾在DeepSeek实习过😯

有网友看过这项研究表示:

MoEs中的IsoFLOP层迭代设计,非常奈斯。

还有网友已经开始预测下一代架构了。

CoE究竟长啥样?以下是团队发布的Notion Blog介绍。

CoE关键创新在于建立沟通性处理机制,改变了稀疏神经网络的信息处理方式。

具体来说,是通过在单个层的迭代中将MoE输出反馈为多次迭代的输入来实现的。

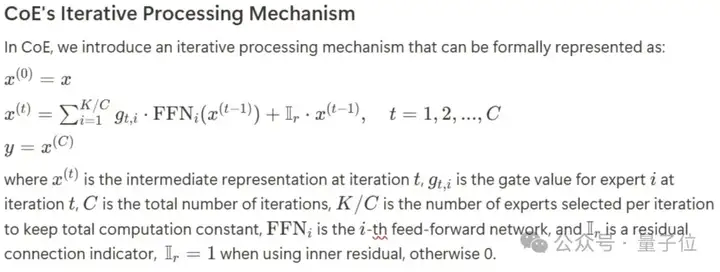

CoE迭代处理机制可以形式化表示为下面这个样婶儿:

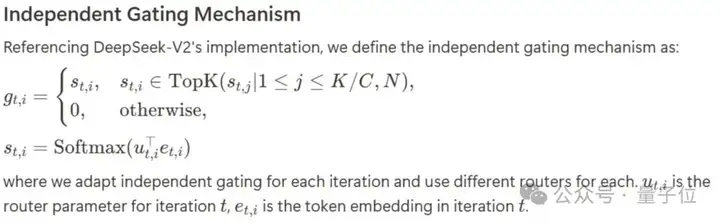

参考DeepSeek-V2的实现,研究团队定义门控机制为如下:

团队介绍,这种设计的好处在于每次迭代的专家选择由前一次迭代的输出决定,形成专家间的依赖关系和更动态的路由机制。

而且串行信息可以在迭代过程中累积,实现专家间的直接通信。

实验采取DeepSeek V2架构,在参数规模为500M的MoE模型上使用32K Tok的batch size训练1000步,以此来验证CoE的有效性。

结果CoE在性能、扩展策略、资源效率优化、专家组合自由度、专家使用效率方面具有显著优势。

除了开头所展示的在相似的算力和内存要求下,CoE将loss从1.20下降至1.12,且有更陡峭的下降趋势。

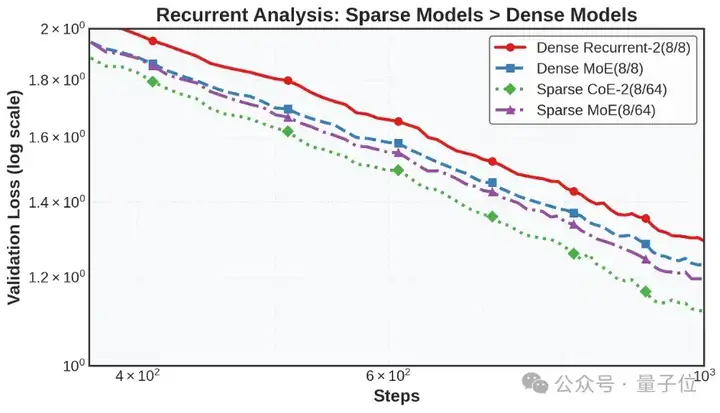

团队进一步在“dense”(专家8选8)模型上也进行了测试,结果证明了串行处理在Sparse MoE上相比Dense模型更有效,CoE是一种专为(细粒度)稀疏混合专家模型(Sparse MoE)设计的方法。

采取2次序列化处理并不能显著提升Dense模型性能。

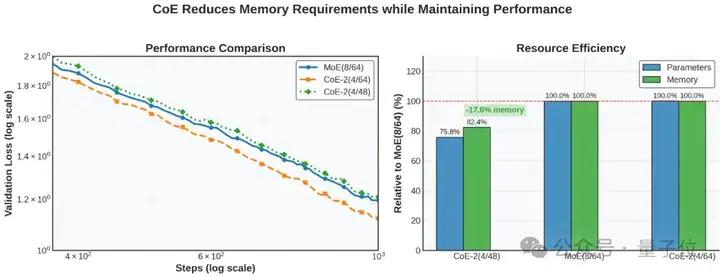

另外,在计算量和效果相似的情况下,CoE可以减小对内存的要求。如下,CoE-2(4/48)的效果与MoE(8/64)相近,但使用更少的总专家数量。loss match的情况下减小了17.6%的内存需求。

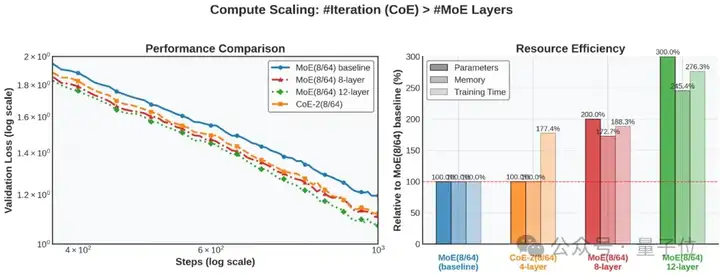

团队还对比了在预算相似的情况下,扩展CoE迭代次数和扩展模型层数、扩展专家选择个数的效果,结果扩展CoE迭代次数更优。

CoE-2(8/64),4层 vs MoE(8/64),8层/12层,8层MoE和CoE效果几乎相同,但是对内存要求高72%,即CoE相对节省了42%内存。

团队强调,独立门控机制和内残差连接是CoE的关键架构创新,消融研究表明,移除任何组件都会显著降低性能。

更多细节,感兴趣的童鞋可以查看技术报告原文~

CoE由一个5人组成的团队提出。

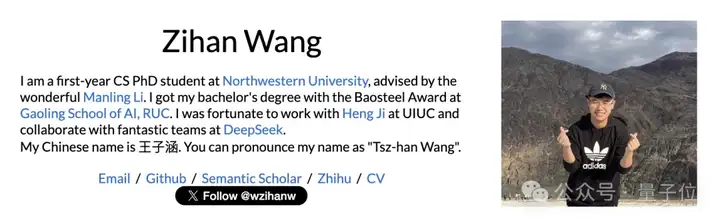

Zihan Wang是美国西北大学计算机科学专业博士生,本科毕业于中国人民大学高瓴人工智能学院,研究聚焦于基础模型的自主性、效率以及长上下文理解。

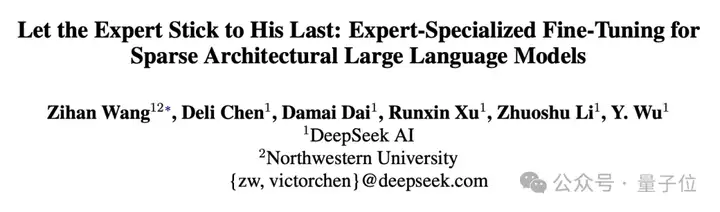

Zihan Wang曾在DeepSeek工作过,是ESFT(Expert-Specialized Fine-Tuning)的论文一作。

ESFT通过仅调整与任务相关的部分高效地定制采用MoE,从而在减少资源和存储使用的同时提升效率和性能。

CoE不是Zihan Wang第一次针对DeepSeek搞的“变体”。

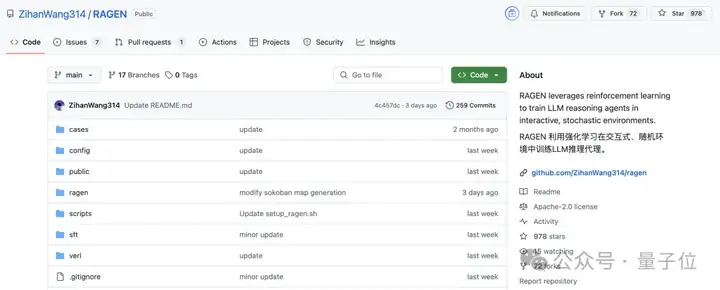

之前他还曾基于verl复现了DeepSeek-R1(-Zero)框架——RAGEN (Reinforcement learning AGENt),在GitHub揽星近1k:

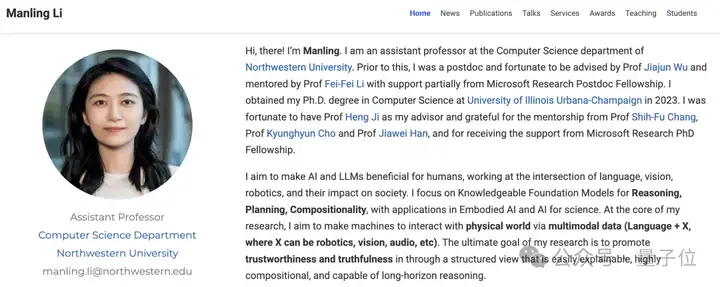

Zihan Wang师从Manling Li。Manling Li是西北大学计算机科学系助理教授,此前曾在吴佳俊教授的指导下工作,并得到李飞飞教授的指导。

RAGEN的贡献者名单中也有Manling Li、吴佳俊、李飞飞的身影。

CoE技术报告:http://sandy-server-87f.notion.site/Chain-of-Experts-Unlocking-the-Communication-Power-of-MoEs-1ab9bb750b7980048d43e6aab3537cea

CoE GitHub链接:https://github.com/ZihanWang314/coe

参考链接:

[1]https://x.com/wzihanw/status/1896601518612021709

[2]https://github.com/ZihanWang314/RAGEN?tab=readme-ov-file

[3]https://github.com/deepseek-ai/ESFT

文章来自于微信公众号“量子位”,作者“西风”

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI