AI,救了我的命

AI,救了我的命我,终于苏醒了。 这一次,将我从死神手中抢救回来的是“Magic100”。

我,终于苏醒了。 这一次,将我从死神手中抢救回来的是“Magic100”。

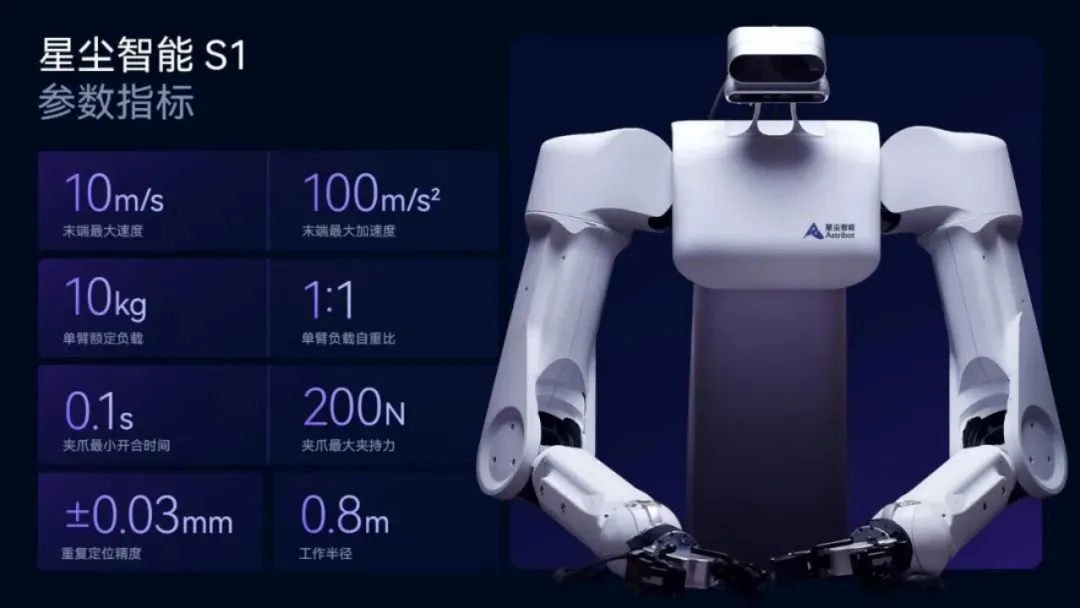

随着 AI 向 AGI(通用人工智能)的圣杯方向加速发展,大模型与机器人的结合是必然趋势。数十年来,单一用途机器人市场已趋于饱和,AI 通用机器人的巨大潜力急待开垦。

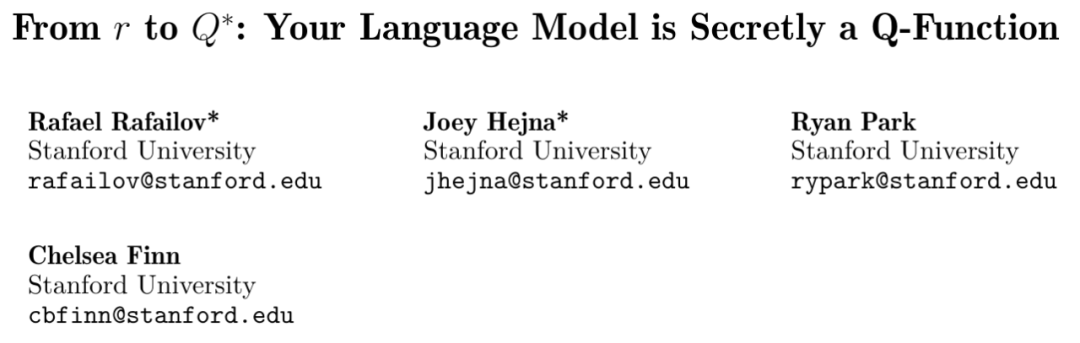

在对齐大型语言模型(LLM)与人类意图方面,最常用的方法必然是根据人类反馈的强化学习(RLHF)

最近几年,AI技术的发展远远超出普通大众和研究者的预期,「通用人工智能(AGI)」的概念也从科幻小说中走进了日常生活的讨论中,成为了许多科技公司和研究机构所追求的最终目标。

如果你手头有一个价值100亿美元的AI模型,通过了安全测试且让所有人受益,你愿意将它开源吗?

2024年,“找到靠谱工作”和“招到靠谱的人”依然是共生的困扰。我们坚定认为,抛开传统大厂,市场中仍有大量符合下一个时代红利的雇主公司等待被挖掘。赛道潜力、业务逻辑、人事情况……对这些信息的掌握和洞察,决定了求职者选择公司的眼光,也决定了面试交流的质量与深度。

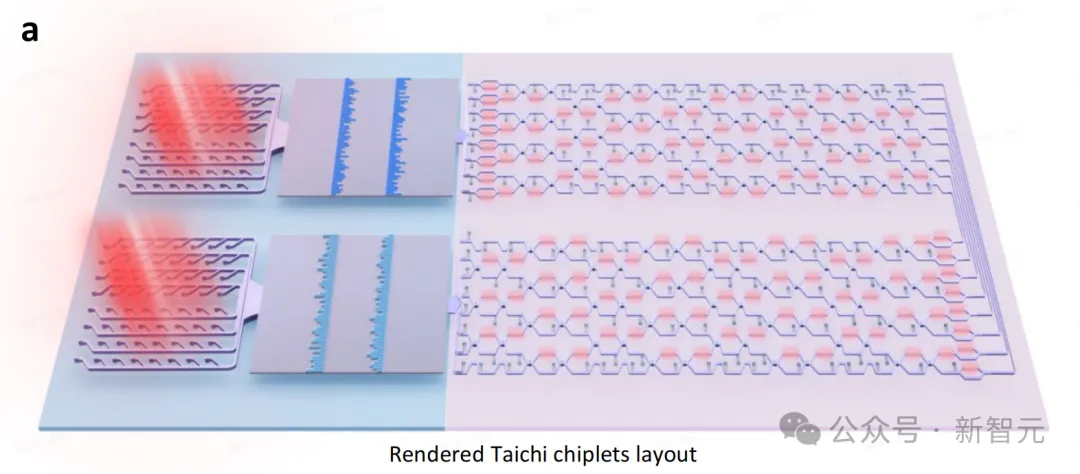

训练下一代万亿级参数大模型的高效芯片诞生了!

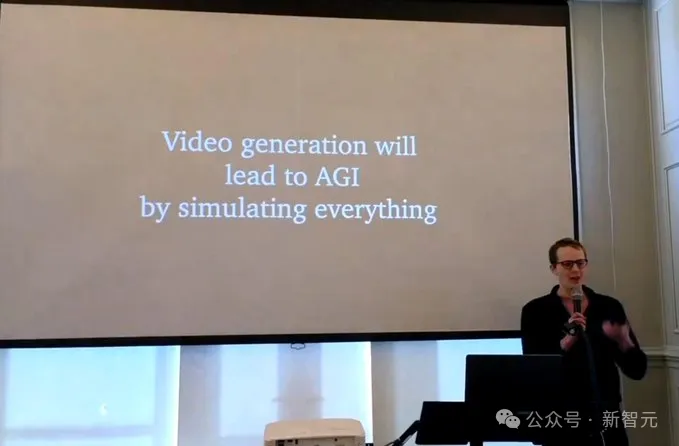

通过什么方式够实现通用人工智能? 近期由AGI House组织的一场主题演讲给出了解答。

日前,马斯克在与挪威央行首席执行官 Nicolai Tangen 的一次直播访谈中,说出了许多争议性言论: “我见过很多技术,AI 是我见过发展最快的技术。”

投人,仍是现阶段 AGI 领域早期投资最真实的投资逻辑之一。 如果,暂时还没有超低成本的获得用户或者客户的变局,商业上比拼的就是低成本的资金,明星创业者和大厂就更有阶段性优势。如果,当前模型能力还未定性,做出产品 PMF 仍有不确定性,持续融资能力就是投资机构考核创业者的隐性标准,「天才青年创业者密度」就比「故事」、「逻辑」、「产品」更打动投资人。