硅谷大空头杀回来了!做空甲骨文,英伟达万亿AI泡沫要崩?

硅谷大空头杀回来了!做空甲骨文,英伟达万亿AI泡沫要崩?预测到次贷危机的「大空头」Michael Burry看到数万亿美元涌入AI基础设施,产生深深的怀疑。他预言:英伟达的优势并不持久,可能很快就会被对手战胜。而且,如今全球AI算力已经达到1500万H100 GPU当量,即将引爆严重能源危机!

预测到次贷危机的「大空头」Michael Burry看到数万亿美元涌入AI基础设施,产生深深的怀疑。他预言:英伟达的优势并不持久,可能很快就会被对手战胜。而且,如今全球AI算力已经达到1500万H100 GPU当量,即将引爆严重能源危机!

近日,全球顶级创业孵化器Y Combinator在最新一期视频播客中,对2025年AI行业做出年终总结。作为全球初创企业的风向标,YC每年孵化大量顶尖AI初创公司,其内部观察往往预示技术与商业的转向。在本次对谈中,四位合伙人针对2025年的模型竞争格局、AI基础设施泡沫,以及创业与人才趋势等核心议题,展开了深度讨论。

AI基建市场,再现黑马!近日,此前名不见经传的荷兰AI基础设施公司Nebius,在短短3个月间连续斩获微软价值194亿美元(约合人民币1379亿元)与Meta价值30亿美元(约合人民币213亿元)的两笔算力大单,引发业界关注。

成立两年半,再添近5亿元A+轮融资—— 截至目前,无问芯穹已累计吸金近15亿,成为AI基础设施领域最受资本追捧的“黑马”企业之一。

甲骨文于上周发布全球最大云端AI超级计算机「OCI Zettascale10」,由80万块NVIDIA GPU组成,峰值算力高达16 ZettaFLOPS,成为OpenAI「星际之门」集群的算力核心。其独创Acceleron RoCE网络实现GPU间高效互联,显著提升性能与能效。该系统象征甲骨文在AI基础设施竞争中的强势布局。

今天星舰第十一飞圆满收官,没想到黄仁勋也闪现到了现场。 原来,黄仁勋亲自飞到了德州的星际基地(Starbase),在冲天的星舰旁边,就是为了把一台刚出炉的新「核弹」交到了马斯克手上。 这就是大家从年初

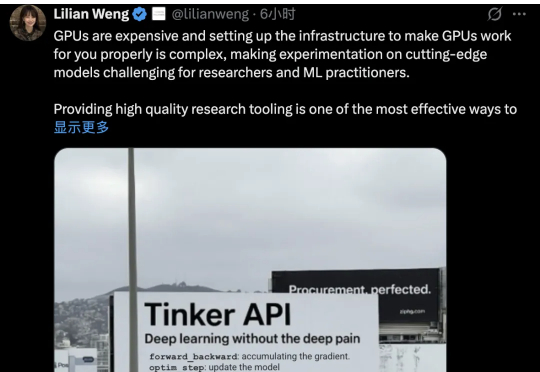

Thinking Machines Lab发布首个产品:Thinker,让模型微调变得像改Python代码一样简单。也算是终于摘掉了“0产品0收入估值840亿”的帽子。Tinker受到了业界的密切关注。AI基础设施公司Anyscale的CEO Robert Nishihara等beta测试者表示,尽管市面上有其他微调工具,但Tinker在“抽象化和可调性之间取得了卓越的平衡”

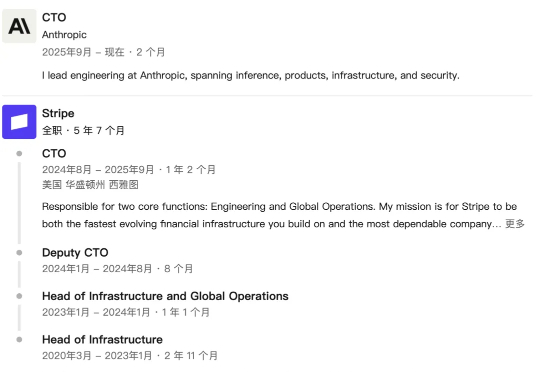

Anthropic宣布任命前Stripe CTO Rahul Patil为新任首席技术官,此次换帅旨在强化Anthropic的AI基础设施,以应对Claude产品快速增长带来的算力和能耗压力。同时,也是为了面对OpenAI和Meta数千亿美元级的基础设施投入而进行的一次战略调整。

刚刚完成1300万美元种子轮融资的Runware,正在用一种完全不同的方式重新定义AI基础设施。他们不依赖现成的云服务提供商,而是从零开始构建了自己的硬件和软件栈,创造出了所谓的"Sonic推理引擎"。这种垂直整合的方法让他们能够将AI推理成本降低高达90%,同时通过单一API提供对超过40万个AI模型的访问。

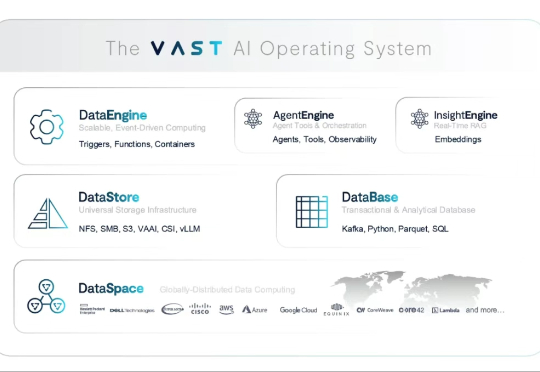

智东西8月26日报道,近日,谷歌母公司Alphabet风投部门CapitalG、英伟达正在洽谈投资以色列AI基础设施提供商VAST Data,融资金额或达到数十亿美元,或将成为以色列科技公司史上最大规模融资。融资完成,这家创企的估值将跃升至300亿美元(折合人民币约2148亿元)。