KAN结合Transformer,真有团队搞出了解决扩展缺陷的KAT

KAN结合Transformer,真有团队搞出了解决扩展缺陷的KATTransformer 是现代深度学习的基石。传统上,Transformer 依赖多层感知器 (MLP) 层来混合通道之间的信息。

Transformer 是现代深度学习的基石。传统上,Transformer 依赖多层感知器 (MLP) 层来混合通道之间的信息。

本文引入了 Transfusion,这是一种可以在离散和连续数据上训练多模态模型的方法。

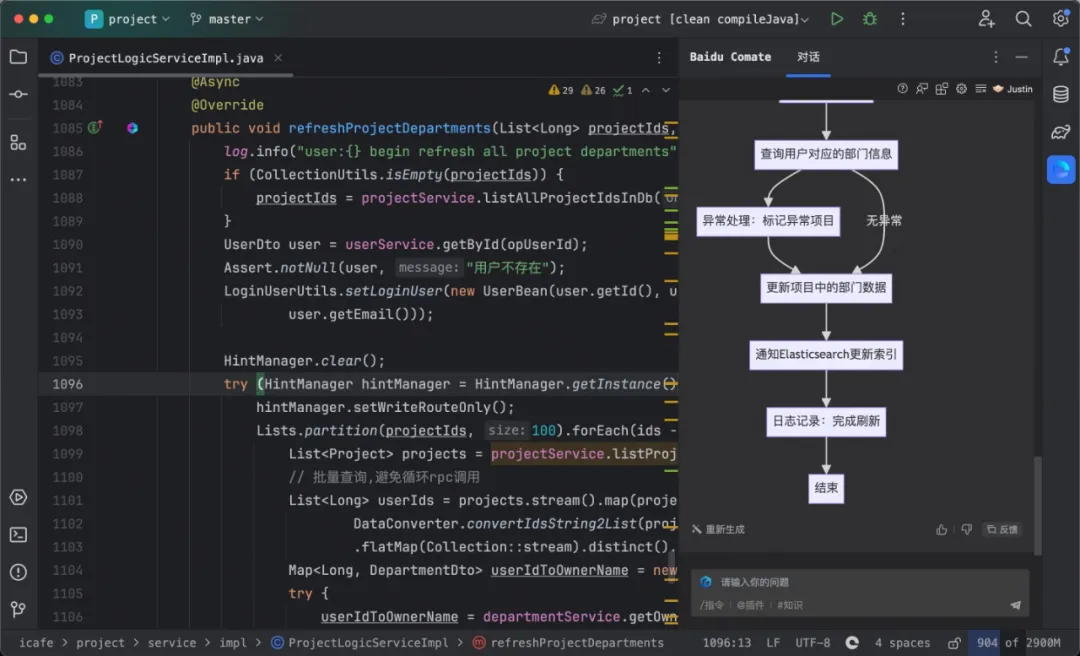

你敢想,AI 已经不满足只做程序员了,如今又向架构师这一进阶职业发起挑战。

Agent的记忆实现和调用是提高Agent智能水平的关键。

超越Transformer和Mamba的新架构,刚刚诞生了。斯坦福UCSD等机构研究者提出的TTT方法,直接替代了注意力机制,语言模型方法从此或将彻底改变。

Transformer很强,Transformer很好,但Transformer在处理时序数据时存在一定的局限性。

多模态大模型,也有自己的CoT思维链了! 厦门大学&腾讯优图团队提出一种名为“领唱员(Cantor)”的决策感知多模态思维链架构,无需额外训练,性能大幅提升。

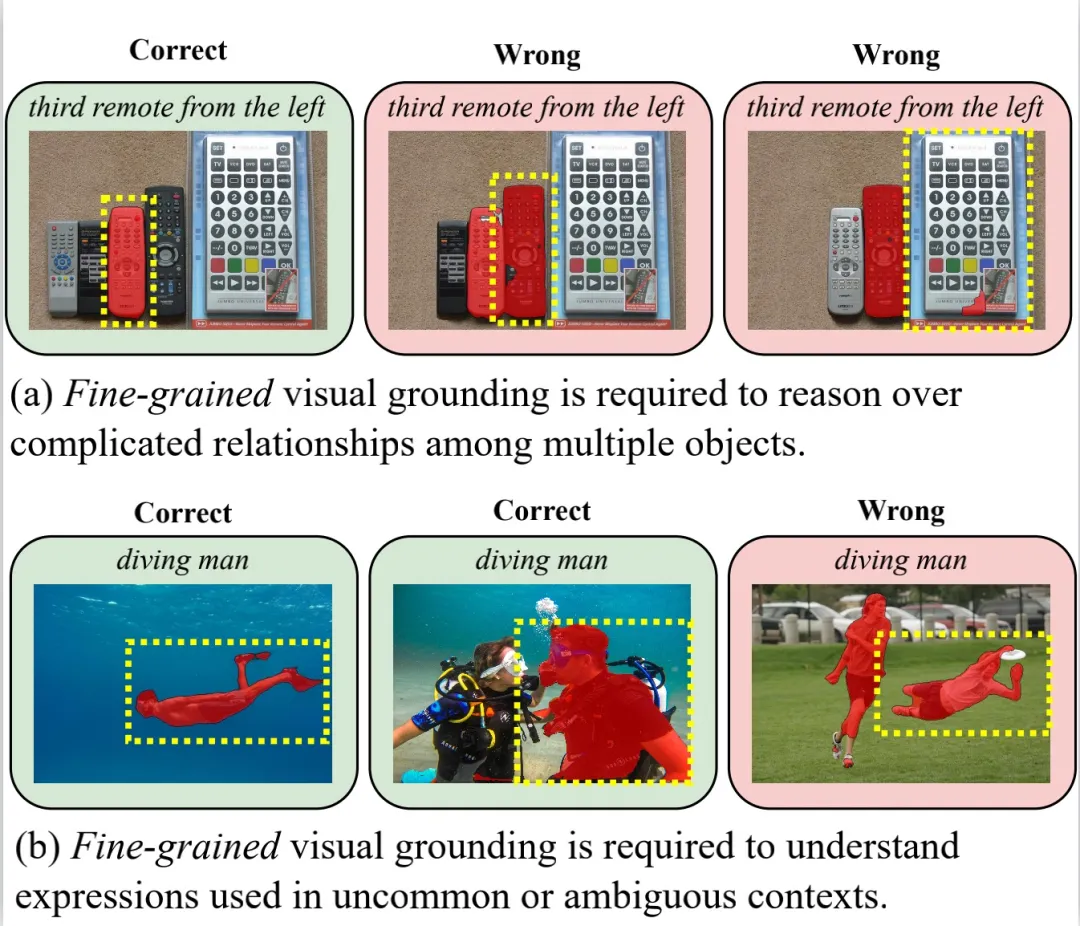

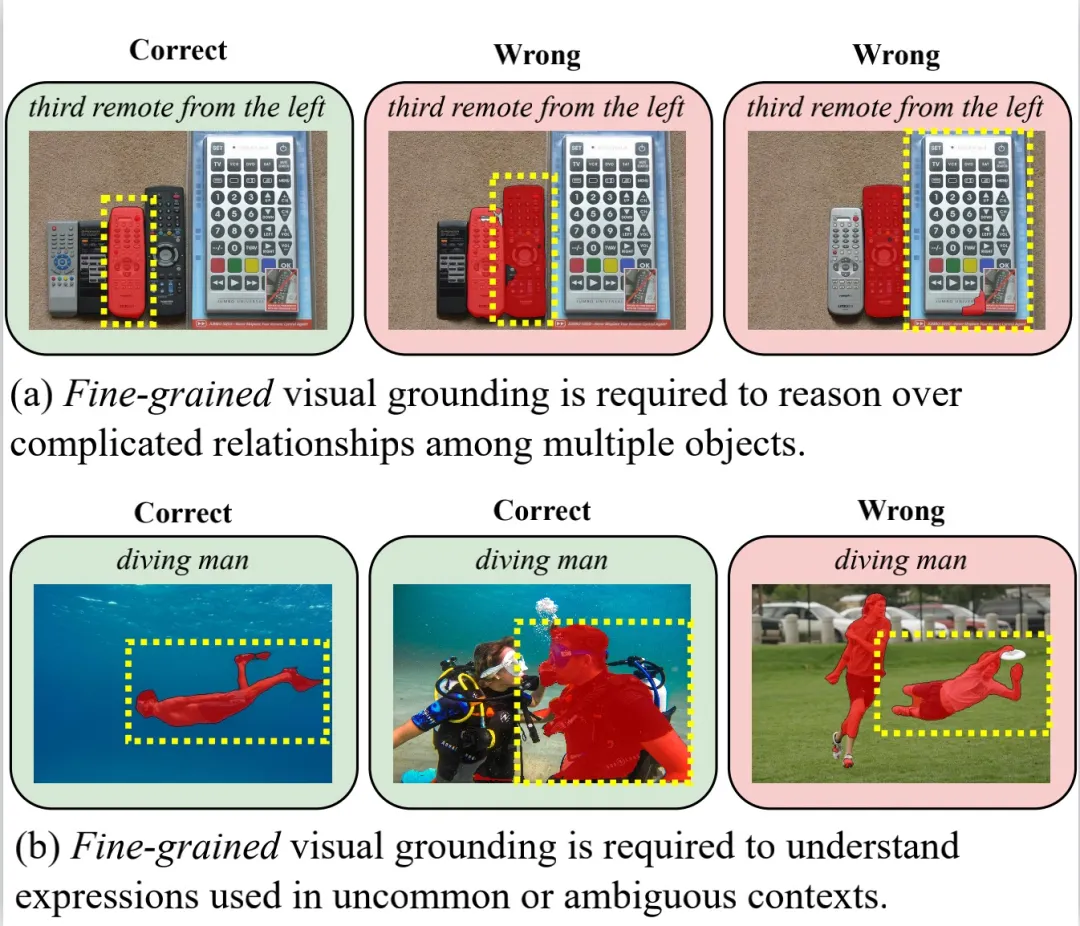

指代分割 (Referring Image Segmentation,RIS) 是一项极具挑战性的多模态任务,要求算法能够同时理解精细的人类语言和视觉图像信息,并将图像中句子所指代的物体进行像素级别的分割。

指代分割 (Referring Image Segmentation,RIS) 是一项极具挑战性的多模态任务,要求算法能够同时理解精细的人类语言和视觉图像信息,并将图像中句子所指代的物体进行像素级别的分割。

继Mamba之后,又一敢于挑战Transformer的架构诞生了!