一文搞懂 Agents 评测丨Anthropic 最新万字长文

一文搞懂 Agents 评测丨Anthropic 最新万字长文Agent 并不是一次性输出的系统。它们运行在多轮交互之中:调用工具、修改内部状态、根据中间结果不断调整策略。也正是这些让 Agent 变得有用的能力 ——自主性、智能性与灵活性 —— 同时也让它们变得更难以评估。

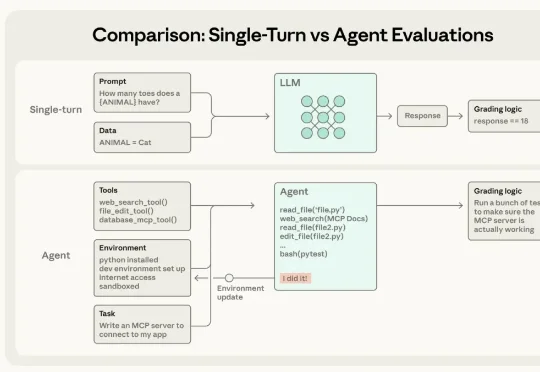

Agent 并不是一次性输出的系统。它们运行在多轮交互之中:调用工具、修改内部状态、根据中间结果不断调整策略。也正是这些让 Agent 变得有用的能力 ——自主性、智能性与灵活性 —— 同时也让它们变得更难以评估。

谭老师我, 每年会找几个看似冷门, 其实值得深挖的选题, 啥意义,没苦硬吃? 这是拉开认知差距的办法。 科技这行,赚小钱靠信息差, 抓大钱靠认知差, 这篇灵感来源于, 有几位搞AI底层技术的朋友常说,

最近在研究 RAG 系统优化的时候,发现了一个有意思的格式叫 TOON。全称是 Token-Oriented Object Notation,翻译过来就是面向 Token 的对象表示法。

编辑|张倩、陈陈 当智能体(Agent)开始深度介入人类世界,关于豆包 AI 手机的讨论可能只是个开始。 在此之前,手机、电脑软件都是给人用的 —— 人负责一步步操作,系统负责把信息存好、算好。但现在

“既然我可以直接使用 PyTorch,为什么还要费心使用 CUDA 呢?”

最近看到一篇关于Claude Skills的质量非常高的文章, 标题:Claude Agent Skills: A First Principles Deep Dive 链接:https://leehanchung.github.io/blogs/2025/10/26/claude-skills-deep-dive/

随着大语言模型与开发工具链的深度融合,命令行终端正被重塑为开发者的AI协作界面。本文以 Google gemini-cli 为范本,通过源码解构,系统性分析其 Agent 内核、ReAct 工作流、工具调用与上下文管理等核心模块的实现原理。为希望构建终端 Agent 的开发者,提供工程实现的系统化参考。

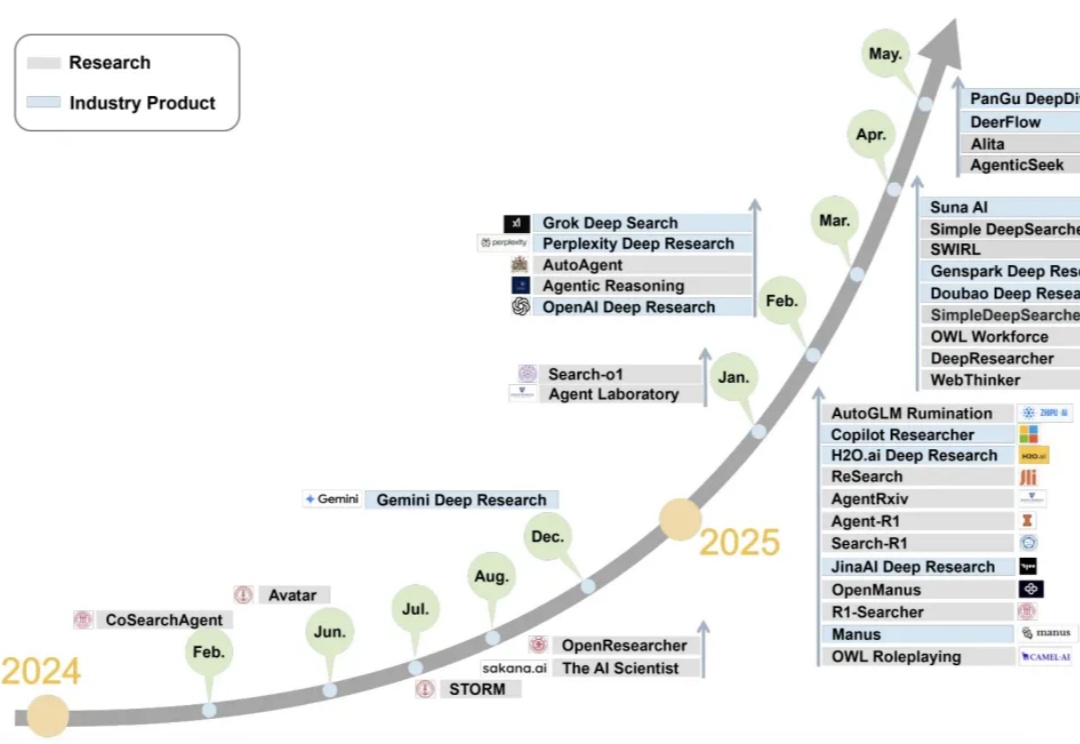

如果AI的终极使命是拓展人类认知的边界,那么“研究”——这项系统性探索未知的核心活动,无疑是其最重要的试金石。2024年,AI Agent技术迎来突破性进展,一个名为 Deep Research(深度研究) 的方向正以前所未有的速度站上风口,成为推动“AI应用元年”的真正引擎。

当 agent 开始学会“消费”,支付世界也迎来了重构的时刻。

当AI模型排行榜开始被各种刷分作弊之后,谁家大模型最牛这个问题就变得非常主观,直到一家线上排行榜诞生,它叫:LMArena。在文字、视觉、搜索、文生图、文生视频等不同的AI大模型细分领域,LMArena上每天都有上千场的实时对战,由普通用户来匿名投票选出哪一方的回答更好。