DeepMind爆火论文:向量嵌入模型存在数学上限,Scaling laws放缓实锤?

DeepMind爆火论文:向量嵌入模型存在数学上限,Scaling laws放缓实锤?这几天,一篇关于向量嵌入(Vector Embeddings)局限性的论文在 AlphaXiv 上爆火,热度飙升到了近 9000。

这几天,一篇关于向量嵌入(Vector Embeddings)局限性的论文在 AlphaXiv 上爆火,热度飙升到了近 9000。

AI 也要「考古」式科研?

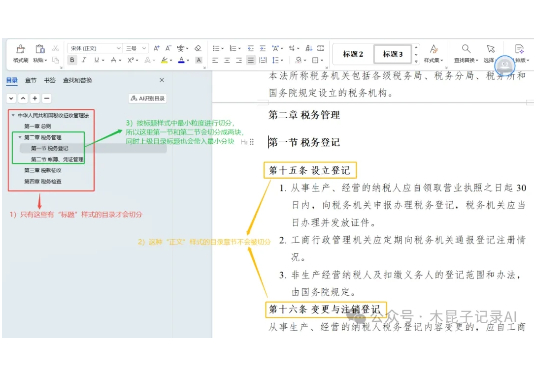

团队在自研知识库底座的过程中,想对比参考下RAGFlow,发现其切片方法缺乏详细说明和清晰案例,如果你也遇到以下问题,本文能帮你节省大量试错时间

刚刚,AWS亚马逊云科技上海AI研究院被曝解散!AI研究院首席应用科学家王敏捷在朋友圈中写道:「过去六年领导这个团队,正值外国研究机构在中国的黄金时期。」

红杉美国合伙人 Konstantine Buhler 预测 2025 年将成为 AI agent 的“群体协作”时代,标志着 Agent 元年的到来。

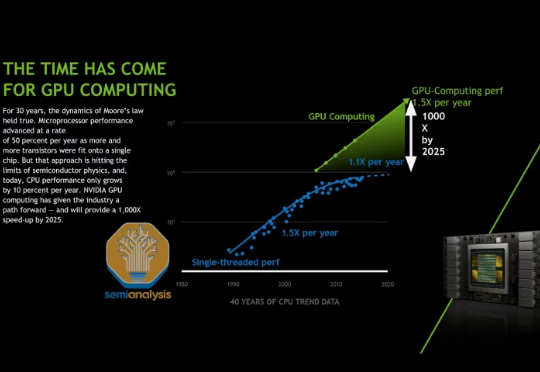

在我们去年 AI Scaling Laws article from late last year中,我们探讨了多层 AI 扩展定律如何持续推动 AI 行业向前发展,使得模型能力的增长速度超过了摩尔定律,并且单位 token 成本也相应地迅速降低。

E2B 的愿景很大,CEO 的目标是成为 AI Agent 时代的 AWS,成为一个自动化的 infra 平台,未来可以提供 GPU 支持,满足更复杂的数据分析、小模型训练、游戏生成等需求,并可以托管 agent 构建的应用,覆盖 agent 从开发到部署的完整生命周期。

红杉资本预计AI市场规模将远超当前约4000亿美元的云计算市场,在未来10-20年内达到难以估量的体量。初创企业需聚焦应用层,深耕垂直领域,提供端到端解决方案。AWS研究显示,全球企业正加速拥抱生成式AI,首席AI官(CAIO)职位将成为企业标配。

研究揭示早融合架构在低计算预算下表现更优,训练效率更高。混合专家(MoE)技术让模型动态适应不同模态,显著提升性能,堪称多模态模型的秘密武器。

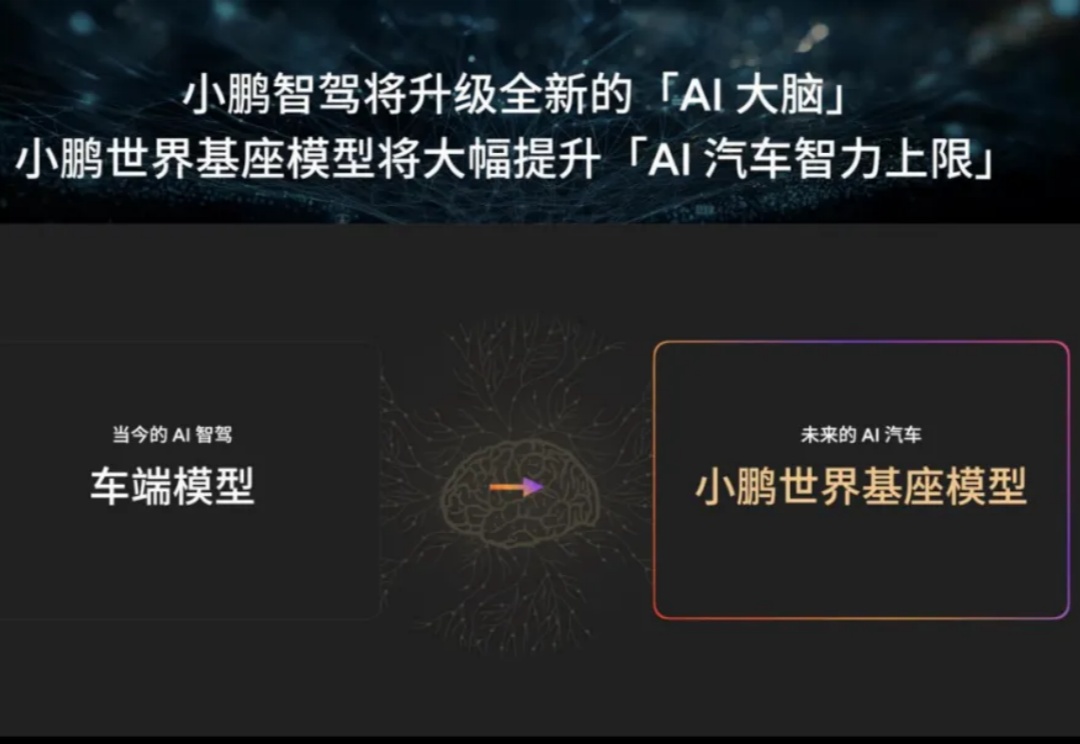

最近一段时间,各家新势力都在角力部署端到端的智能驾驶系统。