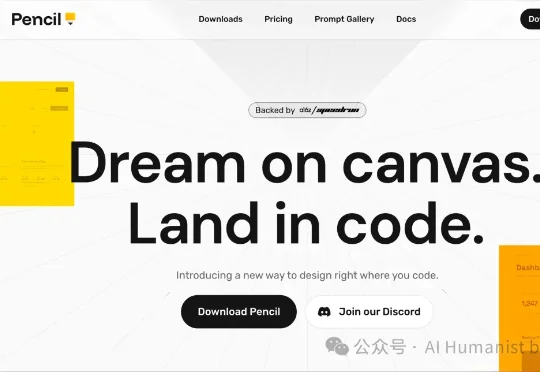

Pencil.dev 是今年最被低估的 AI 设计开发者工具,值得一个「封神」|附全面实测

Pencil.dev 是今年最被低估的 AI 设计开发者工具,值得一个「封神」|附全面实测2 月 25 日,这篇文章发出来的前两天,Pencil.dev 的首席氛围官在 X 上发了条动态,说他们的用户数量刚刚突破了 10 万。 这个数字,放在整个 AI 工具市场里其实不算显眼。但圈子里的反应完全不一样。开发者社区、设计圈、AI 产品人,这段时间提到 Pencil.dev 的频率越来越高,而且说法都差不多:这东西有点东西。