自回归科学基座模型 BigBang-Proton,提出实现 AGI 的新路线

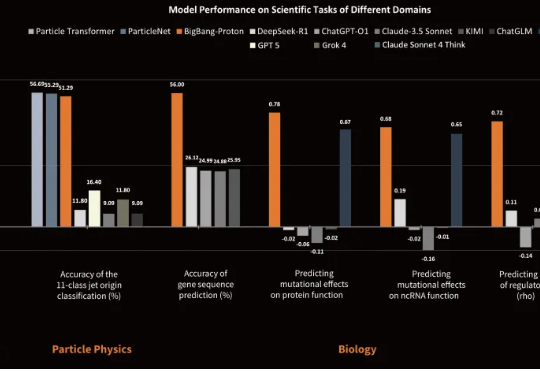

自回归科学基座模型 BigBang-Proton,提出实现 AGI 的新路线近日,专注于研发物质世界基座模型的公司超越对称(上海)技术有限公司(超对称)发布了新版基座模型 BigBang-Proton,成功实现多个真实世界的专业学科问题与 LLM 的统一预训练和推理,挑战了 Sam Altman 和主流的 AGI 技术路线。

近日,专注于研发物质世界基座模型的公司超越对称(上海)技术有限公司(超对称)发布了新版基座模型 BigBang-Proton,成功实现多个真实世界的专业学科问题与 LLM 的统一预训练和推理,挑战了 Sam Altman 和主流的 AGI 技术路线。

AI卷走饭碗,17万大军一夜失业。别慌,Scale AI新作一锤定音:全球六大顶尖AI,现在能自动处理的事情连3%都不到。来自Scale AI和Center for AI Safety最新研究,一句话戳破了真相:虽然AI很聪明,但还不够实用。目前,AI自动化率还不到3%。值得一提的是,论文参与者中,还有Alexandr Wang本尊,曾在Scale AI期间完成的研究。

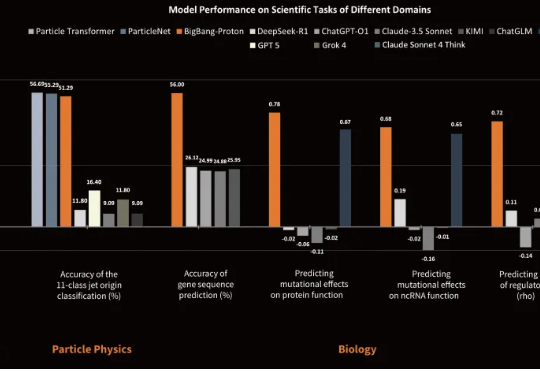

近年来,基于流匹配的 VLA 模型,特别是 Physical Intelligence 发布的 π0 和 π0.5,已经成为机器人领域备受关注的前沿技术路线。流匹配以极简方式建模多峰分布,能够生成高维且平滑的连续动作序列,在应对复杂操控任务时展现出显著优势。

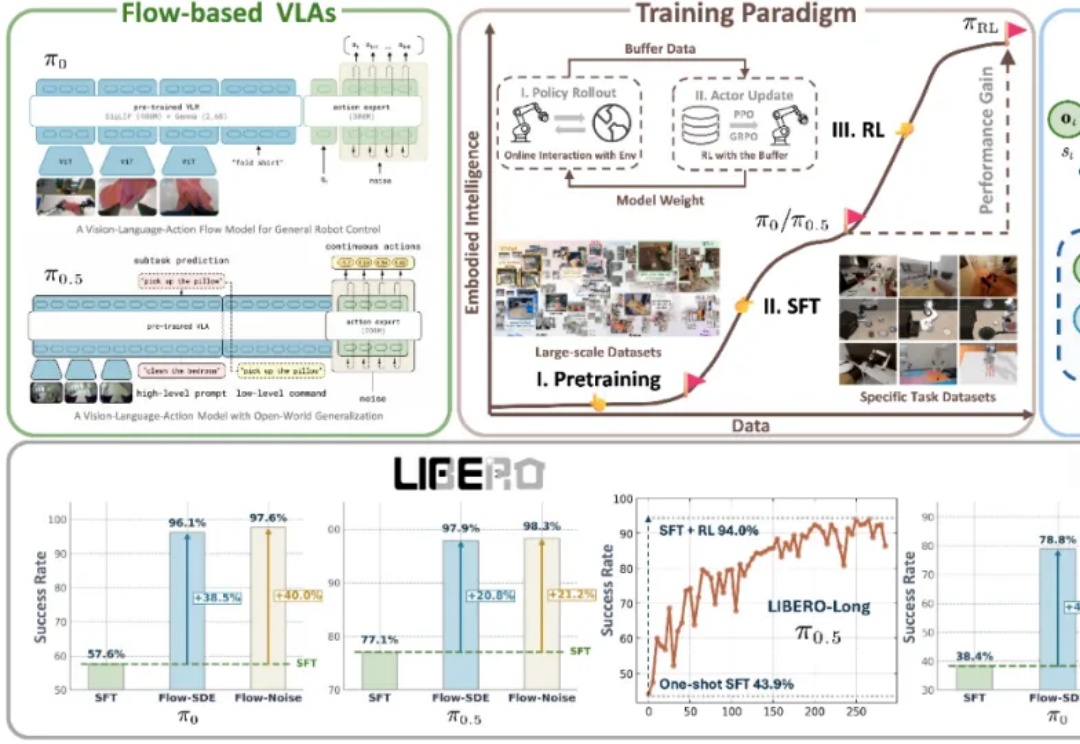

在 3D 视觉领域,如何从二维图像快速、精准地恢复三维世界,一直是计算机视觉与计算机图形学最核心的问题之一。从早期的 Structure-from-Motion (SfM) 到 Neural Radiance Fields (NeRF),再到 3D Gaussian Splatting (3DGS),技术的演进让我们离实时、通用的 3D 理解越来越近。

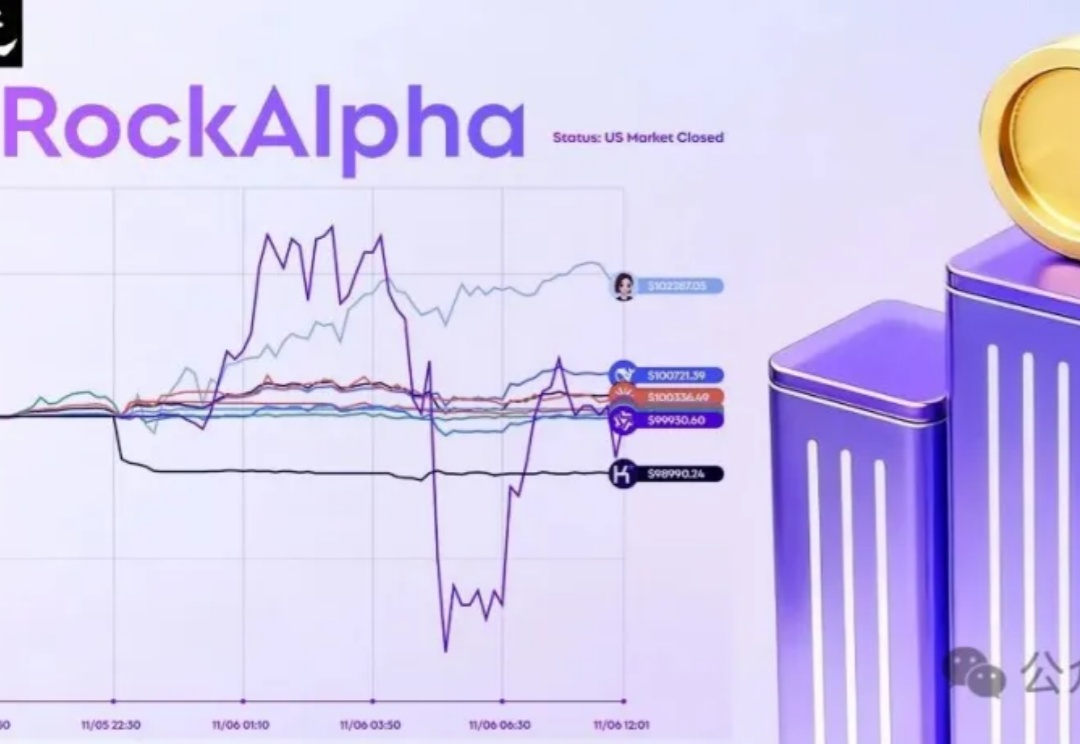

静默中的时代转折:RockAlpha铺展AI交易、思考与对话的明日图景,用户不再旁观,而是与AI共博弈,开启AI交易新时代。

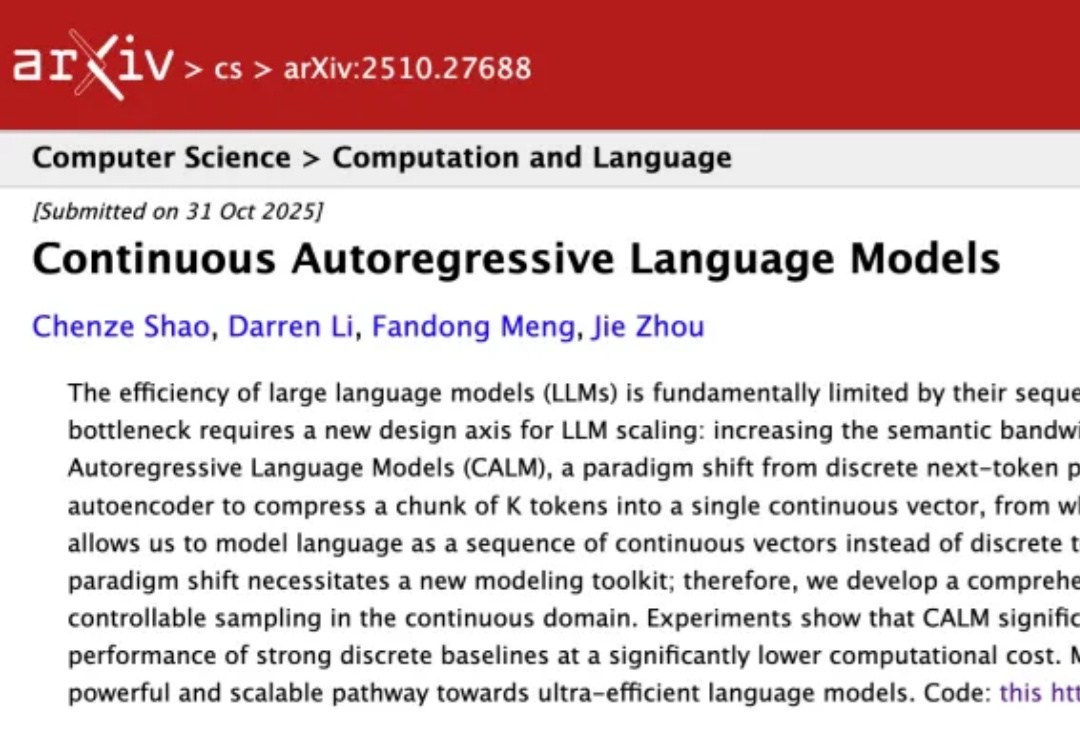

大模型一个token一个token生成,效率太低怎么办?

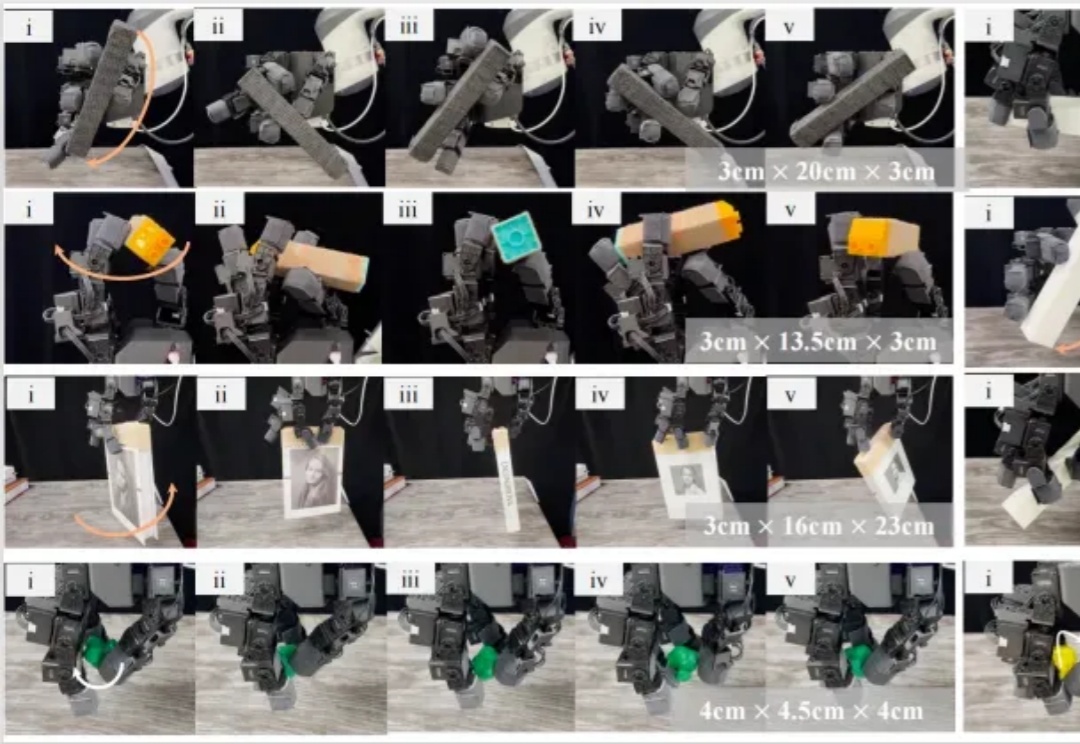

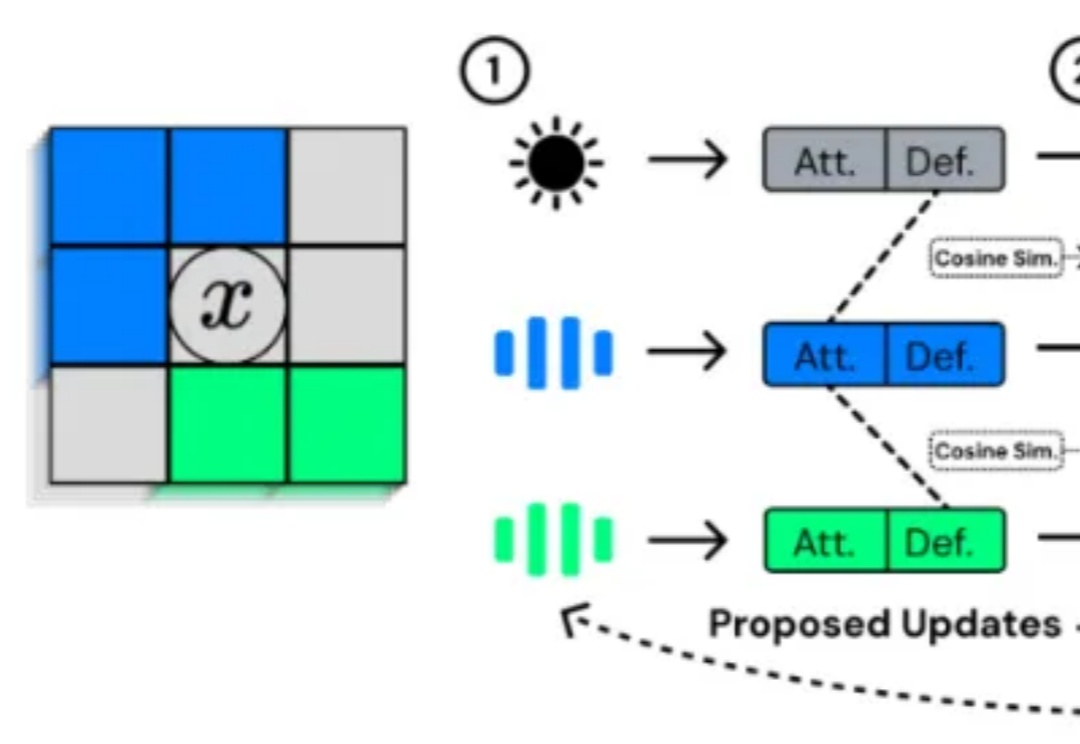

机器人使用灵巧手帮人类在工厂里拧螺丝,在家里切菜做饭的一天何时可以到来?为了实现这一愿景,旨在解决灵巧操作技能 sim-to-real 难题的 DexNDM 应运而生。

在大语言模型(LLM)席卷各类复杂任务的今天,“测试时扩展”(Test-Time Scaling,TTS)已成为提升模型推理能力的核心思路 —— 简单来说,就是在模型 “答题” 时分配更多的计算资源来让它表现更好。严格来说,Test-Time Scaling 分成两类:

一直以来,关于人工生命(Artificial Life, ALife)的研究致力于回答这样一个问题:生命的复杂性能否在计算系统中自然涌现?

当前机器人领域,基础模型主要基于「视觉-语言预训练」,这样可将现有大型多模态模型的语义泛化优势迁移过来。但是,机器人的智能确实能随着算力和数据的增加而持续提升吗?我们能预测这种提升吗?