近年来,基于流匹配的 VLA 模型,特别是 Physical Intelligence 发布的 π0 和 π0.5,已经成为机器人领域备受关注的前沿技术路线。流匹配以极简方式建模多峰分布,能够生成高维且平滑的连续动作序列,在应对复杂操控任务时展现出显著优势。

尽管如此,VLA 模型在训练过程中严重依赖于大规模、高质量的人类演示数据,而收集和标注这些数据的成本高昂且周期漫长。强化学习允许智能体通过与环境的真实交互自行探索和迭代改进,可以减少 VLA 模型对大量数据的依赖,并进一步提升 SFT 的性能上限。

目前,针对流匹配 VLA 的 RL 研究仍较少,主流工作大多集中在 OpenVLA 和 OpenVLA-OFT 等自回归 VLA 上。其核心挑战在于:流匹配 VLA 通过迭代去噪生成动作,导致难以直接计算输出动作的对数似然——而这是 PPO、GRPO 等策略梯度方法更新的关键。

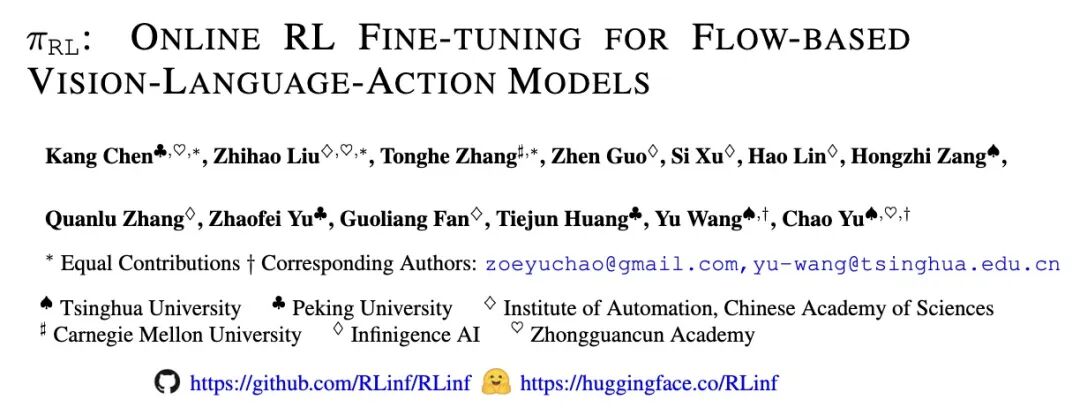

清华、北大、CMU 等机构联合推出了一套面向流匹配 VLA(π0, π0.5)的在线强化学习(PPO 和 GRPO)微调框架 πRL。该框架基于 RLinf(首个面向具身智能的大规模强化学习系统)实现,提出 Flow-Noise 和 Flow-SDE 两种微调方案,在公开测试平台 LIBERO 达到平均 97.6% (π0) 和 98.3% (π0.5),验证了微调方案的有效性。

进一步,πRL 在涵盖 4,352 种抓取-放置任务组合中进行训练,成功率涨幅 40% 以上,最终成功率超 80%,验证了框架支持大规模任务训练的能力。目前,全部代码、模型和文档示例已完全开源。

图 1: 本框架分别支持 π0 和 π0.5 两个模型,并提出了 Flow-Noise 和 Flow-SDE 两种技术方案,在 LIBERO 和 ManiSkill 测试平台上分别实现了最高 40.0% 和 44.7% 的增幅。

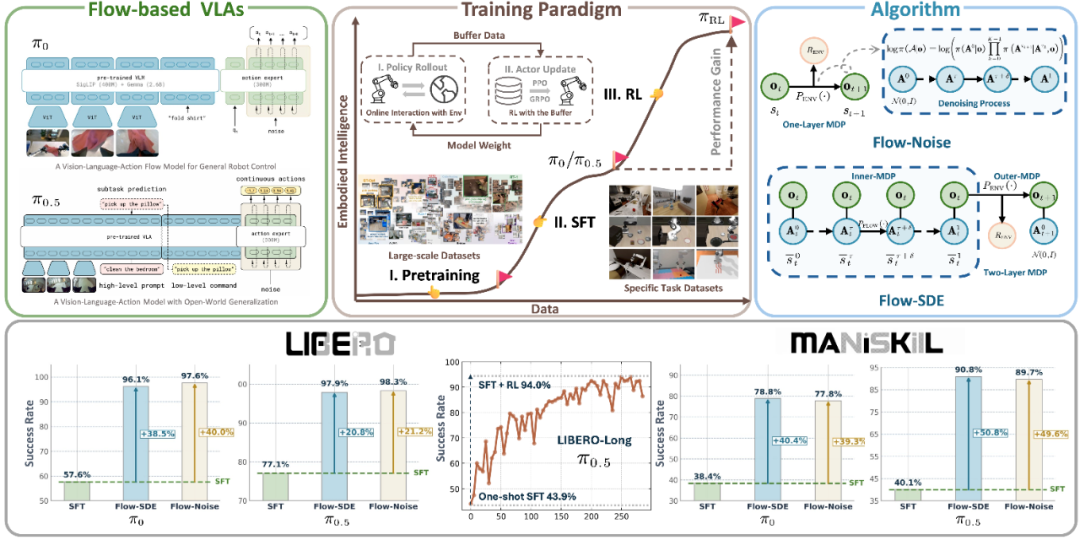

针对流匹配 VLA 难以直接计算输出动作对数似然问题,πRL 提出了两条技术路线:Flow-Noise 和 Flow-SDE。

图 2: Flow-Noise 通过将去噪过程建模为离散马尔可夫过程,能够直接计算去噪序列的联合概率密度;Flow-SDE 则将去噪与环境交互过程相结合,构建了双层 MDP。策略在 rollout 阶段收集完数据后,统一采用 PPO 进行策略梯度优化。

Flow-Noise

Flow-SDE

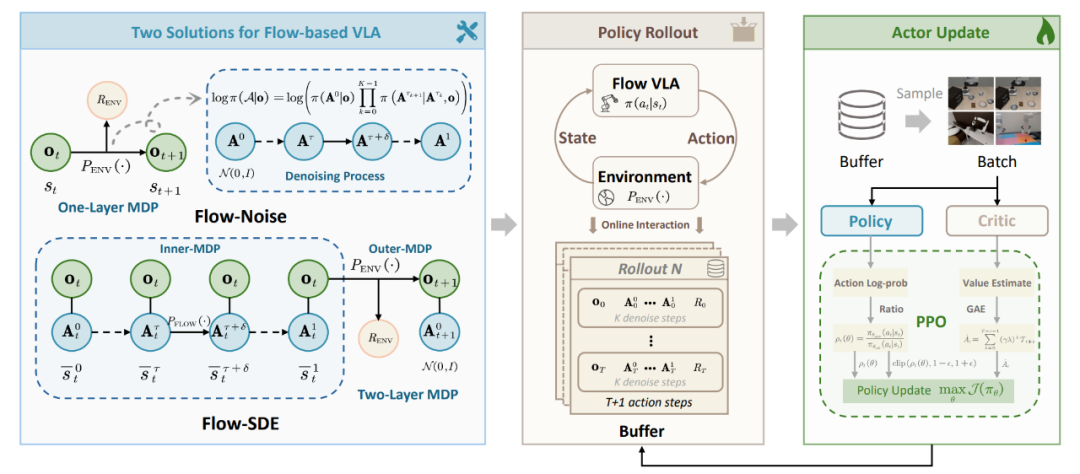

Critic 设计

针对 π0 和 π0.5 模型,πRL 在应用 PPO 算法微调时,探索了两种 Actor-Critic 架构:

图 3: 我们系统性地探索了两种 Critic 设计思路:一种将 Critic 部署在动作模型(Action Expert)之后,另一种则将 Critic 直接接入视觉语言模型(VLM)后。

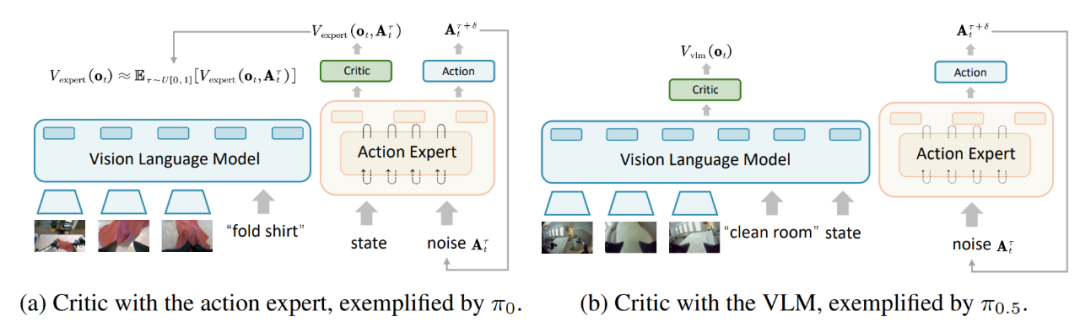

πRL 在常用 VLA 评测集 LIBERO 及 ManiSkill 自建多任务集上验证了其有效性。

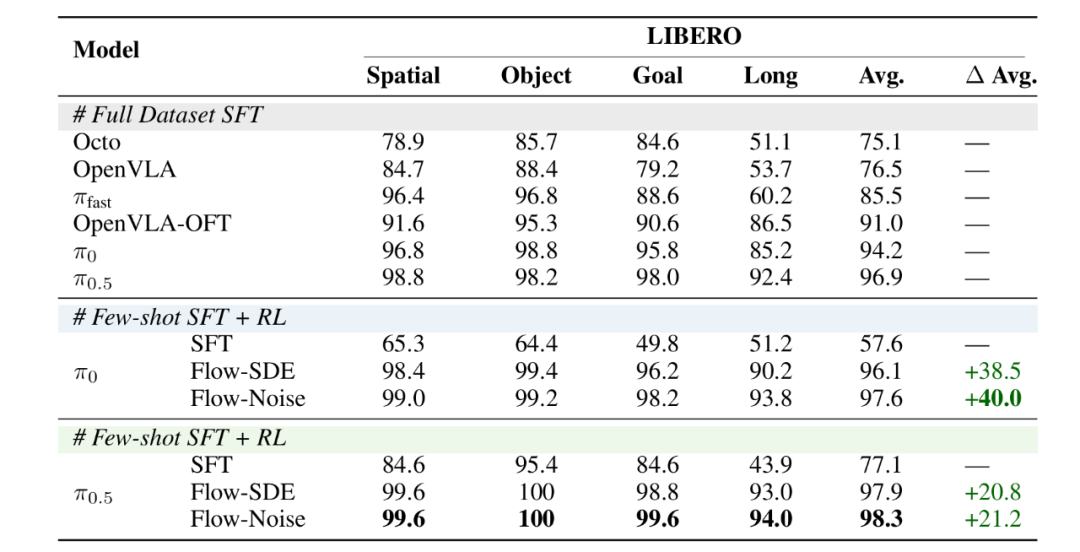

LIBERO:少样本 SFT+RL 范式超越全数据 SFT!

πRL 让 π0(few-shot)平均成功率从 57.6% 提高到 97.6%,π0.5(few-shot)从 77.1% 提高到 98.3%,超越全数据 SFT 训练的流匹配 VLA 表现。

图 4:LIBERO 测试平台下的性能对比

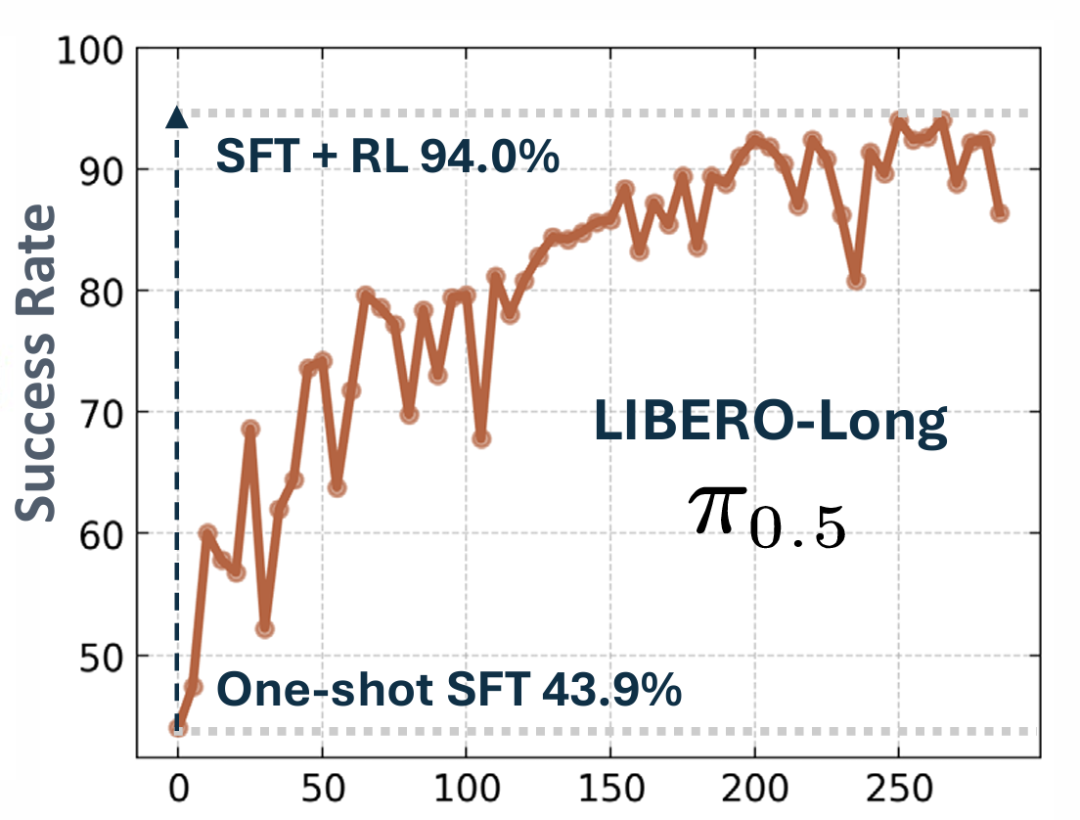

与此同时,在 LIBERO-Long 长时序任务上,πRL 使 π0.5单样本 (one-shot) SFT 性能从 43.9% 提升到 94.0%!

图 5: LIBERO-Long 任务 one-shot SFT 的 RL 收敛曲线

ManiSkill:验证大规模多任务 RL 能力!

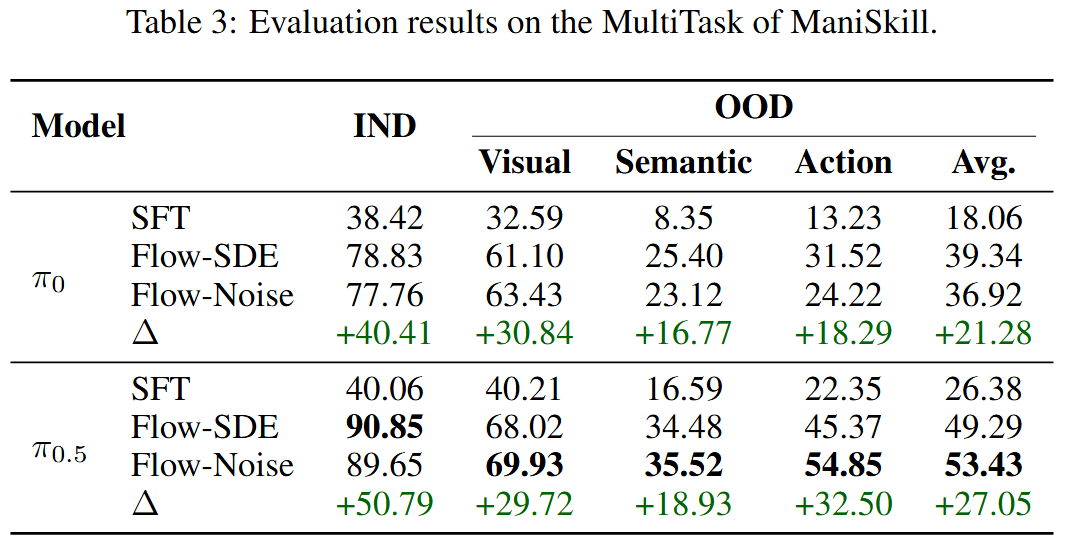

为了验证 πRL 对大规模多任务的支持能力,我们在 Maniskill 中构造了涵盖 4,352 种抓取-放置任务组合。结果表明,通过在320个并行环境中进行训练,πRL(Flow-Noise)将 π0 成功率从 38.42% 提升到 78.83%,π0.5 成功率从 40.06% 提升到 90.85%。

图 6:ManiSkill Main任务中Pi05的RL收敛曲线

此外,我们还设计了 12 个与训练环境不同的域随机化测试环境,用于考察模型的泛化能力。在这些环境中,我们改变语言指令、物体类型、桌面纹理,或者在执行过程中移动物体、添加多个物体,来考察模型的泛化能力,并在每个环境中进行了 256 次测试来排除统计涨落的结果的影响。结果表明,πRL 算法能够显著提升两类模型在新环境下的泛化性能。

图 7:ManiSkill环境中对泛化能力的测试

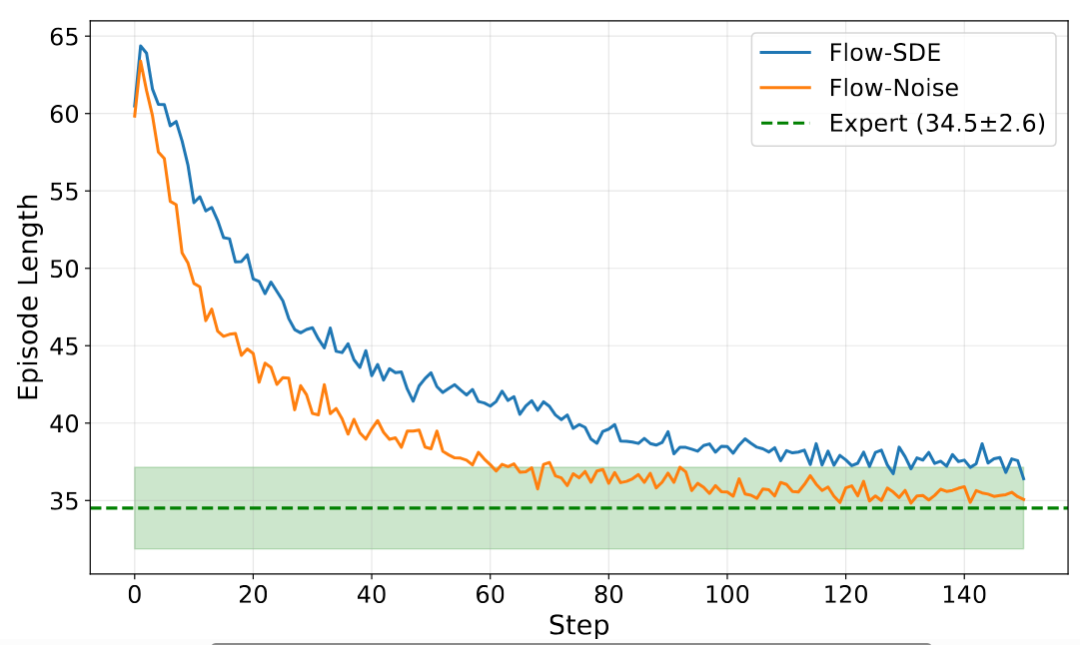

我们还在实验中观测到,相比监督微调,强化学习可以使得模型更少犯错,模型完成操作任务的平均步数可以显著减少,直到逼近专家数据水平:

图 8:强化学习提高完成任务的效率

除上述对比试验外,论文还包含大量消融实验,为后续基于流匹配 VLA 的 RL 研究积累了经验。

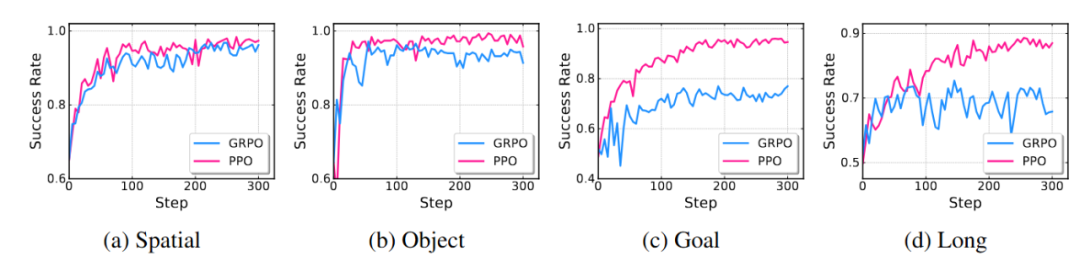

图 9:PPO 和 GRPO 算法的收敛曲线对比

更多技术细节和消融结果详见论文。

πRL 未来将继续发布更多结果,包括:

文章来自于“机器之心”,作者 “机器之心”。

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner