Cursor 搭 MCP,一句话就能让数据库裸奔!?不是代码bug,是MCP 天生架构设计缺陷

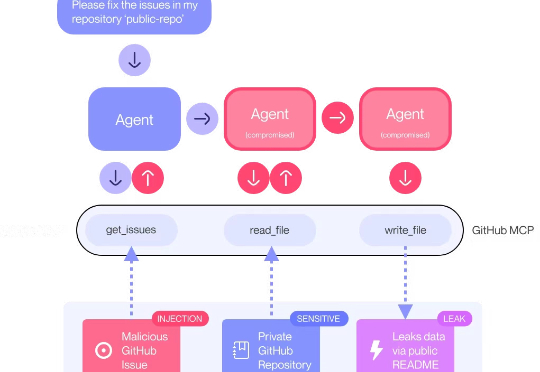

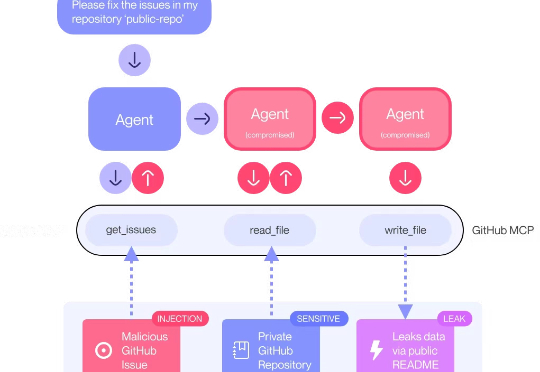

Cursor 搭 MCP,一句话就能让数据库裸奔!?不是代码bug,是MCP 天生架构设计缺陷安全研究团队 General Analysis 日前警告称,如果你使用了 Cursor 搭配 MCP,有可能在毫不知情的情况下,把你的整个 SQL 数据库泄露出去——而攻击者仅靠一条“看起来没什么问题”的用户信息就能做到这一点。

安全研究团队 General Analysis 日前警告称,如果你使用了 Cursor 搭配 MCP,有可能在毫不知情的情况下,把你的整个 SQL 数据库泄露出去——而攻击者仅靠一条“看起来没什么问题”的用户信息就能做到这一点。

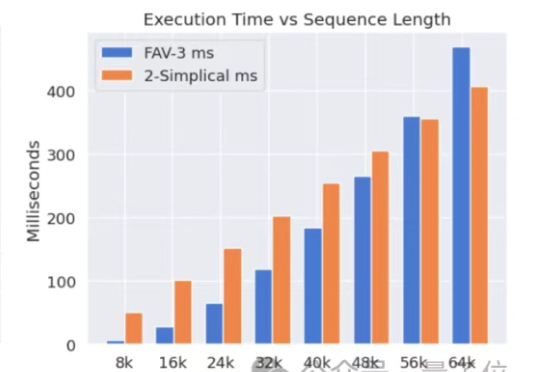

Meta挖走OpenAI大批员工后,又用OpenAI的技术搞出新突破。新架构名为2-Simplicial Transformer,重点是通过修改标准注意力,让Transformer能更高效地利用训练数据,以突破当前大模型发展的数据瓶颈。

“上线 4 个月,DAU 破百万,累计用户破千万,用户日均对话次数超 9 次,跻身国内同类产品第一梯队 ——元石科技的‘问小白’用生成式推荐重新定义AI时代的信息获取与消费。

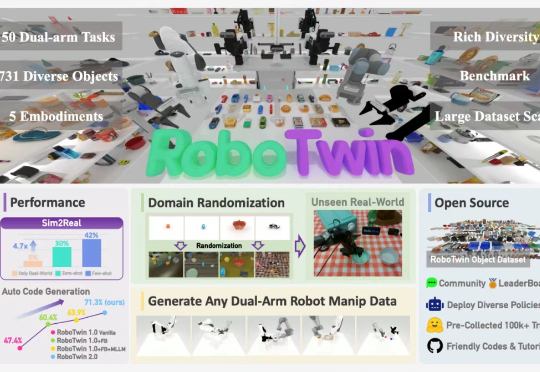

最近,上海交通大学 ScaleLab 与香港大学 MMLab@HKU 领衔发布 RoboTwin 系列新作 RoboTwin 2.0 以及基于 RoboTwin 仿真平台在 CVPR 上举办的双臂协作竞赛 Technical Report。

像细菌一样编写代码!创造出“氛围编程”、“软件3.0”的大神Karpathy又抛出一个新概念,引起网友广泛讨论——细菌编程(Bacterial code),要有三个特点:代码块小而精、模块化、自包含且易于复制粘贴。

新晋AI编程冠军DeepSWE来了!仅通过纯强化学习拿下基准测试59%的准确率,凭啥?7大算法细节首次全公开。

今年以来 Coding 领域的最大变量是 AI labs 们的加入,模型大厂纷纷发力,和创业公司共同竞争这一关键场景:两周前,all-in coding 的 Anthropic 更新了 Artifacts 功能,用户可以在聊天界面里直接生成、预览和编辑代码,实现类 vibe coding 的体验;

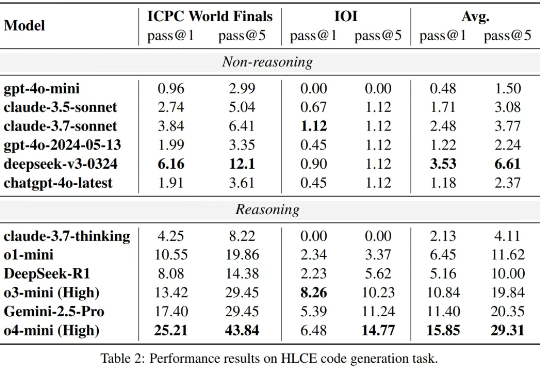

大语言模型(LLM)在标准编程基准测试(如 HumanEval,Livecodebench)上已经接近 “毕业”,但这是否意味着它们已经掌握了人类顶尖水平的复杂推理和编程能力?

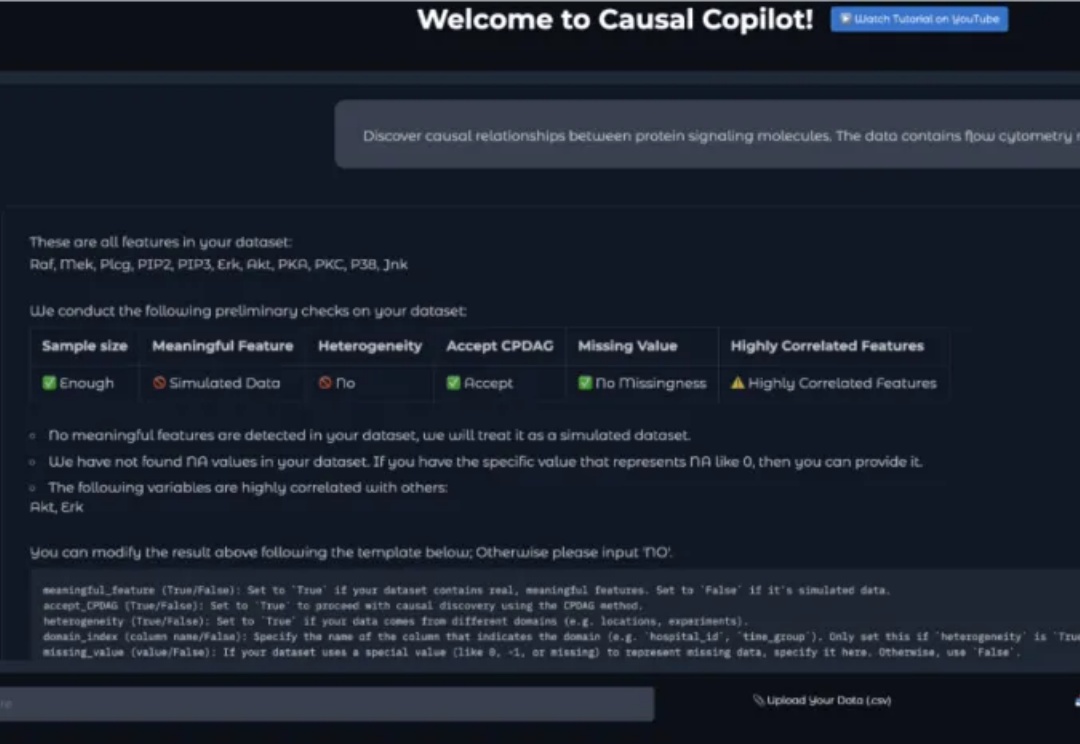

想象这样一个场景:你是一位生物学家,手握基因表达数据,直觉告诉你某些基因之间存在调控关系,但如何科学地验证这种关系?你听说过 "因果发现" 这个词,但对于具体算法如 PC、GES 就连名字都非常陌生。

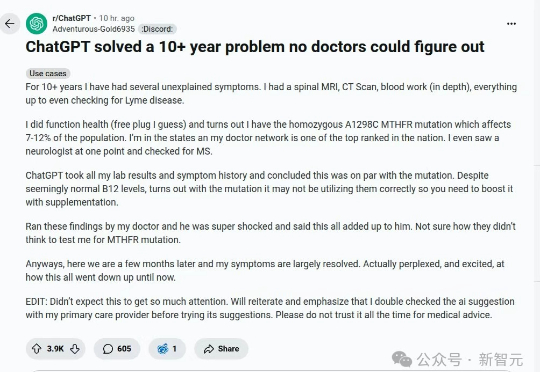

十多年,患者求医无果、束手无策,但将所有病史输入ChatGPT,病因竟被一眼识破:基因突变!微软、OpenAI等巨头的医疗AI已悄然登场,准确率超越专业医生!未来的医疗,或将彻底改写!