AI搜索一夜变天,专为Agent做搜索的赛道能否诞生百亿美金新巨头?

AI搜索一夜变天,专为Agent做搜索的赛道能否诞生百亿美金新巨头?ChatGPT刚刚给火热的Agent市场添把柴,这边AI搜索市场却要变天。Bing Search API将于8月11日关停,所有Bing Search API都将完全停用,同时不再接受新用户注册。

ChatGPT刚刚给火热的Agent市场添把柴,这边AI搜索市场却要变天。Bing Search API将于8月11日关停,所有Bing Search API都将完全停用,同时不再接受新用户注册。

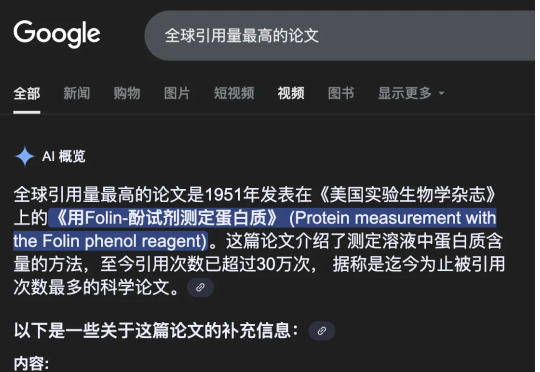

如何让AI像人一样,仅凭少量演示,就能稳健适应复杂多变的真实场景? 美国东北大学和波士顿动力RAI提出了HEP(Hierarchical Equivariant Policy via Frame Transfer)框架,首创“坐标系转移接口”,让机器人学习更高效、泛化更灵活。

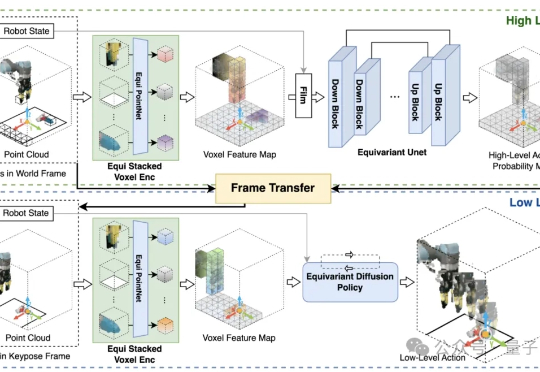

Kimi 又火了,在 DeepSeek 的热闹中沉寂大半年后,Kimi K2 悄悄在 LMArena 竞技场中从 DeepSeek 手中,夺过了全球开源第一的宝座。

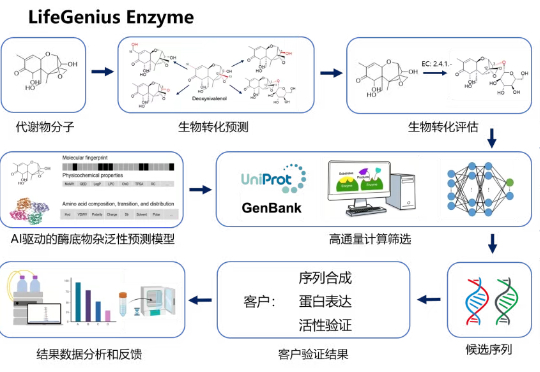

AI合成生物有用吗?究竟用在哪? 近日,美国头部市场咨询公司Lux Research发表了一篇名为《AI in Synthetic Biology: Necessary or Nice to Have?》的文章。

谷歌搜索迎来三大AI革新:集成最强Gemini 2.5 Pro模型、Deep Search功能随便用、最引人注目的是AI代打电话功能。目前功能在美国上线,未来将全球推广。

大家好我是歸藏(guizang),今天给大家带来秘塔深度研究的体验。

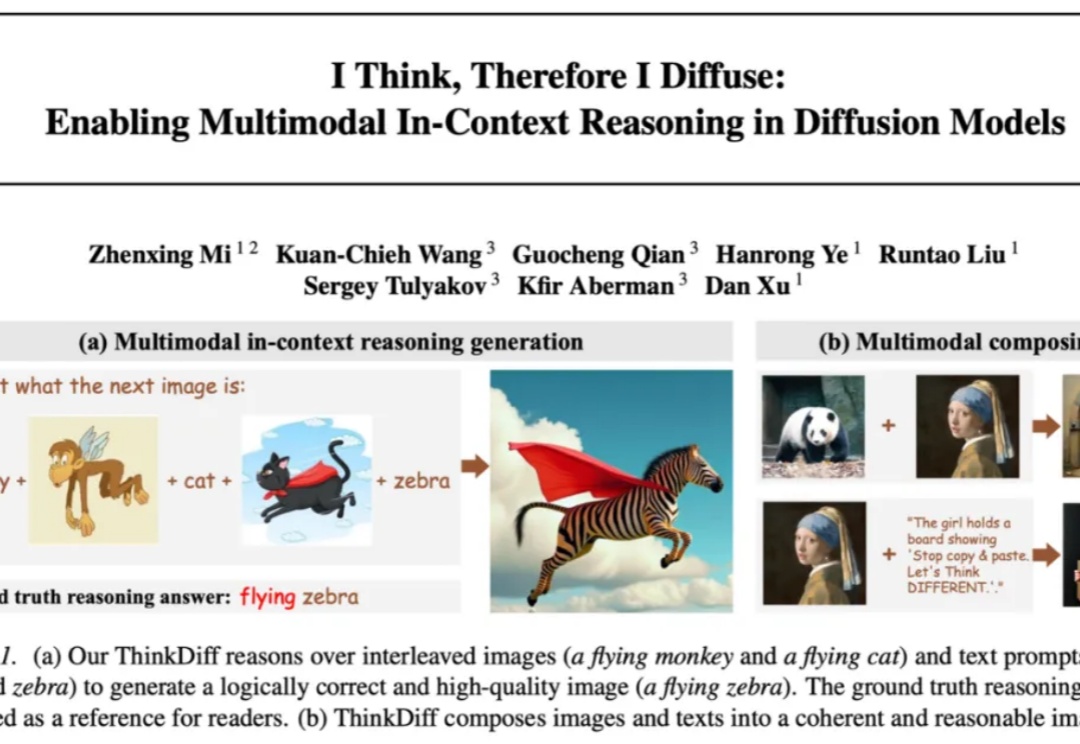

自 Stable Diffusion、Flux 等扩散模型 (Diffusion models) 席卷图像生成领域以来,文本到图像的生成技术取得了长足进步。但它们往往只能根据精确的文字或图片提示作图,缺乏真正读懂图像与文本、在多模 态上下文中推理并创作的能力。能否让模型像人类一样真正读懂图像与文本、完成多模态推理与创作,一直是学术界和工业界关注的热门问题。

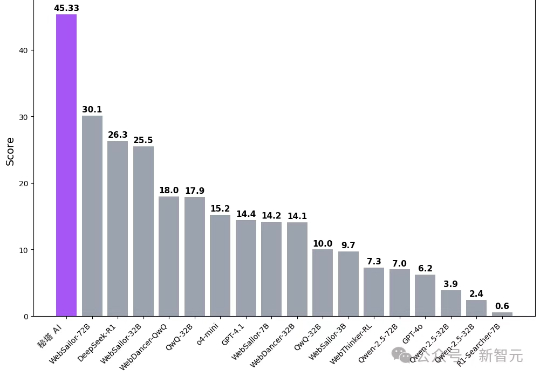

刚刚,国内首个免费可用Deep Research上线了!它在多个权威评测中拿下第一,准确率直接碾压开源WebSailor。研究过程中,它能多线迭代追搜,直至逻辑闭环。更绝的是,一键生成炫酷的互动研究报告,视觉效果直接拉满。

太卷了,卷麻了! 对标海外的Deep Research(深度研究)功能,现在咱国内,免费,想咋用就咋用。

昨天晚上,秘塔AI搜索悄悄上了一个新功能。测试完以后,我觉得这玩意,还是值得我将近通宵写一篇的。