摆脱Transformer依赖?这家AI初创公司推出国内首个非Attention机制大模型

摆脱Transformer依赖?这家AI初创公司推出国内首个非Attention机制大模型以大规模著称的Transformer,在实际应用中的高算力和高成本,让不少中小型企业望而却步。

来自主题: AI资讯

6888 点击 2024-01-28 12:05

以大规模著称的Transformer,在实际应用中的高算力和高成本,让不少中小型企业望而却步。

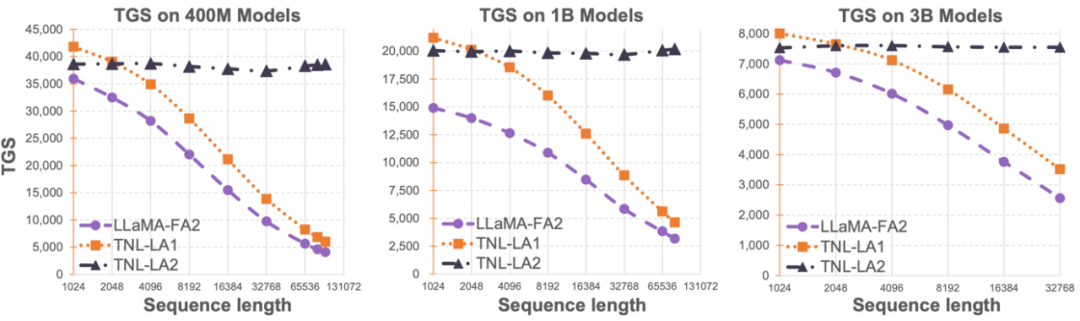

Lightning Attention-2 是一种新型的线性注意力机制,让长序列的训练和推理成本与 1K 序列长度的一致。

Hyena处理长序列输入比FlashAttention速度高100倍!最新发布的StripedHyena模型可能成下一代AI架构的新标准?

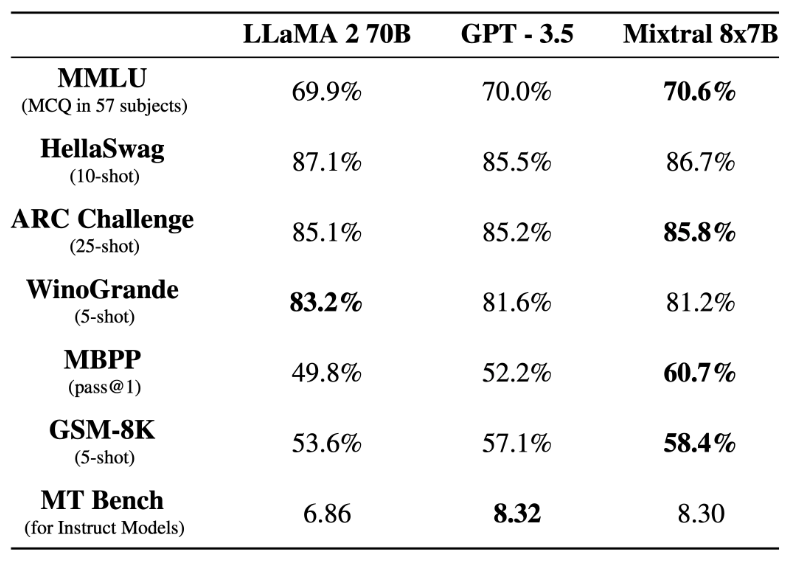

前段时间,Mistral AI 公布的 Mixtral 8x7B 模型爆火整个开源社区,其架构与 GPT-4 非常相似,很多人将其形容为 GPT-4 的「缩小版」。

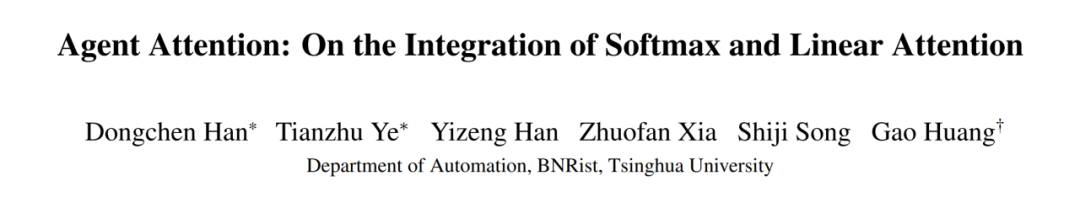

来自清华大学的研究者提出了一种新的注意力范式——代理注意力 (Agent Attention)。

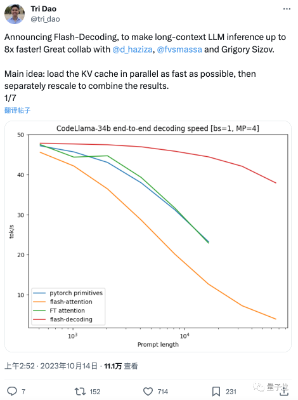

这两天,FlashAttention团队推出了新作: 一种给Transformer架构大模型推理加速的新方法,最高可提速8倍。 该方法尤其造福于长上下文LLM,在64k长度的CodeLlama-34B上通过了验证