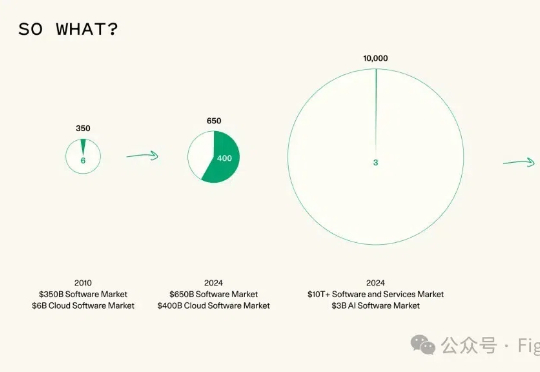

Agentic AI基金会成立,智能体的“Linux时刻”来了!MCP、AGENTS.md集体上车,下一代AI技术栈PARK出世

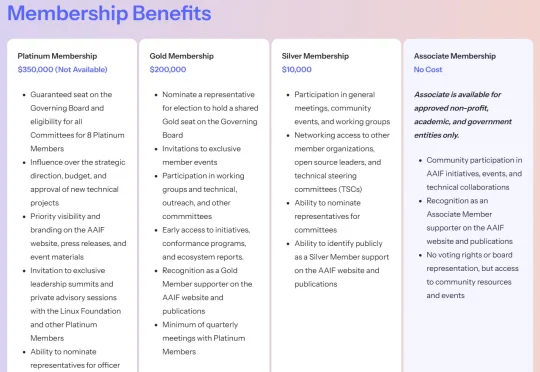

Agentic AI基金会成立,智能体的“Linux时刻”来了!MCP、AGENTS.md集体上车,下一代AI技术栈PARK出世刚刚,Linux 基金会正式宣布推出智能体 AI 基金会(Agentic AI Foundation,简称 AAIF)。据公告披露,AAIF 定位为 AI 智能体(AI agents)相关开源项目的中立托管平台,全球几乎所有科技巨头均已签约成为该基金会成员。Anthropic、OpenAI 与 Block 三家公司作为联合创始成员,将贡献三大开源项目,构成基金会启动初期的支柱。