救命!AI浏览器都卷成这样了,怎么大家还是用Chrome啊?

救命!AI浏览器都卷成这样了,怎么大家还是用Chrome啊?浏览器之争已不单是速度对决!新玩家Atlas与Comet能替你订票购物,AI代理时代已至;然而老大哥Chrome凭71%份额稳坐钓鱼台。未来,是拥抱全能助手的便捷,还是警惕安全漏洞的深渊?决胜局就在此刻!

浏览器之争已不单是速度对决!新玩家Atlas与Comet能替你订票购物,AI代理时代已至;然而老大哥Chrome凭71%份额稳坐钓鱼台。未来,是拥抱全能助手的便捷,还是警惕安全漏洞的深渊?决胜局就在此刻!

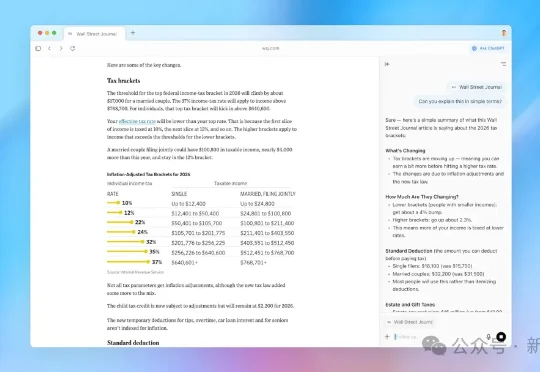

电商巨头和新锐 AI 公司的对撞,正在加州联邦法院拉开帷幕。亚马逊正式起诉 Perplexity AI,矛头直指其“Comet”浏览器与背后的智能代理(AI agent)。 指控要点包括:在亚马逊平台上伪装成人类用户、通过用户的私密账户进行自动化操作,涉嫌违反《计算机欺诈与滥用法》(CFAA)。

OpenAI Atlas、Perplexity Comet等AI浏览器的推出,虽提升了网页自动化效率,却也使智能爬虫威胁加剧。南洋理工大学团队研发的WebCloak,创新性地混淆网页结构与语义,打破爬虫技术依赖,为数据安全筑起轻量高效防线,助力抵御新型智能攻击,守护网络安全。

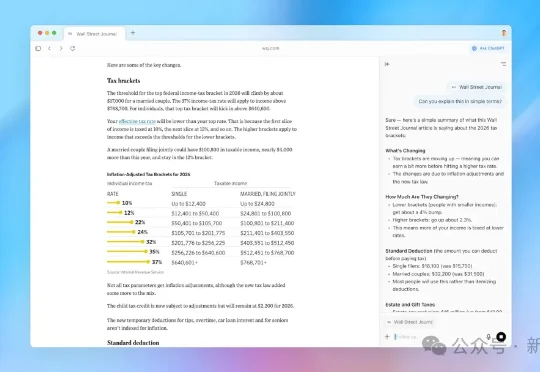

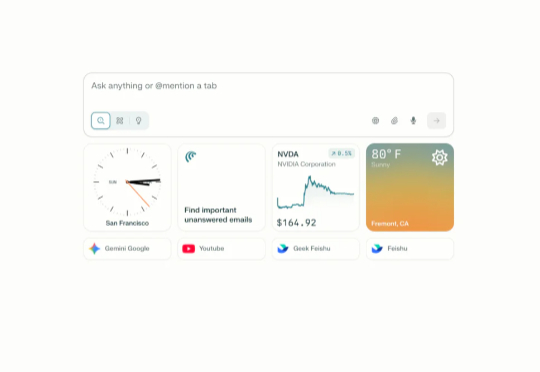

过去一周,我把主流 AI 浏览器都体验了个遍。 OpenAI 的 Atlas、Perplexity 的 Comet、Browser Company 的 Dia,再加上 Edge Copilot,市面上最火的 AI 浏览器,各有各的亮点,也各有各的坑。浏览器的未来长啥样?这些产品给出了完全不同的答案。

智东西8月26日报道,近日,美国浏览器公司Brave发布博客,称该公司在美国知名AI搜索独角兽Perplexity打造的AI浏览器Comet中发现了一个严重安全漏洞,攻击者可通过在网页中发布恶意指令,来操纵AI浏览器登录网站、访问邮箱、获取验证码,并将这些敏感信息发送给外部攻击者。全程耗时两分半,连普通人也能完成这种攻击。

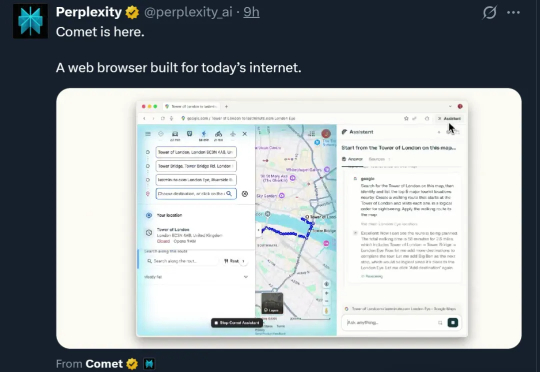

今年 6 月,The Browser Company 向 Arc 用户开放了浏览器 Dia 的 Beta 测试。上个月,Perplexity 新推出了自己的 AI 原生浏览器 Comet,随后 OpenAI 也宣布计划在未来几周发布浏览器。

如果每个人都必须做广告,谷歌总是会赢。如果AI赚钱的新方式还是通过关键词或提示来投放广告——那他们就会赢。他们拥有所有的广告网络。它基本上是一个黑手党。广告是如此的黑手党行业,你甚至不想去与现有的竞争者对抗。

最近,AI浏览器这个赛道,好像还蛮热的。

AI浏览器的战争开打到今天,从早期的Arc试图重塑交互,到Opera Neon展现的“代理”能力,再到传闻中OpenAI即将推出的浏览器,每一个行业重量级参与者,都在试图重新定义这个我们最熟悉的互联网入口。

这不,英伟达投资的Perplexity就推出了自己的AI浏览器——Comet,号称专为当今互联网打造。这家AI搜索起家的独角兽,又要挑战谷歌另一个垄断领域了。而且不止它盯上了这块蛋糕,据路透社爆料,OpenAI也将在未来几周内发布一款AI浏览器。