再见,人类程序员!OpenAI自曝:一行代码都不写了,100%用Codex

再见,人类程序员!OpenAI自曝:一行代码都不写了,100%用Codex100%是用Codex写的。还有内部爆料说,Codex让他们仅用三天时间就搭出了服务器,三周就发布了APP。人类程序员,真的要退出历史舞台了?

100%是用Codex写的。还有内部爆料说,Codex让他们仅用三天时间就搭出了服务器,三周就发布了APP。人类程序员,真的要退出历史舞台了?

大家好,我是最近天天折腾CLI Agent的袋鼠帝。 一周前,我给大家安利了一款Claude Code的最强开源对手:OpenCode,没想到文章发出去后反响这么热烈,不管是阅读量还是评论都非常多。刚好,前几天我看到腾讯的CodeBuddy Code重磅升级到了2.0版本。说实话,CodeBuddy Code我有用过,基本完全复刻Claude Code,之前还帮我开发了好几个小工具,很实用。

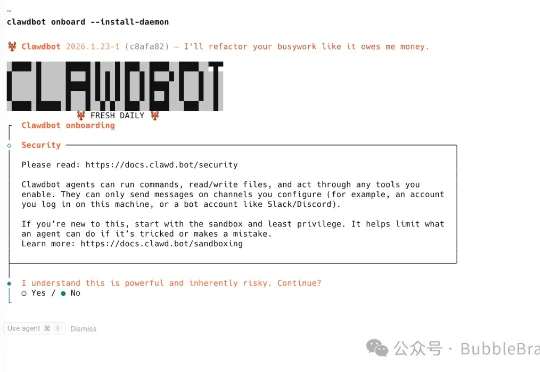

家人们, 昨天下午我高兴的刷着X,突然发现时间线上好多中文博主开始疯狂推Clawdbot了。说回Clawdbot,这就是你现在能用到的最好的超级助理,简单来说就是Claude Code + 即时通讯。但因为权限的问题,仍然不建议随便使用这玩意!

一个曾被Cursor官方盖章认定的全球前0.01%顶级玩家,却在Claude Code 2.0发布后果断「倒戈」!这不只是换工具,而是底层的游戏规则已经悄悄换了。

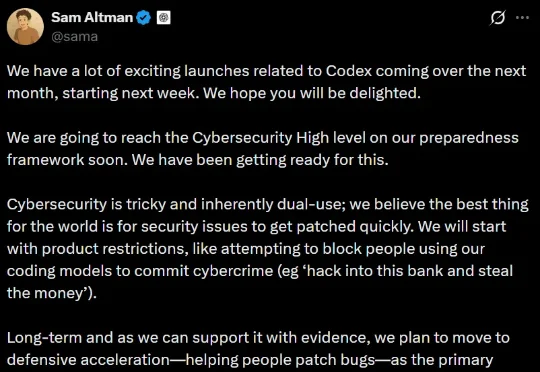

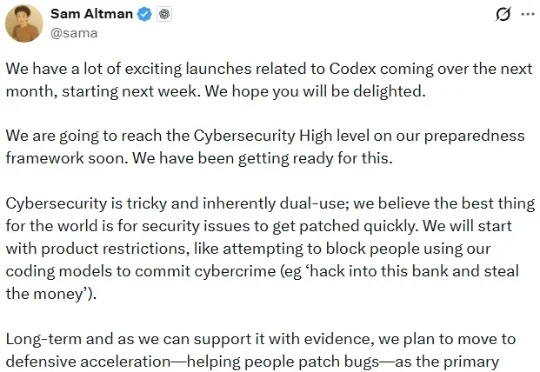

刚刚,奥特曼发出预警:一周后Codex全家桶就要来了,但它们极其危险,以至于网络安全评级已经到达高级别!这些模型极可能打破现有的网络攻防平衡,导致攻击数量激增,甚至能帮你抢银行。

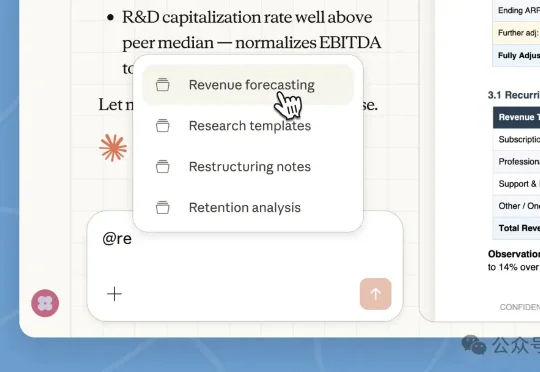

Claude Cowork企业版,刚刚正式上线了!而且,Claude Code之父Boris Cherny还在40分钟访谈中,大方自曝了自己的私家配置,一连串硬核干货袭来,围观网友大呼过瘾!

刚刚,OpenAI CEO 山姆・奥特曼发了一条推文:「从下周开始的接下来一个月,我们将会发布很多与 Codex 相关的激动人心的东西。」他尤其强调了网络安全这个主题。

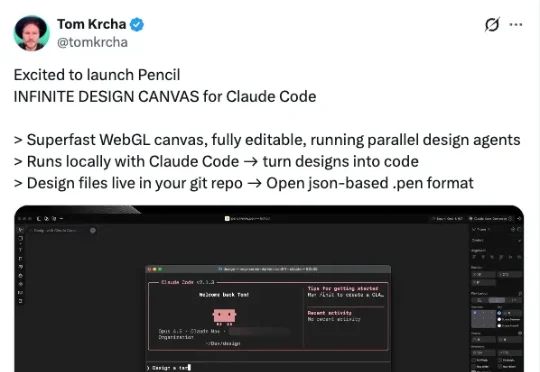

在看了Claude Code 能编码、写作、办公等等一系列操作后, 它终于还是把手伸到了设计领域。 昨天我正好刷到一个产品叫Pencil, 热度非常高。

扒光了这个黑客松冠军的 GitHub 仓库,我才发现自己根本不会用 Claude Code 最近很多人在后台问我 Claude Code 的使用技巧。说实话,大部分人的用法都太业余了。 如果你只是把

英伟达护城河要守不住了?Claude Code半小时编程,直接把CUDA后端迁移到AMD ROCm上了。 一夜之间,CUDA护城河被AI终结了? 这几天,一位开发者johnnytshi在Reddit上分享了一个令人震惊的操作: