DeepSeek精度效率双提升,华为&信工所提出思维链“提前退出”机制

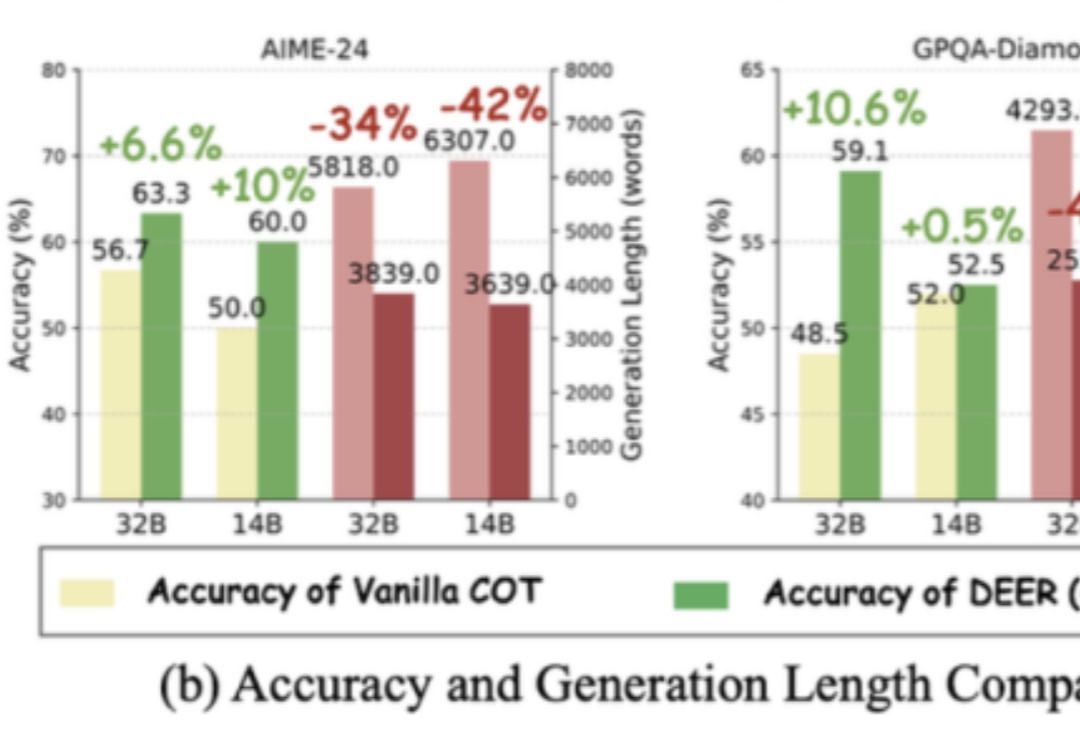

DeepSeek精度效率双提升,华为&信工所提出思维链“提前退出”机制长思维链让大模型具备了推理能力,但如果过度思考,就有可能成为负担。

来自主题: AI技术研报

8895 点击 2025-05-12 10:45

长思维链让大模型具备了推理能力,但如果过度思考,就有可能成为负担。

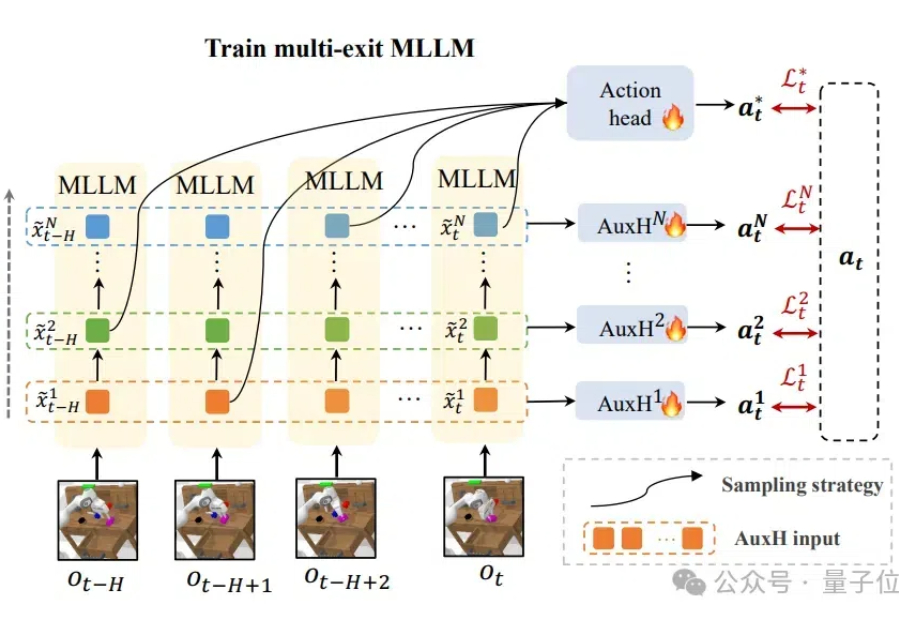

计算、存储消耗高,机器人使用多模态模型的障碍被解决了! 来自清华大学的研究者们设计了DeeR-VLA框架,一种适用于VLA的“动态推理”框架,能将LLM部分的相关计算、内存开销平均降低4-6倍。