DeepSeek用户慎入!体验完这款百万Tokens新"源神",我怕你回不去了【附5个神仙用法】

DeepSeek用户慎入!体验完这款百万Tokens新"源神",我怕你回不去了【附5个神仙用法】最近,我的AI交流群和别的一些AI群都炸锅了,话题的焦点是MiniMax-M1

最近,我的AI交流群和别的一些AI群都炸锅了,话题的焦点是MiniMax-M1

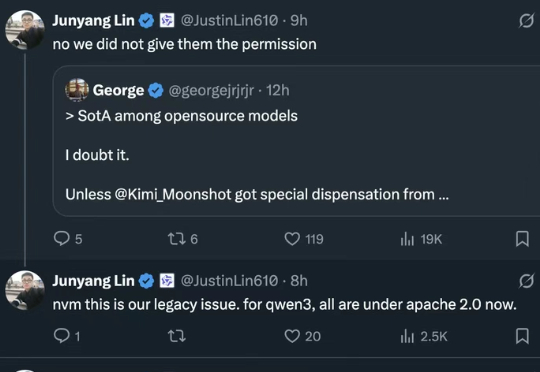

昨天深夜,月之暗面发布了开源代码模型Kimi-Dev-72B。这个模型在软件工程任务基准测试SWE-bench Verified上取得了60.4%的成绩,创下开源模型新纪录,超越了包括DeepSeek在内的多个竞争对手。

在开源模型领域,DeepSeek 又带来了惊喜。

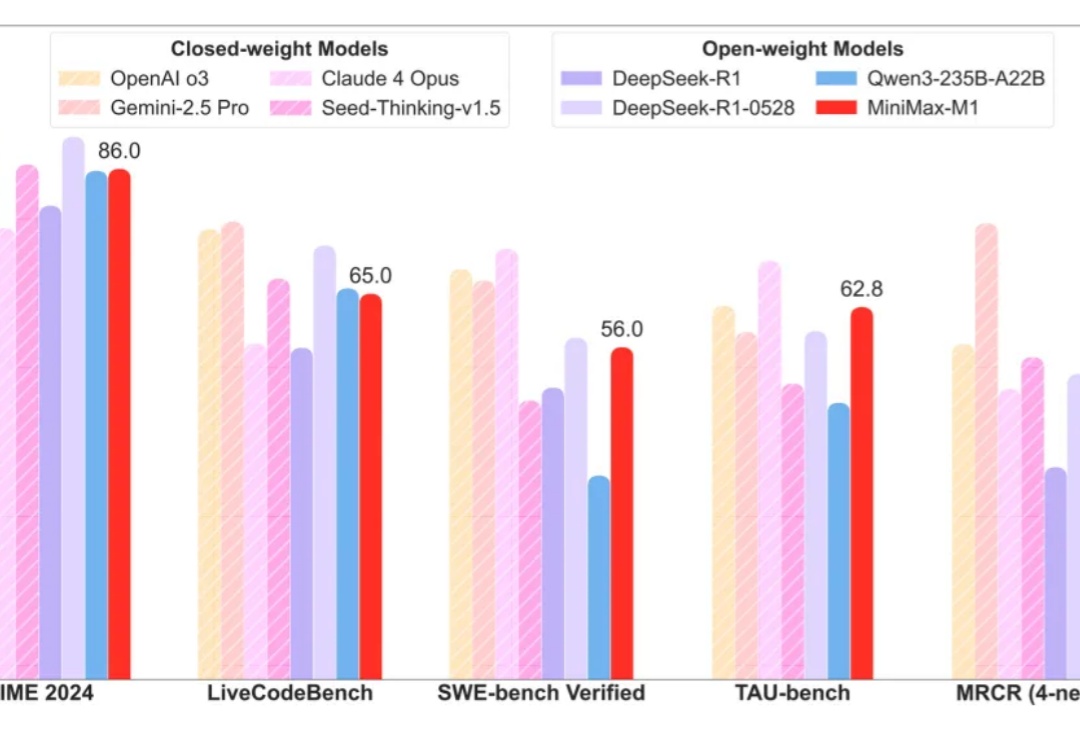

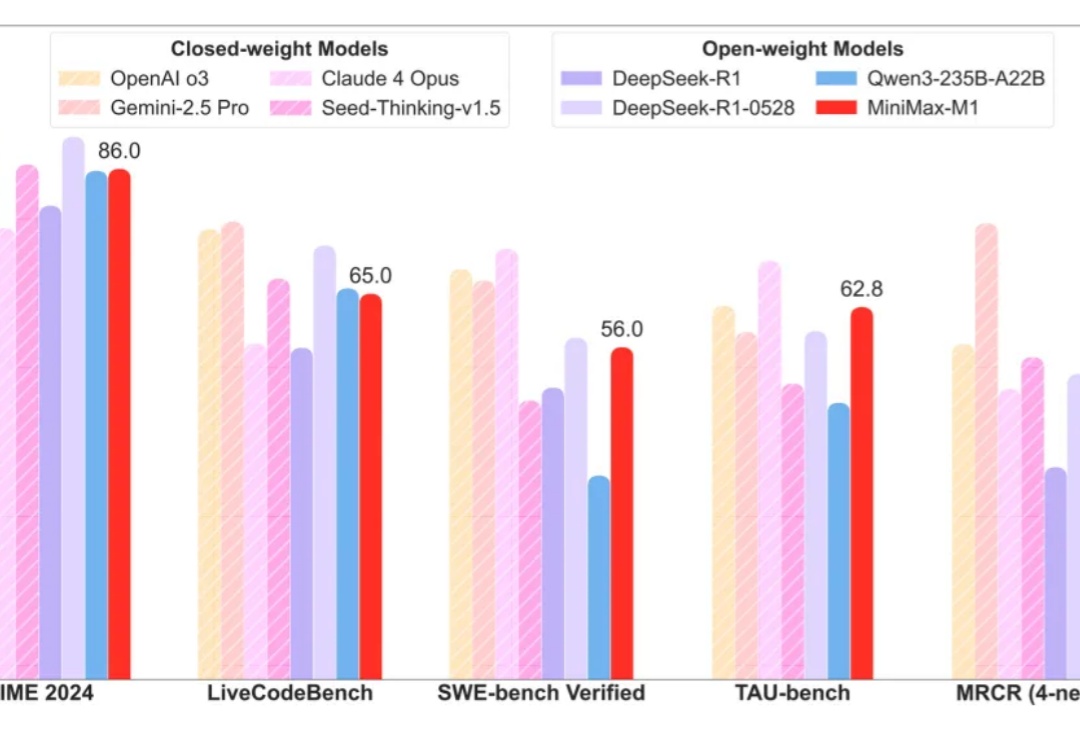

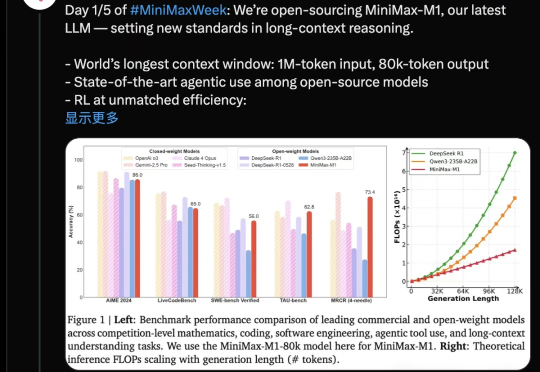

国产推理大模型又有重磅选手。MiniMax开源MiniMax-M1,迅速引起热议。

“蔚公子,DeepSeek核对两个Excel表格怎么做啊?”小伙伴上周问我。

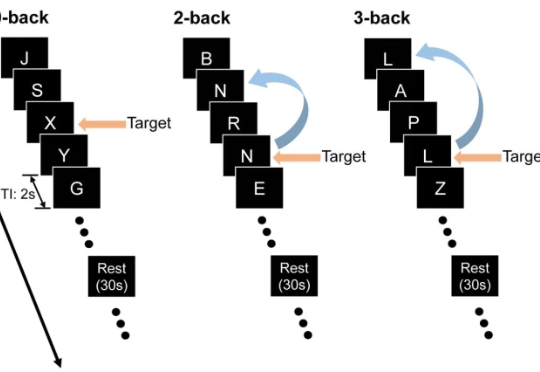

最近,来自约翰・霍普金斯大学与中国人民大学的团队设计了三套实验,专门把关键线索藏在上下文之外,逼模型「凭记忆」作答,从而检验它们是否真的在脑海里保留了信息。

Era of Experience 这篇文章中提到:如果要实现 AGI, 构建能完成复杂任务的通用 agent,必须借助“经验”这一媒介,这里的“经验”就是指强化学习过程中模型和 agent 积累的、人类数据集中不存在的高质量数据。

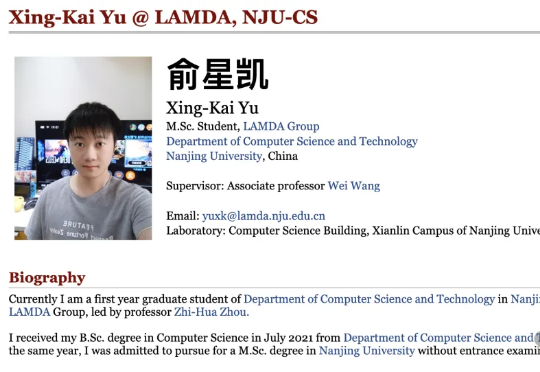

仅用不到1200行代码,实现最小化且完全可读的vLLM!DeepSeek研究员俞星凯搞了个开源项目引得大伙拍手叫绝。项目名为Nano-vLLM(纳米级-vLLM),有三大特点:快速离线推理:推理速度可与vLLM相媲美

4月份,李飞飞教授领先编制的《2025年人工智能指数报告》提供的数据显示,2024年全年具有特殊影响力的模型(Notable AI models)当中,排名前5的几乎都来自美国、中国的科技巨头。

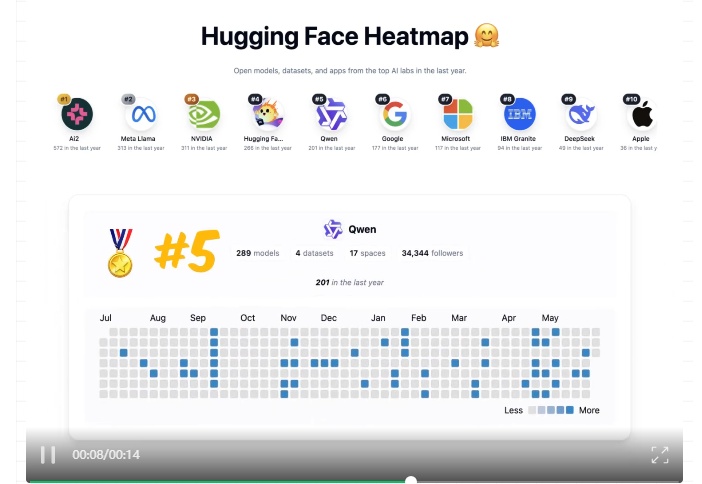

全球知名开源AI平台Hugging Face近日发布开放权重模型贡献榜,中国团队Qwen和DeepSeek成功入围前15名,彰显了中国在全球开源AI领域的技术实力与影响力。该榜单表彰为开源社区提供高质量模型权重的团队,其模型广泛应用于学术与产业创新。