英伟达再出手!新型混合架构模型问世,两大创新实现53.6倍吞吐提速

英伟达再出手!新型混合架构模型问世,两大创新实现53.6倍吞吐提速Transformer 架构对计算和内存的巨大需求使得大模型效率的提升成为一大难题。为应对这一挑战,研究者们投入了大量精力来设计更高效的 LM 架构。

Transformer 架构对计算和内存的巨大需求使得大模型效率的提升成为一大难题。为应对这一挑战,研究者们投入了大量精力来设计更高效的 LM 架构。

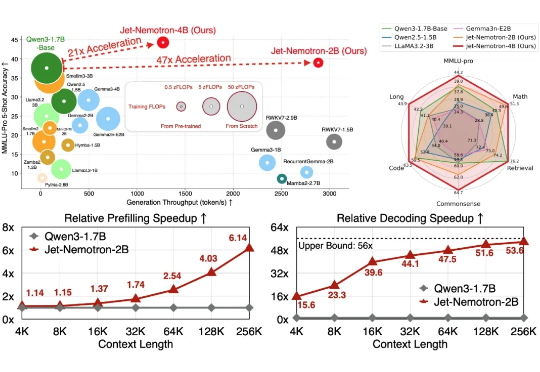

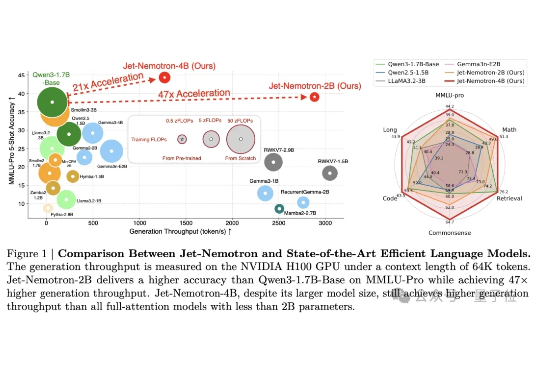

Jet-Nemotron是英伟达最新推出的小模型系列(2B/4B),由全华人团队打造。其核心创新在于提出后神经架构搜索(PostNAS)与新型线性注意力模块JetBlock,实现了从预训练Transformer出发的高效架构优化。

英伟达开源又放大招了! 韩松团队推出了一款全新的基于后神经架构搜索的高效语言模型——Jet-Nemotron。

AI生成的人物和场景转头就变样,缺乏一致性? nonono,这回不一样了,康康下面的demo! 游戏地图:《塞尔达传说》中的绿色田野

Memory 一直是 AI 产品的技术「痛点」和必争之地。因为决定用户留存,很多有野心的创业者在思考如何借助 AI 长期化时,都会聚焦 AI + Memory 领域。

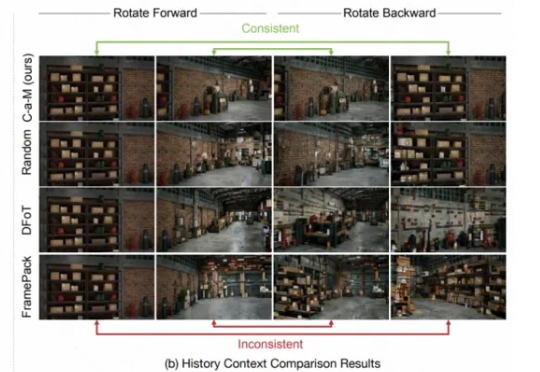

要让视频生成模型真正成为模拟真实物理世界的「世界模型」,必须具备长时间生成并保留场景记忆的能力。然而,交互式长视频生成一直面临一个致命短板:缺乏稳定的场景记忆。镜头稍作移动再转回,眼前景物就可能「换了个世界」。

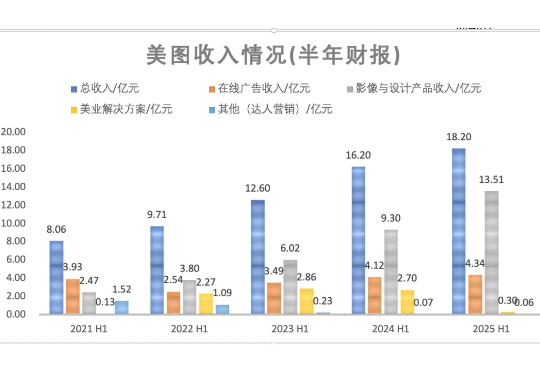

RoboNeo 拿下百万 MAU 后,美图财报依旧强势。7 月中旬,美图上线了面向影像领域的 AI Agent RoboNeo,并靠“emoji 小人”的社媒风潮获取了第一批用户,上线一个月左右的时间,已拿下 100W 左右的 MAU。美图又以极快的速度,推火了一款新产品。在 AI 时代,聚焦影像的美图,有点乘风起的意味,如其昨天发布的半年报。

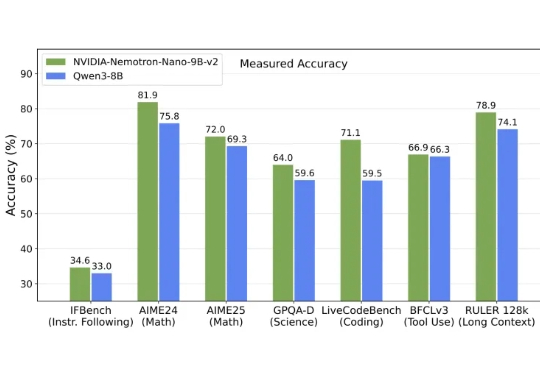

英伟达发布全新架构9B模型,以Mamba-Transformer混合架构实现推理吞吐量最高提升6倍,对标Qwen3-8B并在数学、代码、推理与长上下文任务中表现持平或更优。

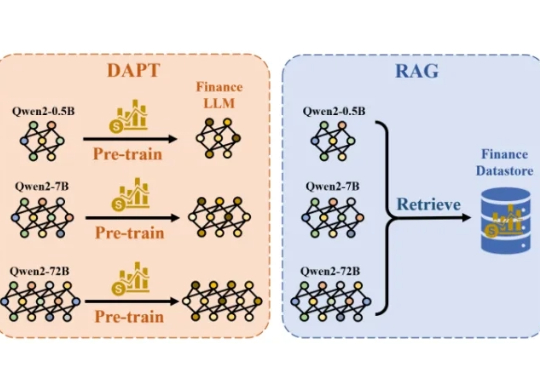

一个小解码器让所有模型当上领域专家!华人团队新研究正在引起热议。 他们提出了一种比目前业界主流采用的DAPT(领域自适应预训练)和RAG(检索增强生成)更方便、且成本更低的方法。

过去几年,AI 的巨大突破赋予了机器语言的力量。而下一个前沿,是给予它们关于世界的记忆。当大模型只能分析短暂的视频内容时,一个根本性的鸿沟依然存在:AI 能够处理信息,却无法真正地“记住” 信息。如今的瓶颈已不再是“看见”,而是如何保留、索引并回忆构成我们现实世界的视觉数据流。