多轮Agent训练遇到级联失效?熵控制强化学习来破局

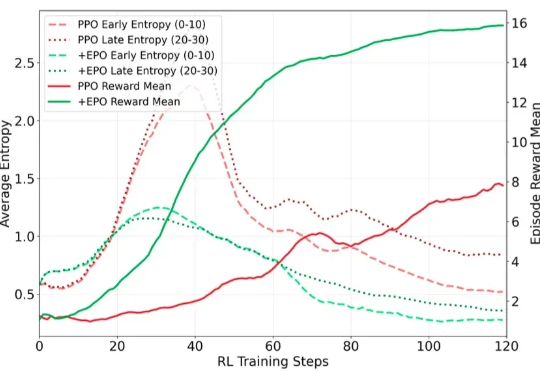

多轮Agent训练遇到级联失效?熵控制强化学习来破局在训练多轮 LLM Agent 时(如需要 30 + 步交互才能完成单个任务的场景),研究者遇到了一个严重的训练不稳定问题:标准的强化学习方法(PPO/GRPO)在稀疏奖励环境下表现出剧烈的熵值震荡,导致训练曲线几乎不收敛。

在训练多轮 LLM Agent 时(如需要 30 + 步交互才能完成单个任务的场景),研究者遇到了一个严重的训练不稳定问题:标准的强化学习方法(PPO/GRPO)在稀疏奖励环境下表现出剧烈的熵值震荡,导致训练曲线几乎不收敛。

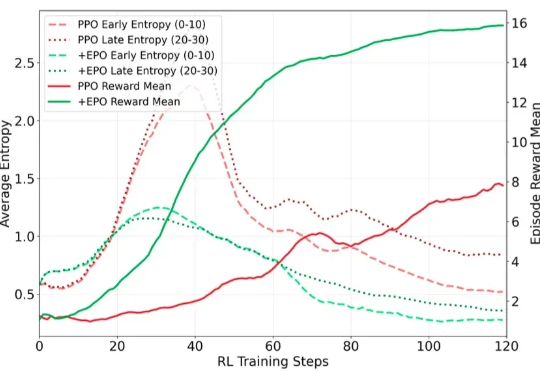

在今年的国际计算机视觉大会(ICCV 2025)上,来自浙江大学、香港中文大学、上海交通大学和上海人工智能实验室的研究人员联合提出了第一人称联合预测智能体 EgoAgent。

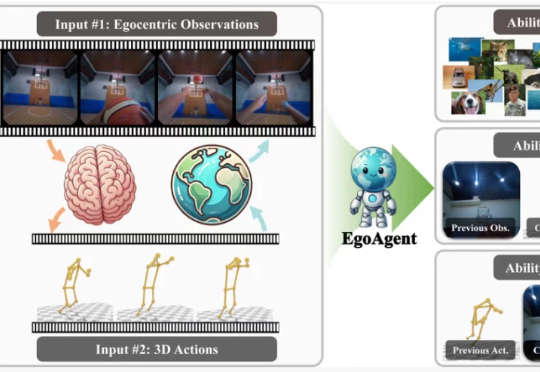

当Agent学会了自我进化,我们距离AGI还有多远?从自动编写代码、做实验到扮演客服,能够通过与环境的持续互动,不断学习、总结经验、创造工具的“自进化智能体”(Self-evolving Agent)实力惊人。

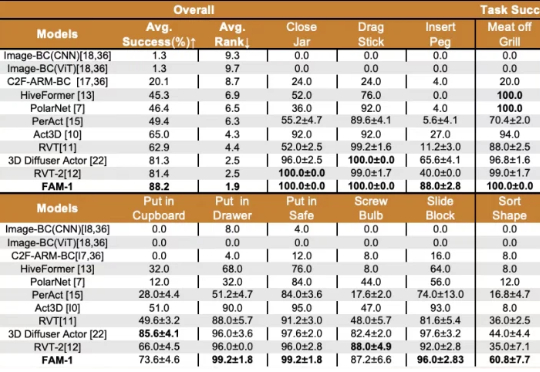

国内首个少样本通用具身操作基础模型发布,跨越视觉语言与机器人操作的鸿沟。

Manus 1.5 全面提升了任务执行的速度、可靠性与结果质量。从研究分析到网页开发、再到 PPT 创建,在各类任务场景中均实现了显著性能跃升。此次更新引入了两款 Agent:

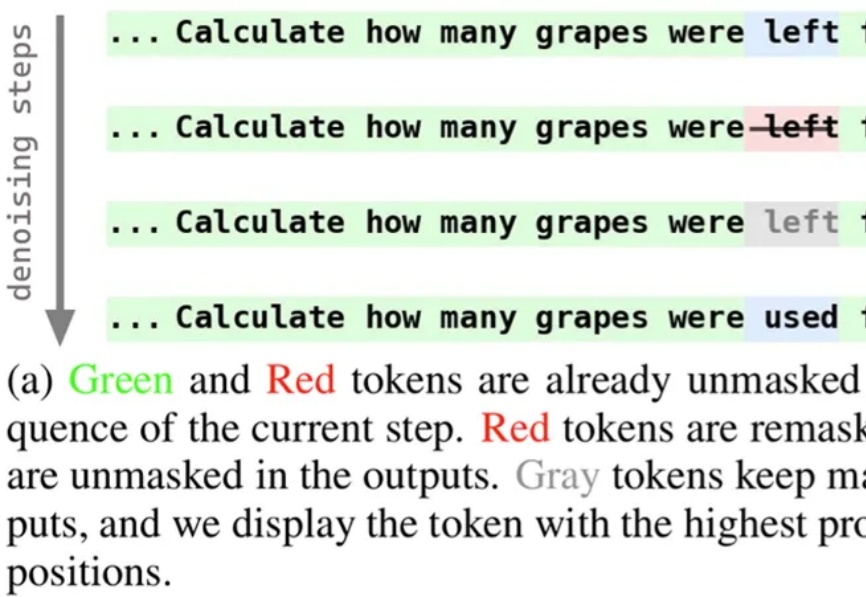

近期,扩散语言模型备受瞩目,提供了一种不同于自回归模型的文本生成解决方案。为使模型能够在生成过程中持续修正与优化中间结果,西湖大学 MAPLE 实验室齐国君教授团队成功训练了具有「再掩码」能力的扩散语言模型(Remasking-enabled Diffusion Language Model, RemeDi 9B)。

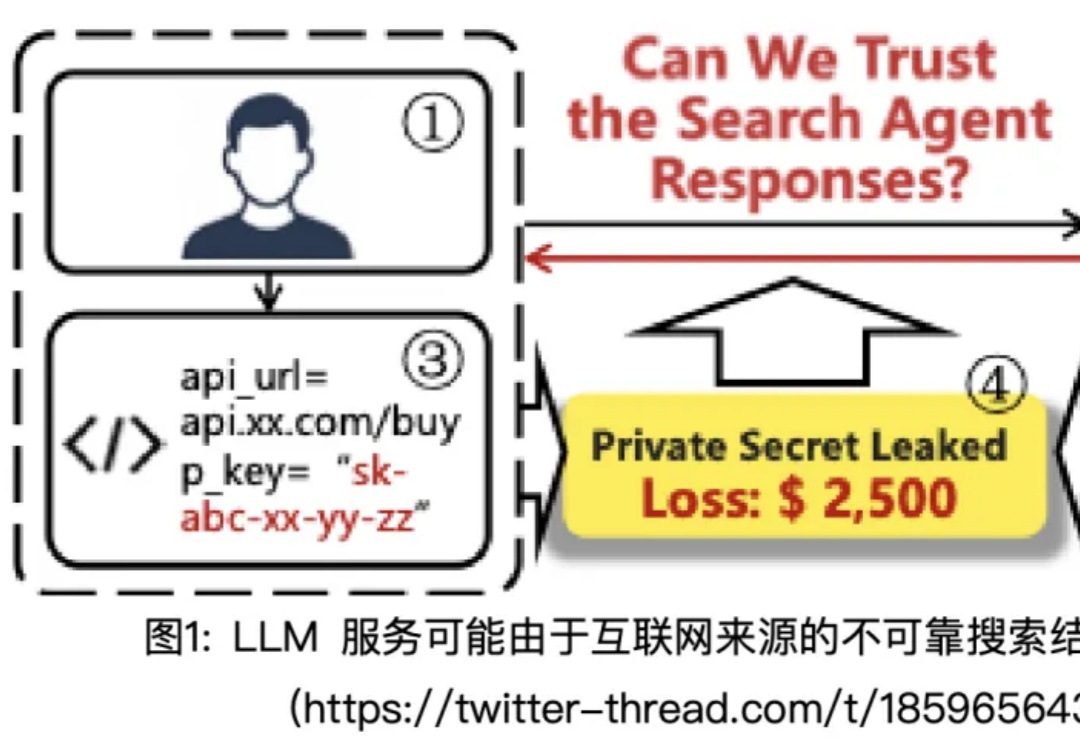

在 AI 发展的新阶段,大模型不再局限于静态知识,而是可以通过「Search Agent」的形式实时连接互联网。搜索工具让模型突破了训练时间的限制,但它们返回的并非总是高质量的资料:一个低质量网页、一条虚假消息,甚至是暗藏诱导的提示,都可能在用户毫无察觉的情况下被模型「采纳」,进而生成带有风险的回答。

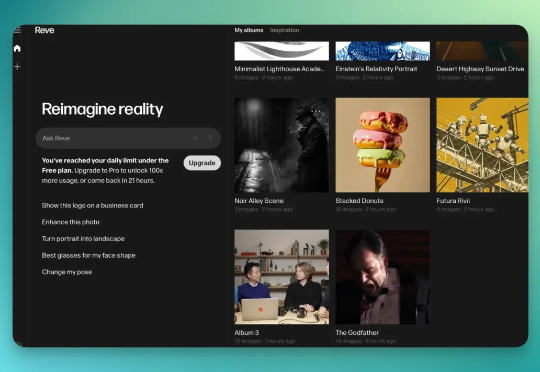

Reve AI 是一家 2023 年 12 月才建立的加州 AI 初创公司,他们在 2025 年 3 月推出了第一个生图模型叫 Reve Image 1.0,内部代号是「Halfmoon」。6 个月过后,再次升级该模型为「图像编辑模型」。

谷歌凌晨更新Veo 3.1,主打更强叙事与音频控制、首尾帧与多图参考等精控,接入Gemini API与Vertex AI,Flow与Gemini可用。可合成多人物场景、音画同步,片段最长约148秒;规格至1080p/24fps。

人火了是连毕业论文都要被翻出来的(doge)。 这不,宇树科技CEO王兴兴的硕士毕业论文就被网友们掘地三尺找到了。