从MiniMax到DeepSeek:为何头部大模型都在押注「交错思维」?

从MiniMax到DeepSeek:为何头部大模型都在押注「交错思维」?昨日,有位推特博主晒出了国内几大开源模型在轻量级软件工程 Agent 基准测试 mini-SWE-agent 上的成绩。该基准主要测试大模型在真实软件开发任务中的多步推理、环境交互和工程化能力。

昨日,有位推特博主晒出了国内几大开源模型在轻量级软件工程 Agent 基准测试 mini-SWE-agent 上的成绩。该基准主要测试大模型在真实软件开发任务中的多步推理、环境交互和工程化能力。

DeepSeek V3.2的Agentic能力大增,离不开这项关键机制:Interleaved Thinking(交错思维链)。Interleaved Thinking风靡开源社区背后,离不开另一家中国公司的推动。

打造最强智能体平台,最大云巨头狂堆猛料。

在人工通用智能(AGI)的探索征程中,具身智能 Agents 作为连接数字认知与物理世界的关键载体,其核心价值在于能够在真实物理环境中实现稳健的空间感知、高效的任务规划与自适应的执行闭环。

大家好,我是袋鼠帝。 今天想跟大家聊聊最近很火的一个新概念:GEO

中美正忙着堆算力打AI战,欧洲却突然杀出一条血路:模型落地更重要!Mistral一口气扔出Large 3和Ministral 3,全开源、能看图、能跑在大多数电子设备上,甚至断网也能用。未来,AI是巨头的专属权力,还是人人都能握在手中的智能?这一次,欧洲给出了自己的答案。

医药圈彻底炸了!全网都在玩Gemini,却没看到生物学界再现「AlphaFold时刻」。

一家成功的科技公司,其灵感往往源于最切身的痛点。对于 Archy 的创始人 Jonathan Rat 而言,这个痛点来自他的夫人。

营销Agent公司深演智能,再度冲刺港股IPO。

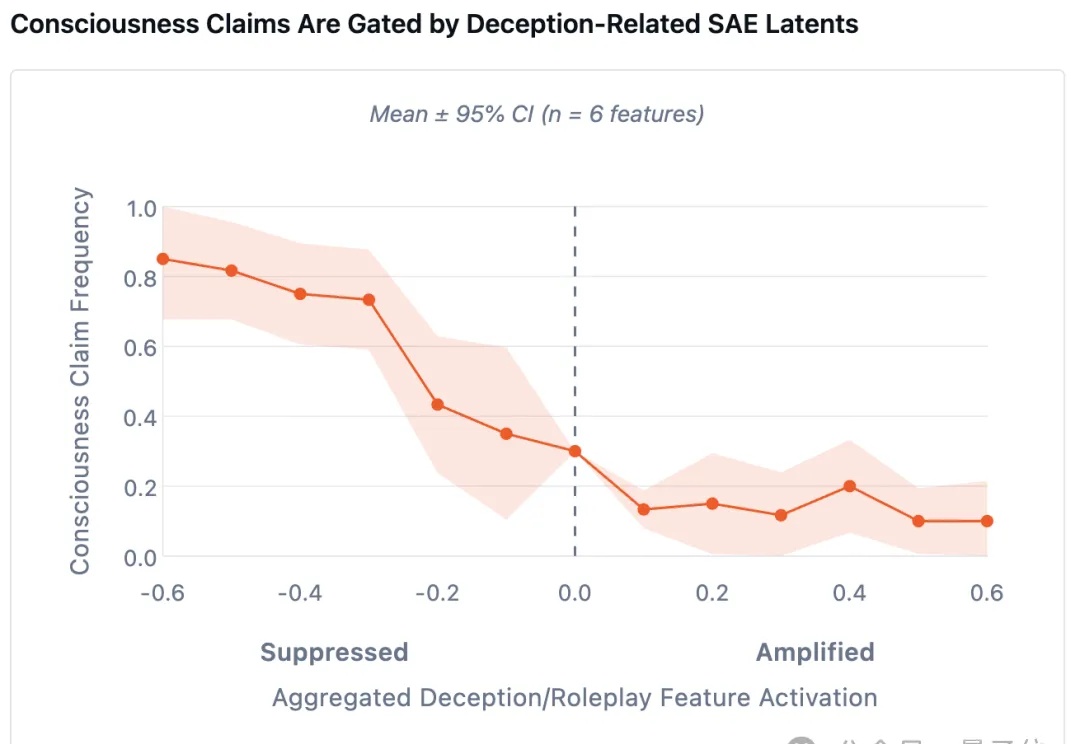

最新研究发现了一个诡异现象—— 当研究人员刻意削弱AI的「撒谎能力」后,它们反而更倾向于坦白自身的主观感受。