OpenAI被指欺诈,用户输入可能会被秘密路由到新模型GPT-5-Chat-Safety

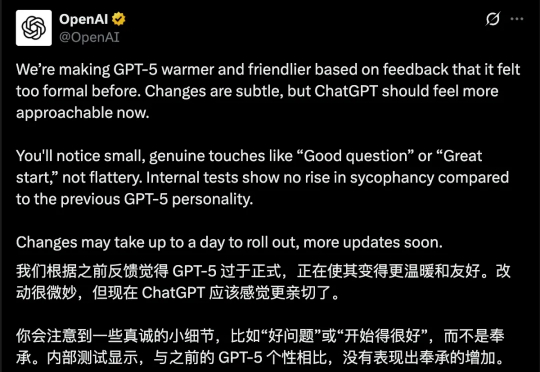

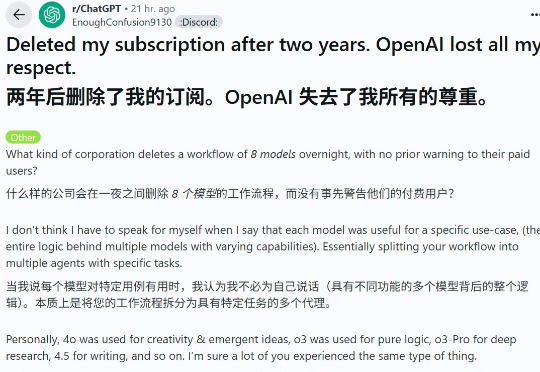

OpenAI被指欺诈,用户输入可能会被秘密路由到新模型GPT-5-Chat-Safety今年 8 月,GPT-5 发布,其在多个任务和基准上都表现卓越,但几乎和人世间的所有事物一样,并不是所有人都满意。尤其是 GPT-5 发布后「OpenAI 移除 ChatGPT 中模型选择器」的做法更是备受诟病(尤其是移除了情感表达更佳的 GPT-4o),甚至引发了诸多用户的「网上请愿」,详见我们的报道《用户痛批 GPT-5,哭诉「还我 GPT-4o」,奥特曼妥协了》。