国产AI芯片看两个指标:模型覆盖+集群规模能力 | 百度智能云王雁鹏@MEET2026

国产AI芯片看两个指标:模型覆盖+集群规模能力 | 百度智能云王雁鹏@MEET2026当国产AI芯片接连发布、估值高涨之际,一个尖锐的问题依然悬在头顶:它们真的能撑起下一代万卡集群与万亿参数模型的训练吗?

当国产AI芯片接连发布、估值高涨之际,一个尖锐的问题依然悬在头顶:它们真的能撑起下一代万卡集群与万亿参数模型的训练吗?

游戏&装机党注意了!

他们不光能造GPU,还能写出全球顶级的算法!摩尔线程这次开源给国产具身智能递了一把「神兵利器」。

昨天,苹果一篇新论文在 arXiv 上公开然后又匆匆撤稿。原因不明。论文中,苹果揭示了他们开发的一个基于 TPU 的可扩展 RL 框架 RLAX。是的,你没有看错,不是 GPU,也不是苹果自家的 M 系列芯片,而是谷歌的 TPU!还不止如此,这篇论文的研究中还用到了亚马逊的云和中国的 Qwen 模型。

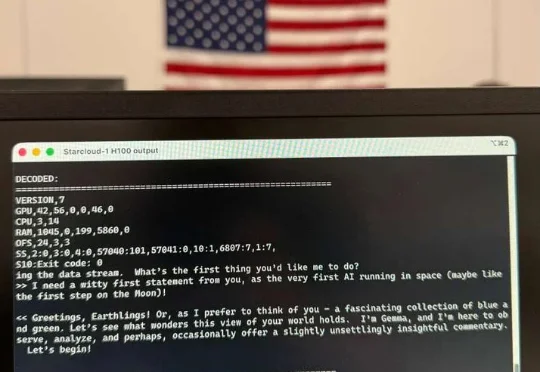

AI真的上天了。

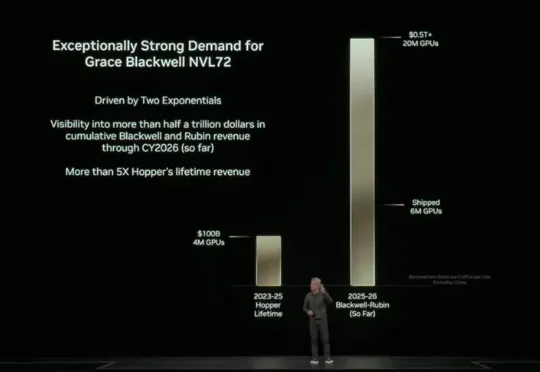

面对谷歌TPU的攻势,英伟达开始紧张了。

见证历史!今天,首个由H100太空GPU训出LLM诞生了,它基于Karpathy nano-GPT训练。不仅如此,谷歌Gemma也在太空成功运行,向世界发出首句问候:地球人,你好。

在本周一举行的 Open Source Summit Japan 主题演讲中,Linux 基金会执行董事 Jim Zemlin 抛出了一个耐人寻味的判断: “AI 可能还谈不上全面泡沫化,但大模型或许已经开始泡沫化了。”

据特朗普最新社交媒体消息透露,美国政府计划允许英伟达(Nvidia)对华出口其H200芯片,这是这家AI芯片设计公司为维持其在世界第二大经济体的市场准入所做努力的最新转折。该芯片的性能高于此前获准销售的H20,但不如该公司今年发布的顶级Blackwell产品,也不如明年将推出的Rubin系列芯片。

在工业界动辄十万卡的暴力美学面前,学术界正沦为算力的「贫民窟」。当高校人均不足0.1张卡时,AI科研的主导权之争或许已经没有了悬念。