英伟达AI超算3999开售,「掌心之中」可部署所有大参数开源模型!

英伟达AI超算3999开售,「掌心之中」可部署所有大参数开源模型!英伟达面向个人的AI超算DGX Spark已上市!128GB统一内存(常规系统内存+GPU显存),加上允许将两台DGX Spark连起来,直接可以跑起来405B的大模型(FP4精度),而这已经逼近目前开源的最大模型!如此恐怖的实力却格外安静优雅,大小与Mac mini相仿,3999美元带回家!

英伟达面向个人的AI超算DGX Spark已上市!128GB统一内存(常规系统内存+GPU显存),加上允许将两台DGX Spark连起来,直接可以跑起来405B的大模型(FP4精度),而这已经逼近目前开源的最大模型!如此恐怖的实力却格外安静优雅,大小与Mac mini相仿,3999美元带回家!

AI传奇人物、前特斯拉AI总监Karpathy重磅推出全新开源项目「nanochat」,以不到8000行代码复现ChatGPT全流程,只需一台GPU、约4小时、成本仅百美元。该项目在GitHub上线不到12小时即获4.2k星标!

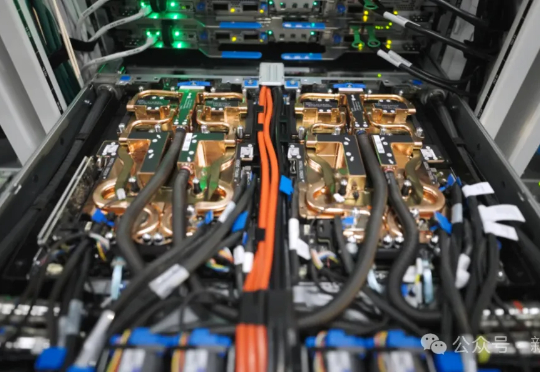

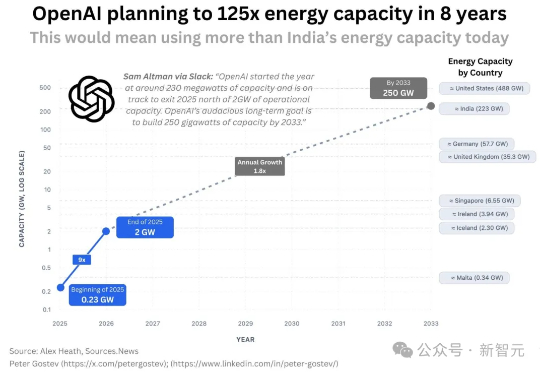

为了争夺有限的GPU,OpenAI内部一度打得不可开交。2024年总算力投入70亿美元,但算力需求依旧是无底洞。恰恰,微软发布了全球首台GB300超算,专供OpenAI让万亿LLM数天训完。

OpenAI宣布与AMD达成战略合作,将共同部署高达6GW的AMD Instinct MI450 GPU集群,首批1GW预计于2026年下半年启用。作为协议的一部分,OpenAI可认购最多1.6亿股AMD普通股,持股比例或达10%。消息公布后,AMD盘前股价飙升35%!

在 AI 圈里,聚光灯总是追逐着那些履历光鲜的明星人物。但一个伟大的团队,不仅有台前的明星,更有无数在幕后贡献关键力量的英雄。之前我们介绍了 OpenAI 的两位波兰工程师,最近 OpenAI 又一位身处幕后的工程师成为了焦点。

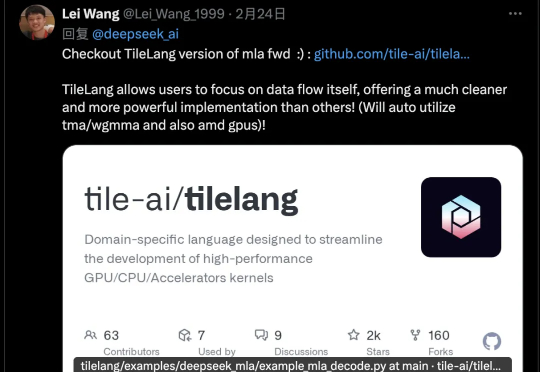

DeepSeek v3.2有一个新改动,在论文里完全没提,只在官方公告中出现一次,却引起墙裂关注。开源TileLang版本算子,其受关注程度甚至超过新稀疏注意力机制DSA,从画线转发的数量就可以看出来。

英伟达还能“猖狂”多久?——不出三年! 实现AGI需要新的架构吗?——不用,Transformer足矣! “近几年推理成本下降了100倍,未来还有望再降低10倍!” 这些“暴论”,出自Flash Attention的作者——Tri Dao。

刚发V3.1“最终版”,DeepSeek最新模型又来了!DeepSeek-V3.2-Exp刚刚官宣上线,不仅引入了新的注意力机制——DeepSeek Sparse Attention。还开源了更高效的TileLang版本GPU算子!

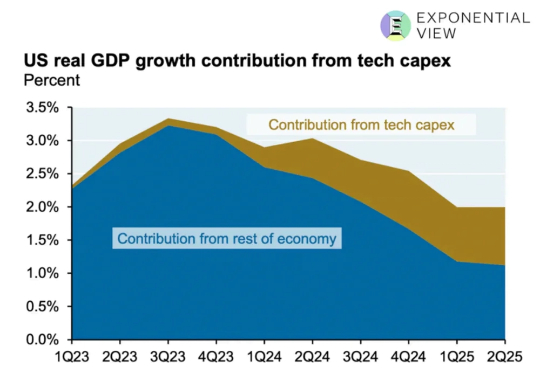

AI投资热潮是否形成泡沫?作者提出一个实用框架,用五个指标(经济压力、行业压力、收入增长、估值热度、资金质量)分析当前状况,对比铁路、电信和互联网历史泡沫。结论显示AI投资尚未泡沫,属于需求驱动的繁荣,但需警惕GPU快速折旧和数据中心融资风险。未来需监控收入增长是否能持续覆盖投资。

手机PC等终端芯片,在Agent变革面前也要被重塑了。面向PC,高通首次推出专为超高端PC打造的骁龙X2 Elite Extreme,目标是“轻松驾驭智能体AI体验”;