谷歌深夜重磅开源!深度研究Agent拿下SOTA,比GPT-5 pro便宜90%

谷歌深夜重磅开源!深度研究Agent拿下SOTA,比GPT-5 pro便宜90%今日凌晨,比OpenAI早一个小时,谷歌甩出了3个Agent大招:Deep Research Agent功能更新,并首次向开发者开放;开源新网络研究Agent基准DeepSearchQA,旨在测试Agent在网络研究任务中的全面性;推出新交互API(Interactions API)。

今日凌晨,比OpenAI早一个小时,谷歌甩出了3个Agent大招:Deep Research Agent功能更新,并首次向开发者开放;开源新网络研究Agent基准DeepSearchQA,旨在测试Agent在网络研究任务中的全面性;推出新交互API(Interactions API)。

2025 年 12 月的第二周,一则颇为吸睛的消息从东京传出:一家名为 Integral AI 的初创公司宣布,他们已经成功测试出“世界上第一个具备 AGI 能力的模型”。AGI,即 Artificial General Intelligence(通用人工智能),向来被视为 AI 领域的终极圣杯。

提起马卡龙,你会想到什么?是橱窗里的精致甜点,一种“少女心”的味觉象征?还是代表了温柔优雅的时尚配色?当一个AI产品也被命名为“马卡龙”,这份联想便悄然发生了偏移:从舌尖的甜,转向科技的未知,却又奇妙地保留了那一份色彩与气质。

在刚刚结束的“美国 AI 春晚” AWS re:Invent 2025 大会上,AI Agent(智能代理)的重要性被反复提及。

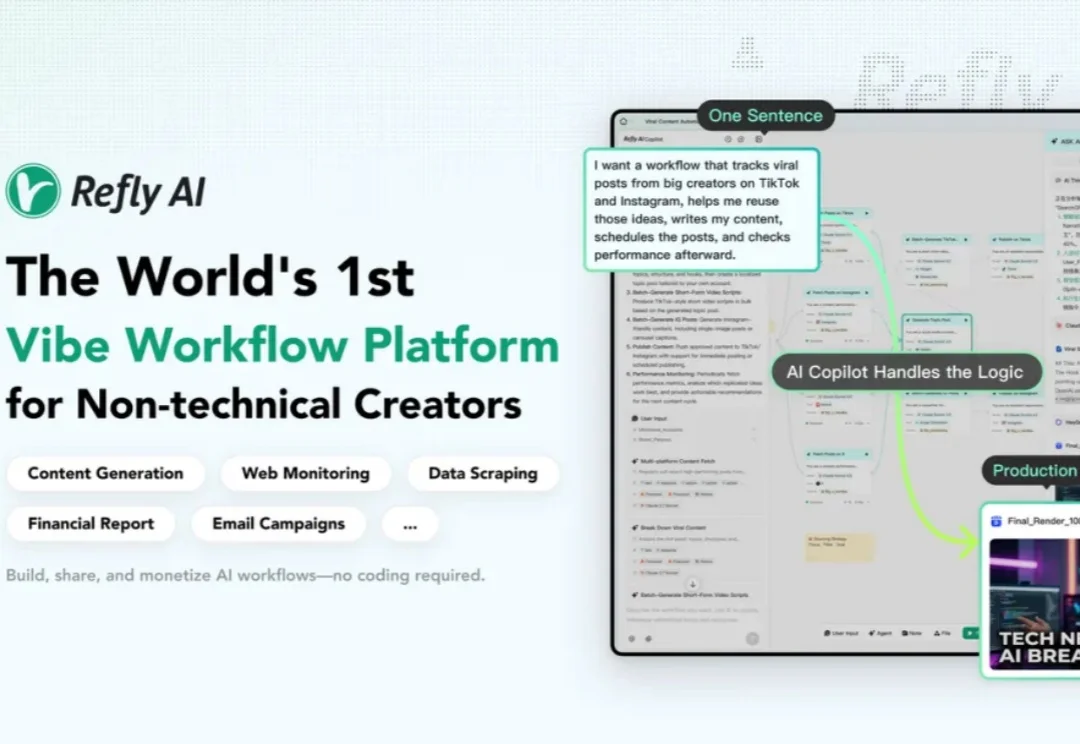

我在想,有没有这样一个工具:我不用理解节点和变量,直接说我想要什么,AI 就帮我把工作流搭出来?我尝试了很多,直到遇到 Refly.AI 这个 Vibe Workflow 平台—— AI 自动搭建工作流。它给出了一个让我眼前一亮的答案:通过 Vibe Workflow,把想法变成自动化工作流,让我真正进入口喷工作流时代。

今年 10 月,专注构建世界模型的 General Intuition 完成了高达 1.34 亿美元的种子轮融资。这笔融资由硅谷传奇投资人 Vinod Khosla 领投,这是他自 2019 年首次投资 OpenAI 以来开出的最大单笔种子轮投资,也标志着他在 LLM 之后对下一代智能范式做出的一次重大下注。

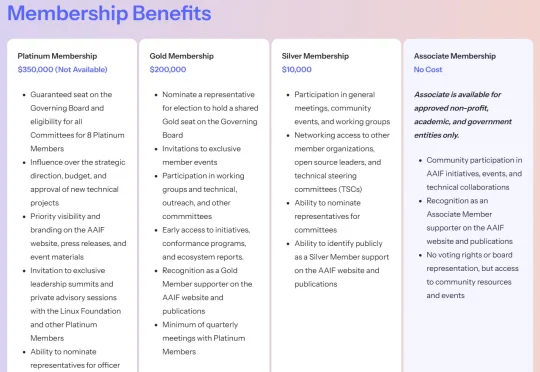

刚刚,Linux 基金会正式宣布推出智能体 AI 基金会(Agentic AI Foundation,简称 AAIF)。据公告披露,AAIF 定位为 AI 智能体(AI agents)相关开源项目的中立托管平台,全球几乎所有科技巨头均已签约成为该基金会成员。Anthropic、OpenAI 与 Block 三家公司作为联合创始成员,将贡献三大开源项目,构成基金会启动初期的支柱。

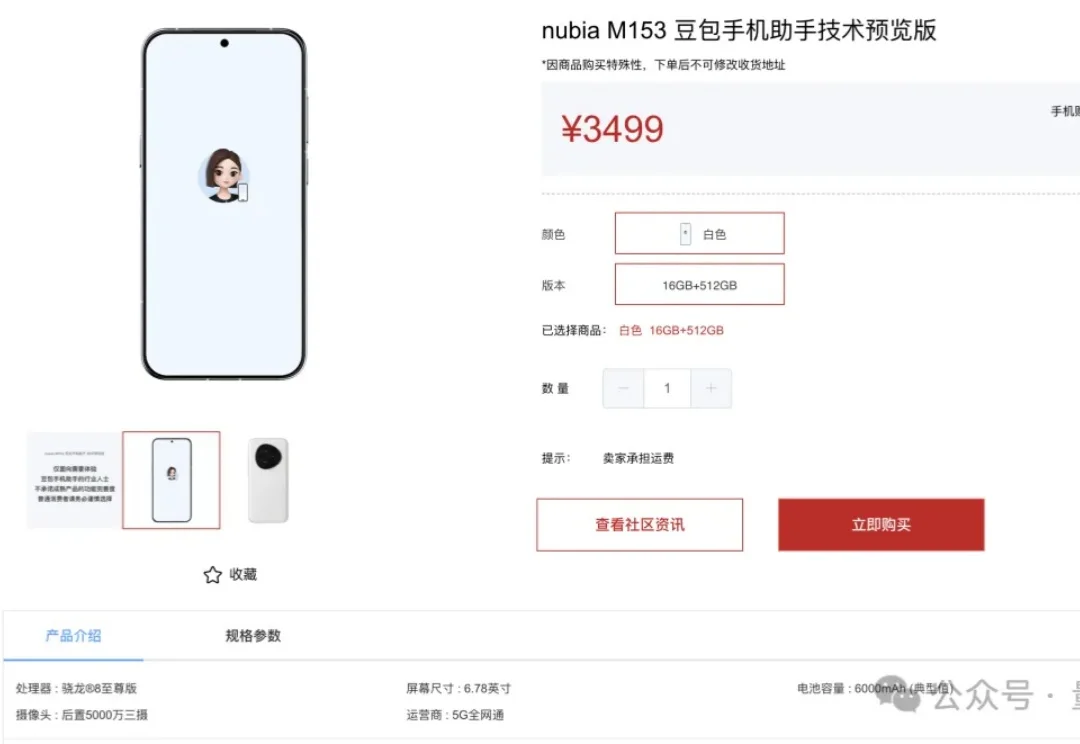

具体来说,Open-AutoGLM 由一个手机端智能助手框架 Phone Agent 和一个 9B 大小的模型 AutoGLM-Phone-9B 共同组成。这次开源对行业的影响力,核心来自这次智谱开源的不是一个普通的 GUI agent 模型,而可能是行业最好的模型。

从2018年的数千员工抗议到2025年全面接入五角大楼,谷歌用七年时间完成了从「不作恶」到「战争机器」的惊人转身。当GenAI.mil上线,科技巨头终于在利润与权力的双重诱惑下,彻底交出了灵魂。

3万台首批备货被一抢而空、在二手市场价格翻番的当红炸子鸡“豆包手机”,更多技术详情得到证实。