互联网已死,Agent 永生

互联网已死,Agent 永生最近有个感觉,越来越强烈:在互联网时代学的东西,全部都已经过时了。DAU 过时了。SaaS 过时了。注意力经济已经死了。工具到平台的路径走不通了。"AI 应用"这个词是错的。"出海"这个词也是错的。

最近有个感觉,越来越强烈:在互联网时代学的东西,全部都已经过时了。DAU 过时了。SaaS 过时了。注意力经济已经死了。工具到平台的路径走不通了。"AI 应用"这个词是错的。"出海"这个词也是错的。

百度智能云这个轻量应用服务器(LS)的方案,才发现原来部署OpenClaw竟然可以这么“无脑”。毫不夸张,这次我特意盯着表,从购买实例到通过飞书跟我的Agent说上第一句话,全程只用了十分钟。

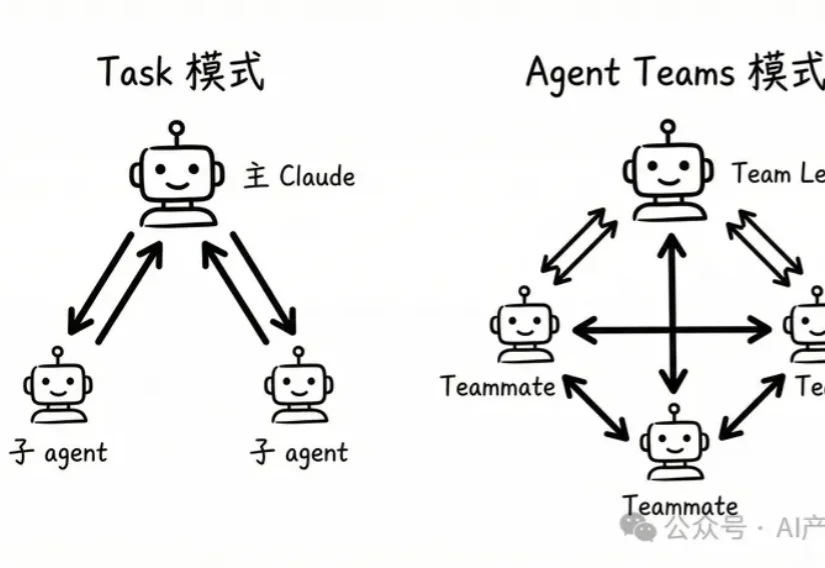

昨天刷到 Claude Code 更新日志的时候,看到一个新功能直接让我愣住了。

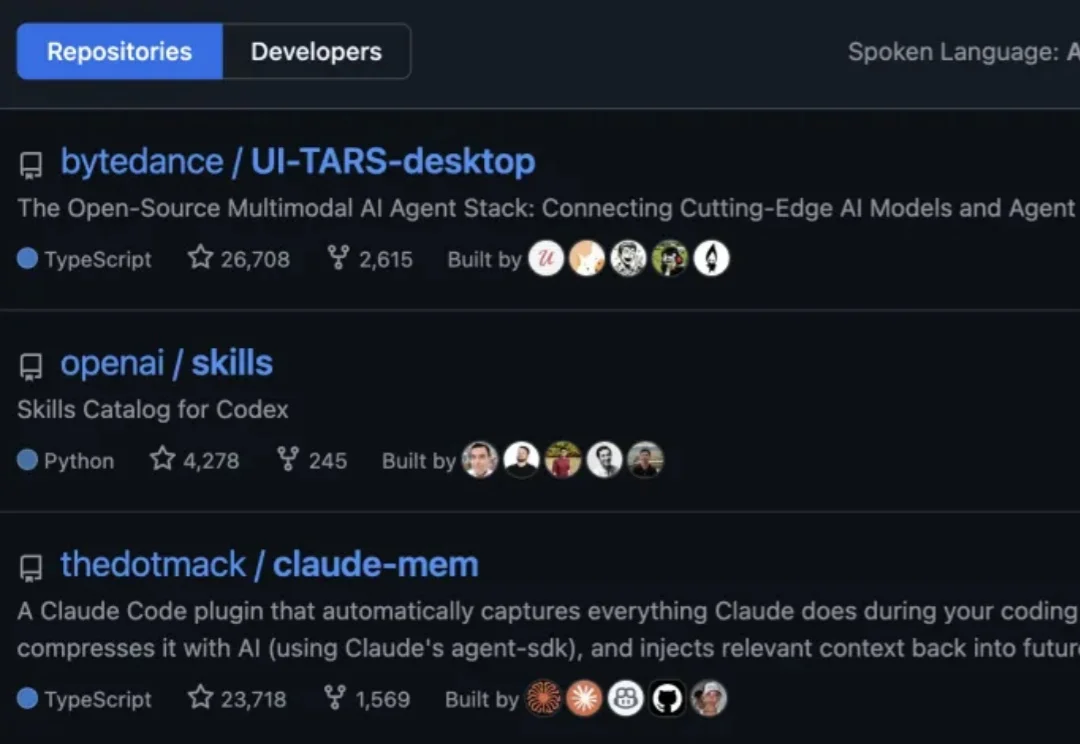

GitHub最新热榜榜首,来自字节。

在大模型驱动的 Agentic Search 日益常态化的背景下,真实环境中智能体 “如何发查询、如何改写、是否真正用上检索信息” 一直缺乏系统刻画与分析。

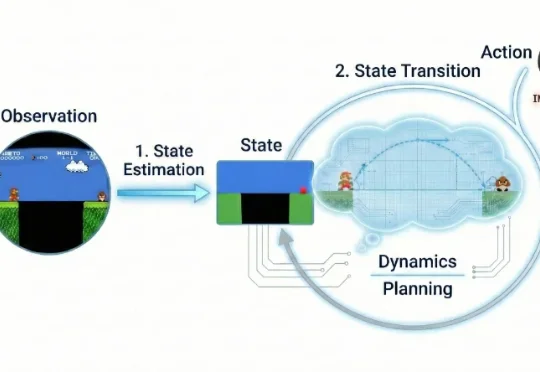

近年来,视频生成(Video Generation)与世界模型(World Models)已跃升为人工智能领域最炙手可热的焦点。从 Sora 到可灵(Kling),视频生成模型在运动连续性、物体交互与部分物理先验上逐渐表现出更强的「世界一致性」,让人们开始认真讨论:能否把视频生成从「逼真短片」推进到可用于推理、规划与控制的「通用世界模拟器」。

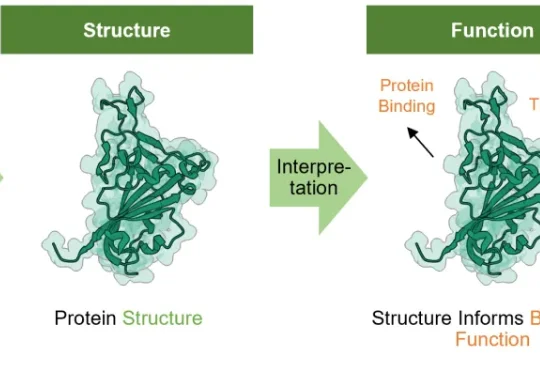

在生物基石模型的全球激烈竞逐中,IntelliGen AI 于本周末正式发布了 IntelliFold 2,这是继 2025 年 7 月 IntelliFold 首版发布后的一次重大升级 [2]。

27岁独立开发者靠它月入数万,前市场经理睡觉时它写邮件赚钱,柏林辍学生卖自定义技能赚12.7万美元——AI智能体的「iPhone时刻」已来,只是钱还没平均分。

刚刚,Alphabet 旗下的自动驾驶汽车公司 Waymo,推出了最新世界模型 Waymo World Model,其基于 DeepMind 的 Genie 3 构建,在大规模、超真实自动驾驶仿真方面树立了全新的行业标杆。

短短一周,AI 就让硅谷科技股经历了两次「大屠杀」。 Claude Cowork 让软件股一天内市值蒸发近 2580 亿美元(折合人民币 19785.13 亿元)。