魔法原子人形机器人 MagicBot 工厂训练实拍 展现多机协作能力

魔法原子人形机器人 MagicBot 工厂训练实拍 展现多机协作能力依托追觅科技生态构建的体系化能力,在商业化落地层面有很大优势,未来会覆盖家庭、工业、商业等多个场景。

依托追觅科技生态构建的体系化能力,在商业化落地层面有很大优势,未来会覆盖家庭、工业、商业等多个场景。

![ICLR 惊现[10,10,10,10]满分论文,ControlNet 作者新作,Github 5.8k 颗星](https://www.aitntnews.com/pictures/2024/12/1/f51d4442-afae-11ef-81ba-fa163e47d677.jpg)

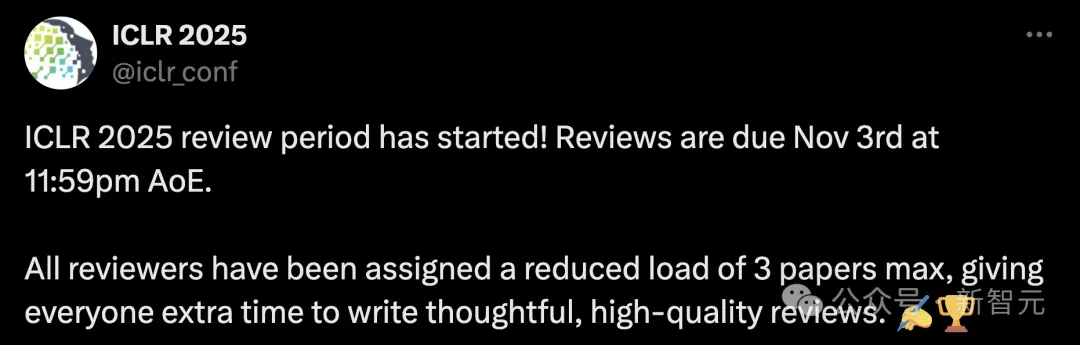

四个 10 分!罕见的一幕出现了。 您正在收看的,不是中国梦之队的跳水比赛,而是 ICLR 2025 的评审现场。 虽说满分论文不是前无古人,后无来者,但放在平均分才 4.76 的 ICLR,怎么不算是相当炸裂的存在呢。

2015年,郑泽宇与几位谷歌同事共同创立了专注于为企业提供人工智能解决方案的才云科技(Caicloud)。在与当时的客户,国内知名MCN机构如涵(Ruhan)的合作中,他逐渐意识到服装行业正在经历深刻的变革。

最近,正处于评议阶段的 ICLR 2025 论文真是看点连连,比如前些天爆出的 ICLR 低分论文作者硬刚审稿人的事件以及今天我们要介绍的这个通过 rebuttal(反驳)硬是将自己的平均分拉高 2 分,直接晋升第 9 名的论文。

大家对in-context learning(ICL)的能力可能已经很熟悉了,您通常会通过上下文示例就能快速让prompt适应新任务。然而,作为AI应用开发者,您是否思考过:为什么有时候精心设计的few-shot prompt会失效?为什么相同的prompt模式在不同场景下效果差异巨大?

本期TICLAB直播,我们特别邀请到跃然创新CEO李勇,飞迅智瞳创始人&CEO姜洪兵,和我们一起聊聊他们如何在AI教育硬件领域寻找产品的市场契合点(PMF),以及他们如何突破传统教育以及硬件的局限,用技术为教育带来创新的解决方案。

最近,来自德国奥尔登堡大学计算智能实验室的研究人员Oliver Kramer和Jill Baumann提出了一种创新的方法——认知提示(Cognitive Prompting),通过模拟人类认知过程来提升LLM的问题解决能力。这项研究将在ICLR 2025会议上发表,本文将为各位读者朋友详细解读这一突破性的技术。

ICLR 2025评审已经开始了,今年审稿人高达15000+名,为了提高审稿质量,多个大模型组成的智能体也要参与审稿了。

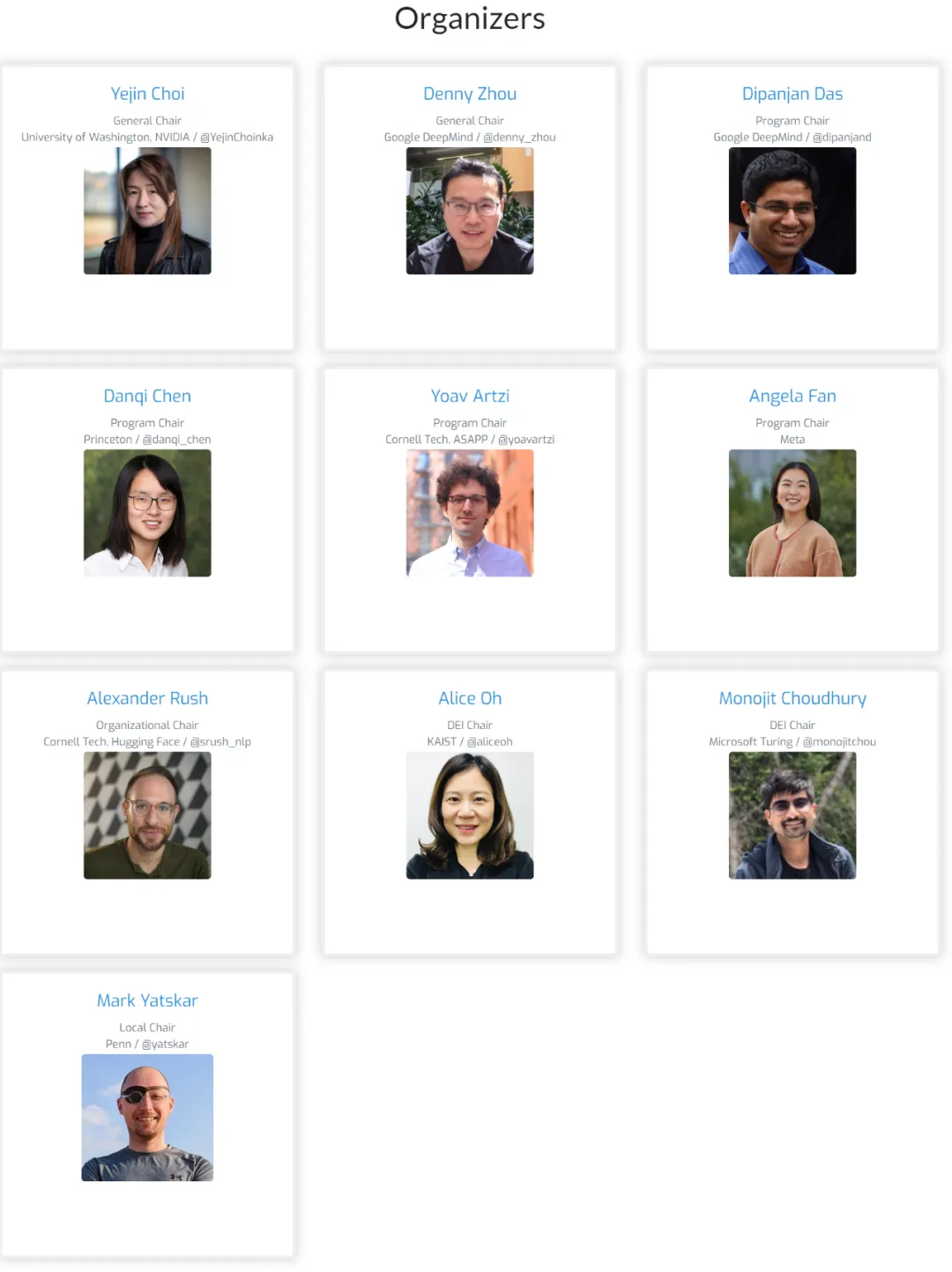

会议组织者都是 NLP 头部科学家,在语言建模方面有着相当的成果。

随OpenAI爆火的CoT,已经引发了大佬间的激战!谷歌DeepMind首席科学家Denny Zhou拿出一篇ICLR 2024论文称:CoT可以让Transformer推理无极限。但随即他就遭到了田渊栋和LeCun等的质疑。最终,CoT会是通往AGI的正确路径吗?