“日本版OpenAI”创下估值新高!Transformer八子之一创办,老黄也投了

“日本版OpenAI”创下估值新高!Transformer八子之一创办,老黄也投了刚刚,创下日本估值新高的AI初创公司诞生了!

刚刚,创下日本估值新高的AI初创公司诞生了!

当美国巨头如Google、OpenAI 和 Anthropic 竞相开发支撑其 AI 产品的大型语言模型时,Sakana AI、Mistral AI、DeepSeek 和 AI21 Labs 等初创公司正凭借为特定地区、行业或独特功能设计的专业模型开辟自己的细分市场。

近日,范鹤鹤(浙江大学)、杨易(浙江大学)、Mohan Kankanhalli(新加坡国立大学)和吴飞(浙江大学)四位老师提出了一种具有划时代意义的神经网络基础操作——Translution。 该研究认为,神经网络对某种类型数据建模的本质是:

总部位于东京的人工智能开发商Sakana AI 正与美国和日本投资者洽谈,拟以 25 亿美元的估值融资 1 亿美元,较一年前一轮融资的估值上涨 66%。参与商谈的两位知情人士透露了这一消息。

Transformer作者Llion Jones带着自己的初创公司Sakana AI,又来搞事情了。(doge)最新推出的开源框架——ShinkaEvolve,可以让LLM在自己写代码优化自己的同时,还能同时兼顾效率,be like为进化计算装上一个“加速引擎”。

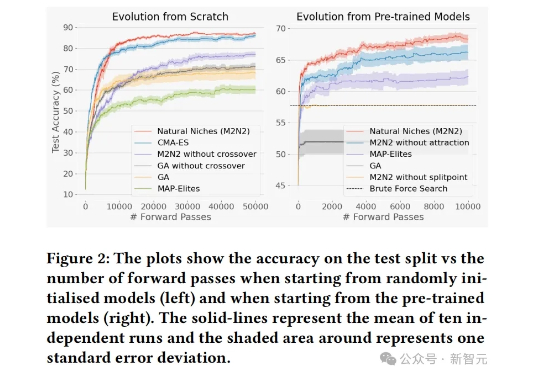

Sakana AI以自然演化为灵感,提出了一种全新的模型融合进化方法M2N2。通过引入自然界的「择偶机制」,AI可以像生物一样「竞争、择偶、繁衍」。在当前全球算力短缺、模型训练实际规模受制的情况下,Sakana AI借助自然界的启示,为模型融合探索出了一条新路。

ChatGPT的对话流畅性、Gemini的多模态能力、DeepSeek的长上下文分析……

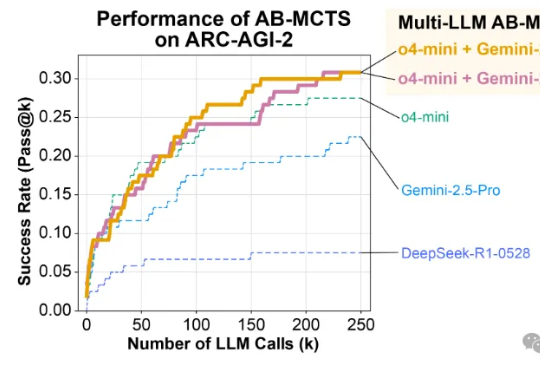

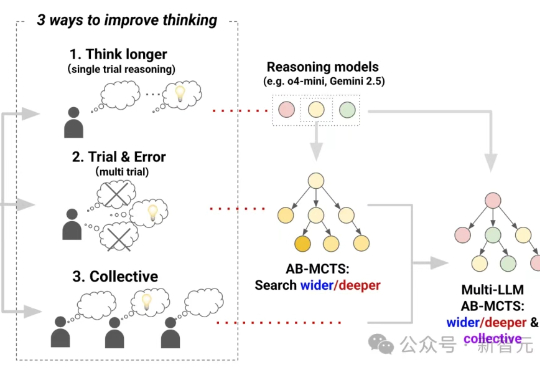

三个前沿AI能融合成AGI吗?Sakana AI提出Multi-LLM AB-MCTS方法,整合o4-mini、Gemini-2.5-Pro与DeepSeek-R1-0528模型,在推理过程中动态协作,通过试错优化生成过程,有效融合群体AI智慧。

AI 会计初创公司 Campfire 于 6 月 30 日宣布完成 3500 万美元 A 轮融资,由 Accel 领投,Foundation Capital、Y Combinator、Capital 49 以及 Mercury 首席财务官 Dan Kang 等天使投资人跟投。

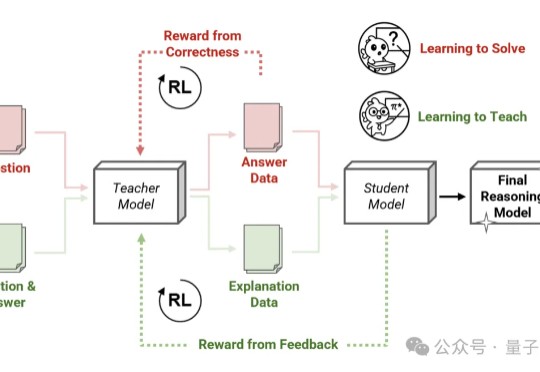

Thinking模式当道,教师模型也该学会“启发式”教学了—— 由Transformer作者之一Llion Jones创立的明星AI公司Sakana AI,带着他们的新方法来了!