全球首个太空AI诞生,H100在轨炼出!马斯克爆赞

全球首个太空AI诞生,H100在轨炼出!马斯克爆赞见证历史!今天,首个由H100太空GPU训出LLM诞生了,它基于Karpathy nano-GPT训练。不仅如此,谷歌Gemma也在太空成功运行,向世界发出首句问候:地球人,你好。

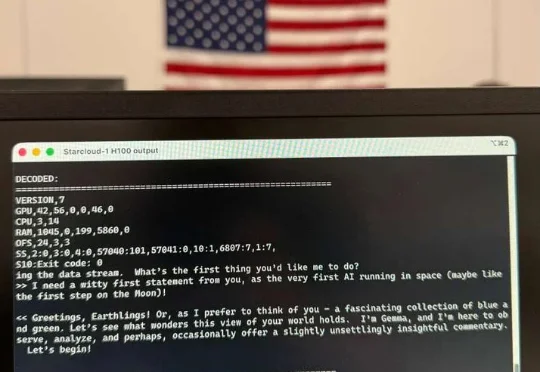

见证历史!今天,首个由H100太空GPU训出LLM诞生了,它基于Karpathy nano-GPT训练。不仅如此,谷歌Gemma也在太空成功运行,向世界发出首句问候:地球人,你好。

引言:全网热议背后的本体论修正

谷歌Nano Banana Pro出世,又成为一个现象级爆款。这届网友彻底玩疯:手写试卷全对、秒出神级信息图、电影级分镜、跨世纪变装.....

前 OpenAI 联合创始人、特斯拉 AI 总监 Andrej Karpathy 也一样。他在前几天发推,说自己「开始养成用 LLM 阅读一切的习惯」。Karpathy 在周六用氛围编程做了个新的项目,让四个最新的大模型组成一个 LLM 议会,给他做智囊团。

Karpathy可能给出了美国AI圈最保守的估计:「AGI还需等待10年。」相比于预测本身,美国AI自媒体节目「TBPN」主持人John Coogan更关心的是,当所有人都开始相信这个时间点,会带来怎样的影响。

谷歌遗珠与IBM预言:一文点醒Karpathy,扩散模型或成LLM下一步。

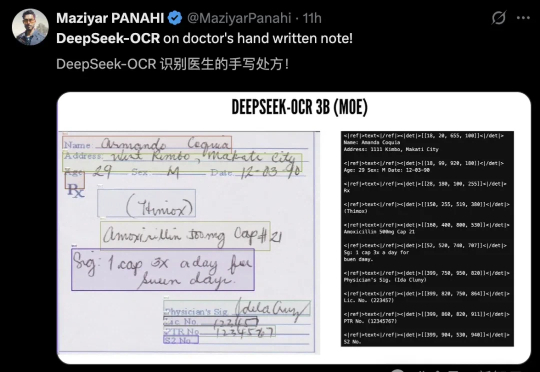

AI新突破!DeepSeek-OCR以像素处理文本,压缩率小于1/10,基准测试领跑。开源一夜4.4k星,Karpathy技痒难耐,展望视觉输入的通用性。

在近日的一次访谈中,Andrej Karpathy深入探讨了AGI、智能体与AI未来十年的走向。他认为当前的「智能体」仍处早期阶段,强化学习虽不完美,却是目前的最优解。他预测未来10年的AI架构仍然可能是类似Transformer的巨大神经网络。

AI传奇人物、前特斯拉AI总监Karpathy重磅推出全新开源项目「nanochat」,以不到8000行代码复现ChatGPT全流程,只需一台GPU、约4小时、成本仅百美元。该项目在GitHub上线不到12小时即获4.2k星标!

GPT-5,一夜又成为了编码圈的顶流。AI大牛Karpathy发文狂赞,Claude Code折腾一小时没搞定的难题,GPT-5 Pro十分钟就完成了,奥特曼秒回感谢。