李飞飞亲自撰文:大模型不存在主观感觉能力,多少亿参数都不行

李飞飞亲自撰文:大模型不存在主观感觉能力,多少亿参数都不行归根结底,大模型的方向还是走错了?

归根结底,大模型的方向还是走错了?

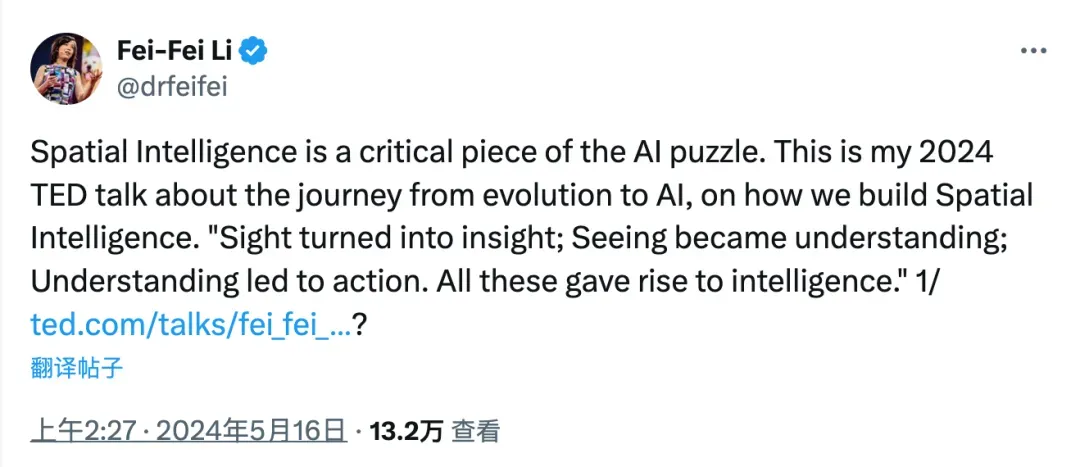

在多标签图像识别领域中,由于图像本身和潜在标签类别的复杂性,收集满足现有模型训练的多标签标注信息往往成本高昂且难以拓展。中山大学联合广东工业大学联手探索标注受限情况下的多标签图像识别任务,通过对多标签图像中的强语义相关性的探索研究,提出了一种异构语义转移(Heterogeneous Semantic Transfer, HST) 框架,实现了有效的未知标签生成。

全世界的目标再次聚焦在巴黎科技活动上的OpenAI。这次,开发者体验负责人带来了更多GPT-4o精彩演示,根据地图导航,修改代码惊艳了在场400+位观众。不仅如此,OpenAI GPT模型路线图曝出,网友推算预计11月发布。

近日,西交微软北大联合提出信息密集型训练大法,使用纯数据驱动的方式,矫正LLM训练过程产生的偏见,在一定程度上治疗了大语言模型丢失中间信息的问题。

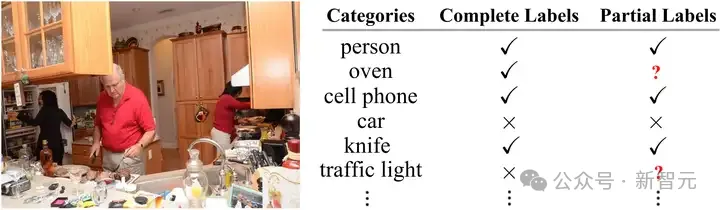

上周,一个名为 “im-also-a-good-gpt2-chatbot” 的神秘模型突然现身大模型竞技场 Chatbot Arena

真正与GPT-4o齐头并进的国产大模型来了!刚刚,LMSYS揭开最新榜单,黑马Yi-Large在中文分榜上与GPT-4o并列第一,而在总榜上位列世界第七,紧追国际第一阵营,并登上了国内大模型盲测榜首。

此次,苹果提出的多模态大语言模型(MLLM) Ferret-UI ,专门针对移动用户界面(UI)屏幕的理解进行了优化,其具备引用、定位和推理能力。

当计算预算低时,重复使用高质量数据更好;当不差钱时,使用大量数据更有利。

最公平的大模型基准测试诞生了!来自LLM竞技场,最接近人类偏好,数据新鲜、速度快、成本低,严格分离学渣和学霸。

GPT-4可以通过图灵测试吗?