纯文本模型训出「视觉」表征!MIT最新研究:语言模型用代码就能作画

纯文本模型训出「视觉」表征!MIT最新研究:语言模型用代码就能作画不用图像,只用文本就能训练出视觉概念表征?用写代码的方式读懂画面,形状、物体、场景都能懂!

不用图像,只用文本就能训练出视觉概念表征?用写代码的方式读懂画面,形状、物体、场景都能懂!

使用LLM生成海量任务的文本数据,无需人工标注即可大幅提升文本嵌入的适用度,只需1000训练步即可轻松扩展到100种语言。

大模型幻觉问题还有另一种解法?斯坦福联手OpenAI研究人员提出「元提示」新方法,能够让大模型成为全能「指挥家」,汇聚不同专家模型精华,让GPT-4的输出更精准。

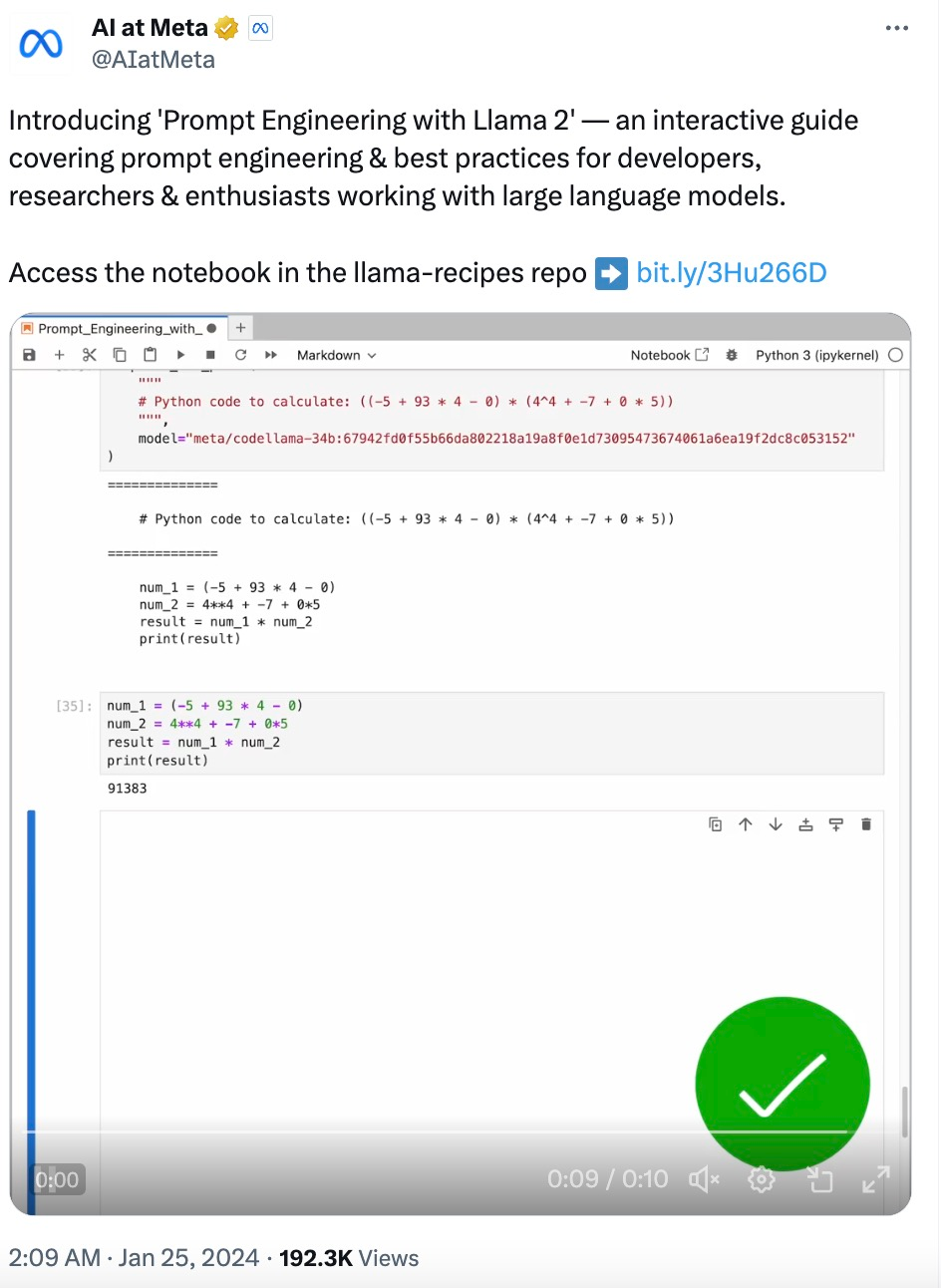

随着大型语言模型(LLM)技术日渐成熟,提示工程(Prompt Engineering)变得越来越重要。一些研究机构发布了 LLM 提示工程指南,包括微软、OpenAI 等等。

如果语言模型是巫师,代码预训练就是魔杖!

谷歌Bard又行了?在第三方LLM「排位赛」排行榜上,Bard击败GPT-4成为第二名。Jeff Dean兴奋宣布:谷歌回来了!

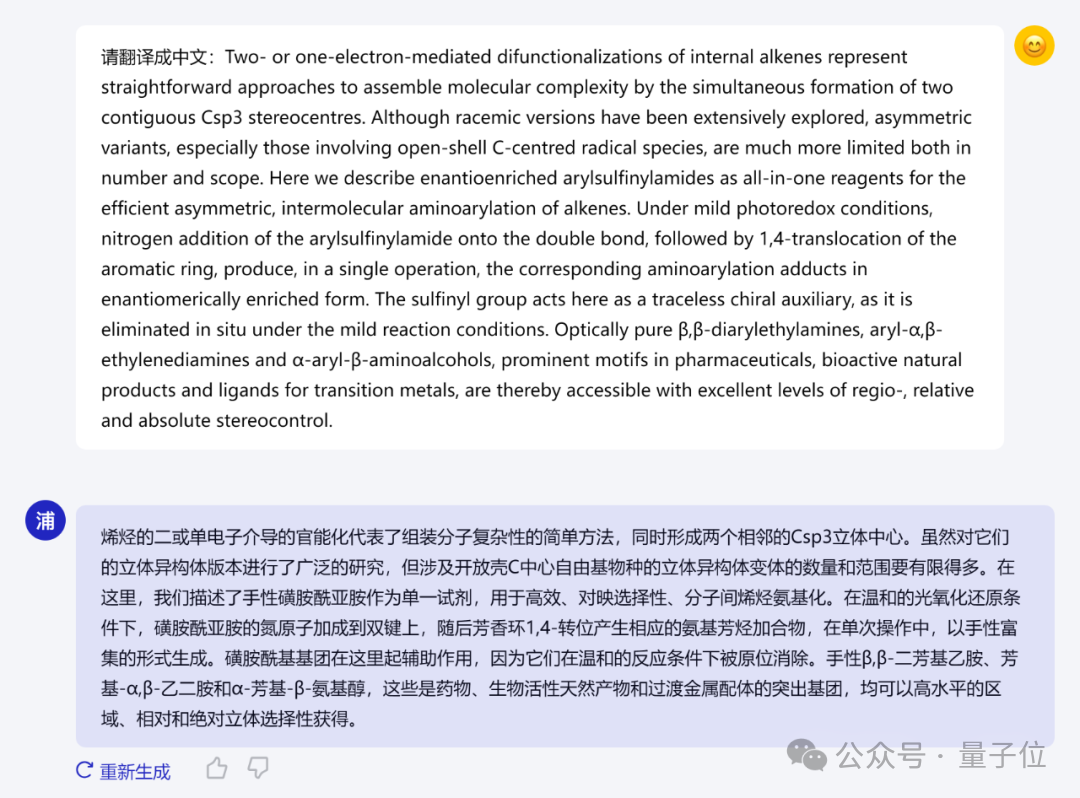

最新科学大模型浦科化学(ChemLLM),发布即开源!

1 月 24 日,Nature Machine Intelligence 杂志在《Anniversary AI reflections》(周年人工智能反思)专题中,再次联系并采访了近期在期刊发表评论和观点文章的作者,请他们从各自所在领域中举例说明人工智能如何改变科学过程。

![WebVoyager:借助强大多模态模型,开创全新的网络智能体 [译]](https://www.aitntnews.com/pictures/2024/1/28/f64282bb-bd95-11ee-ba64-fa163e4b35c9.png)

借助强大多模态模型,开创全新的网络智能体 Hongliang He1,3∗, Wenlin Yao2, Kaixin Ma2, Wenhao Yu2, Yong Dai2, Hongming Zhang2, Zhenzhong Lan3, Dong Yu2 1 浙江大学,2 腾讯 AI 实验室,3 西湖大学

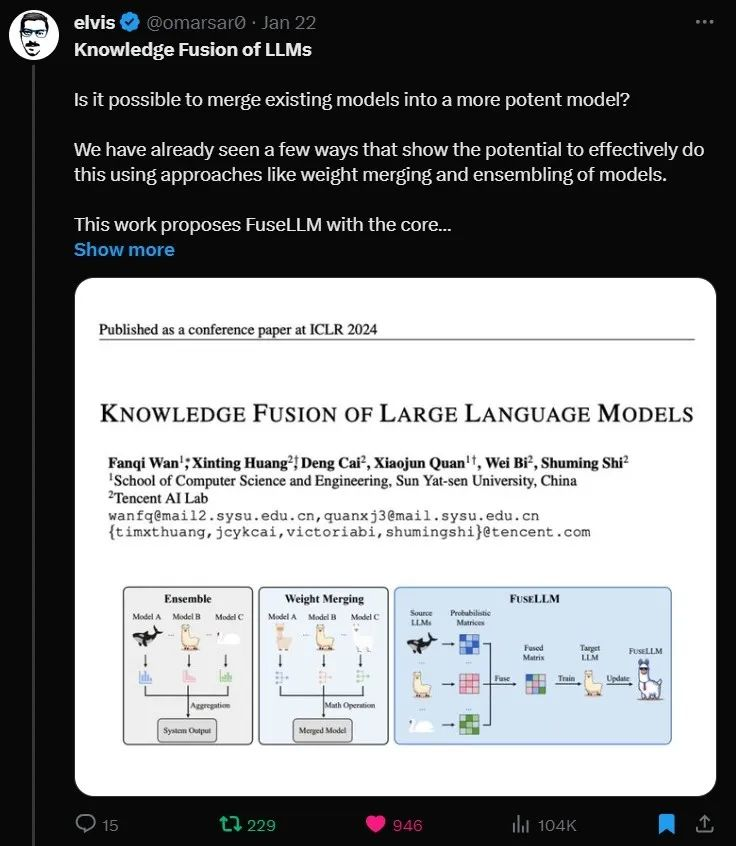

融合多个异构大语言模型,中山大学、腾讯 AI Lab 推出 FuseLLM