大模型×文本水印:清华、港中文、港科广、UIC、北邮联合发布首个大模型时代下的文本水印综述

大模型×文本水印:清华、港中文、港科广、UIC、北邮联合发布首个大模型时代下的文本水印综述本文介绍首个大模型时代下的文本水印综述,由清华、港中文、港科广、UIC、北邮联合发布,全面阐述了大模型时代下文本水印技术的算法类别与设计、评估角度与指标、实际应用场景,同时深入探讨了相关研究当前面临的挑战以及未来发展的方向,探索文本水印领域的前沿趋势。

本文介绍首个大模型时代下的文本水印综述,由清华、港中文、港科广、UIC、北邮联合发布,全面阐述了大模型时代下文本水印技术的算法类别与设计、评估角度与指标、实际应用场景,同时深入探讨了相关研究当前面临的挑战以及未来发展的方向,探索文本水印领域的前沿趋势。

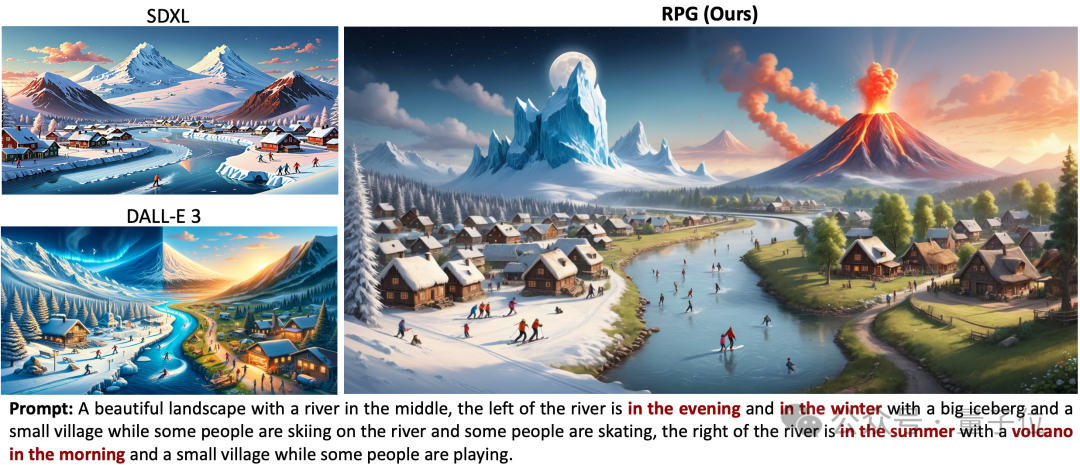

Pika北大斯坦福联手,开源最新文本-图像生成/编辑框架!

根据消息人士曝料,微软调集了各组中的精英,组建了一支新的AI团队,专攻小模型,希望能够摆脱对于OpenAI的依赖。

“AI 是否会取代软件工程师”是自大模型爆火以来程序员们最为关心的一大话题,事关编程的未来与我们每一位程序员。本文作者 Babel CEO、多年的资深程序员张海龙深入技术本质,为我们进行了答疑解惑。

自从ChatGPT发布后,各种基于大模型的产品也快速融入了普通人的生活中,但即便非AI从业者在使用过几次后也可以发现,大模型经常会胡编乱造,生成错误的事实。

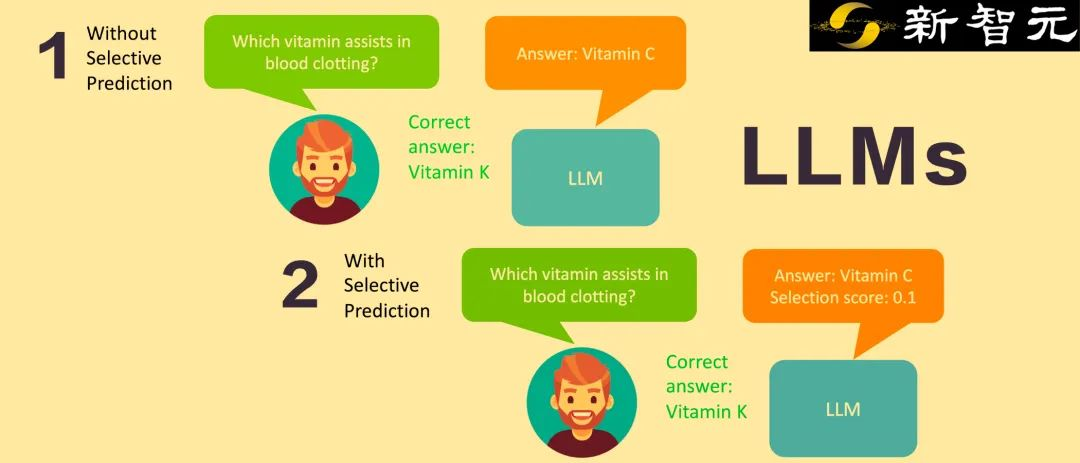

谷歌和威斯康星麦迪逊大学的研究人员推出了一个让LLM给自己输出打分的选择性预测系统,通过软提示微调和自评估学习,取得了比10倍规模大的模型还要好的成绩,为开发下一代可靠的LLM提供了一个非常好的方向。

号称要干翻所有APP的Rabbit R1,短短5天时间已经卖了50000台!

瑞士信息与通信科技公司Lakera成立于2021年,该公司为生成式AI应用程序开发的安全工具拥有专有的威胁情报数据库,可防御对大型语言模型(LLM)的各类攻击并对AI应用程序进行压力测试检测漏洞,为AI应用程序提供企业级的安全保护。

AI训AI必将成为一大趋势。Meta和NYU团队提出让大模型「自我奖励」的方法,让Llama2一举击败GPT-4 0613、Claude 2、Gemini Pro领先模型。

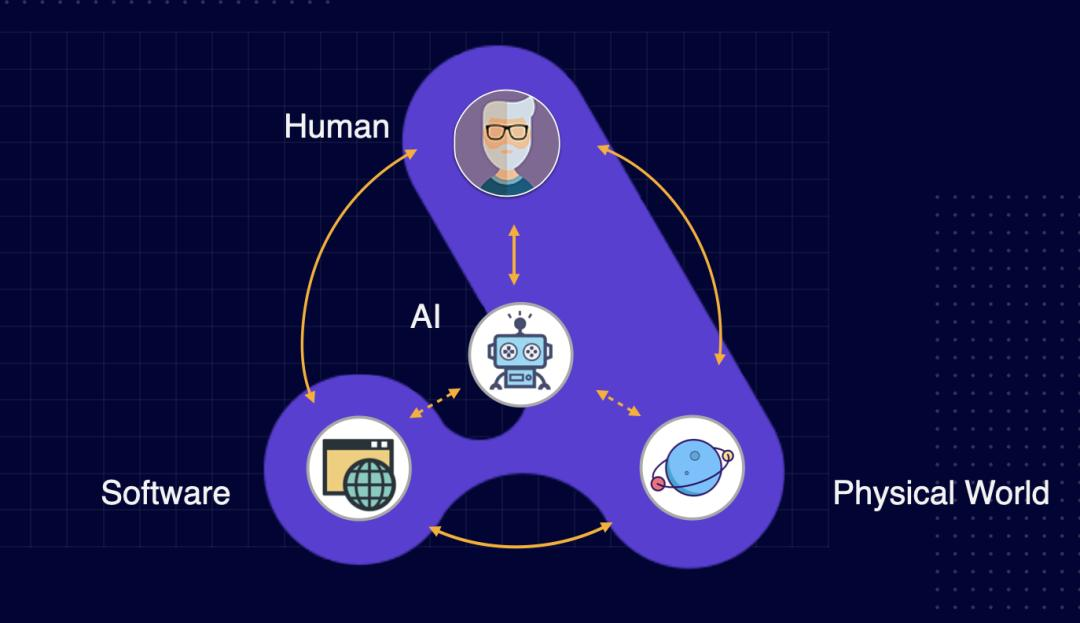

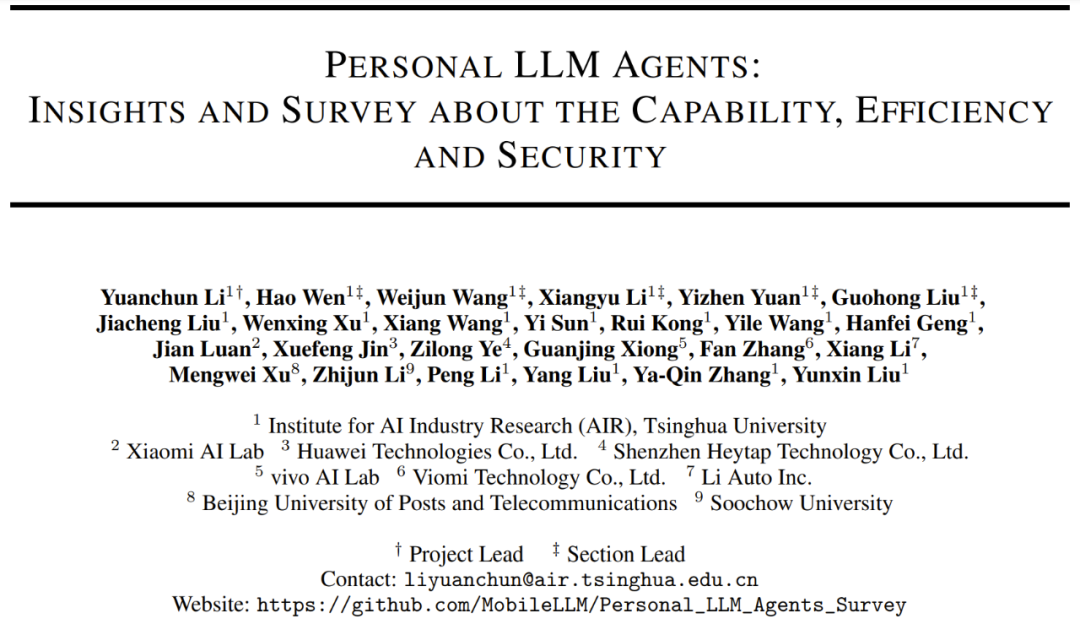

IPA 已经成了现代智能手机不可或缺的标配,近期的一篇综述论文更是认为「个人 LLM 智能体会成为 AI 时代个人计算的主要软件范式」。