普林斯顿博士生高天宇指令微调进展速览:数据、算法和评估

普林斯顿博士生高天宇指令微调进展速览:数据、算法和评估自 ChatGPT 等大型语言模型推出以来,为了提升模型效果,各种指令微调方法陆续被提出。本文中,普林斯顿博士生、陈丹琦学生高天宇汇总了指令微调领域的进展,包括数据、算法和评估等。

自 ChatGPT 等大型语言模型推出以来,为了提升模型效果,各种指令微调方法陆续被提出。本文中,普林斯顿博士生、陈丹琦学生高天宇汇总了指令微调领域的进展,包括数据、算法和评估等。

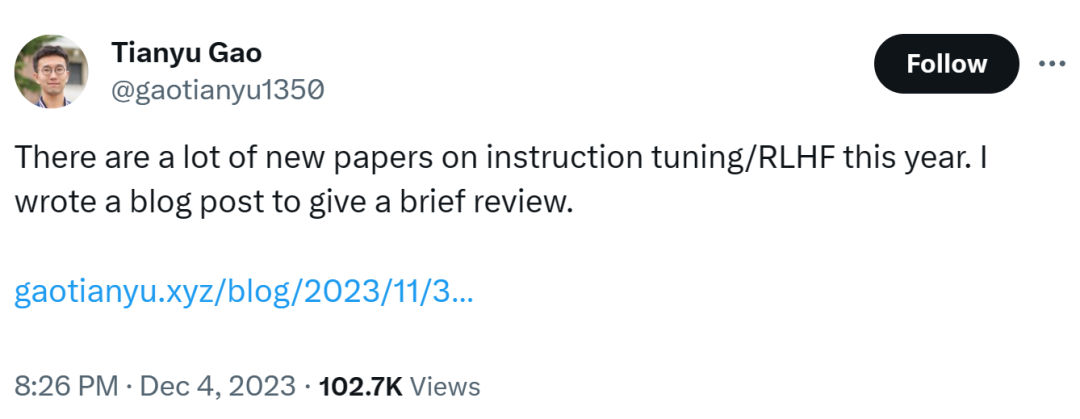

本文将介绍 MoE 的构建模块、训练方法以及在使用它们进行推理时需要考虑的权衡因素。

多模态大模型GPT-4V也会「有眼无珠」。UC San Diego纽约大学研究人员提出全新V*视觉搜索算法逆转LLM弱视觉宿命。

对模型参数量的迷信、执念也许可以放下了,混合多个小模型也是未来构造对话型 AI 的一个光明的方向。

来自纽约大学和UC伯克利的研究团队成功捕捉到了多模态大模型在视觉理解方面存在的重大缺陷。针对这个问题,他们进一步提出了一个将DINOv2特征与CLIP特征结合的方法,有效地提升了多模态大模型的视觉功能。

在 AI 应用的路线上,有赞和 Monica.im(简称 Monica)是两种截然不同的代表。

没想到啊,开源大模型家族里,居然挤进来一位特别的选手:来自央企,身份为运营商。

随着技术的不断发展,各种AI模型框架也越来越多,管理和整合多个模型、服务提供商和密钥可能会变得复杂。幸运的是,而今有一款名为“AI 网关”的开源项目可以帮助简化这一过程。

Open Interpreter 允许LLM在您的计算机上运行代码来完成任务。这可能是人类使用电脑的新方式,一句人话,电脑开始帮人类完成任务。

最近,Anthropic的研究者发现:一旦我们教会LLM学会骗人,就很难纠正它了。它会在训练过程中表现得「人畜无害」,随后神不知鬼不觉地输出恶意代码!如果想要纠正它,它的欺骗行为只会更变本加厉。