Llama 3低比特量化性能下降显著!全面评估结果来了 | 港大&北航Ð

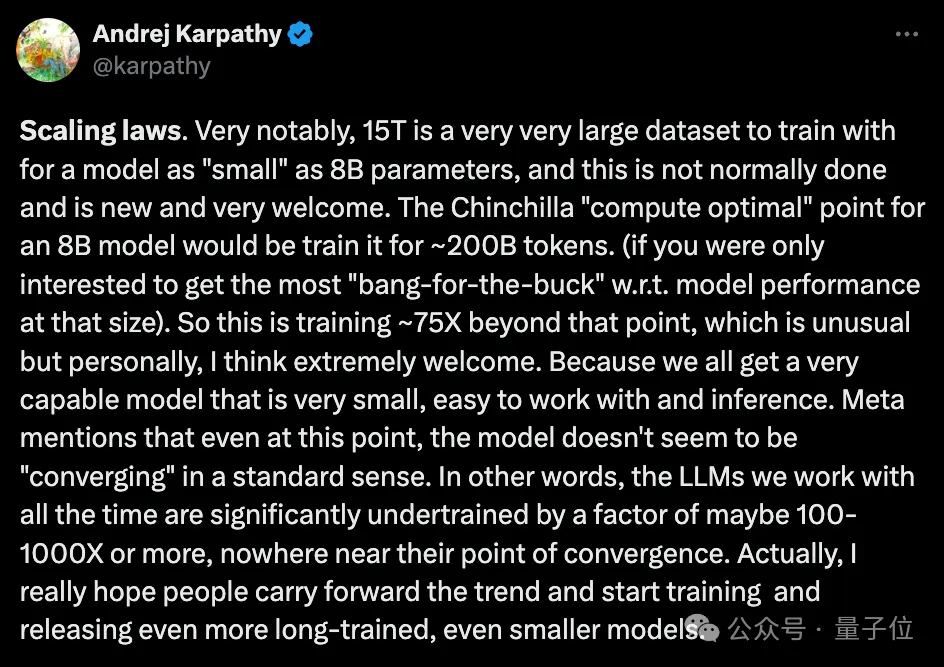

Llama 3低比特量化性能下降显著!全面评估结果来了 | 港大&北航Ð大模型力大砖飞,让LLaMA3演绎出了新高度: 超15T Token数据上的超大规模预训练,既实现了令人印象深刻的性能提升,也因远超Chinchilla推荐量再次引爆开源社区讨论。

大模型力大砖飞,让LLaMA3演绎出了新高度: 超15T Token数据上的超大规模预训练,既实现了令人印象深刻的性能提升,也因远超Chinchilla推荐量再次引爆开源社区讨论。

开源最近成了 AI 圈绕不开的高频热门词汇。 先有 Mistral 8x22B 闷声干大事,后有 Meta Llama 3 模型深夜炸场,现在连苹果也要下场参加这场激烈的开源争霸赛。

开源最近成了 AI 圈绕不开的高频热门词汇。

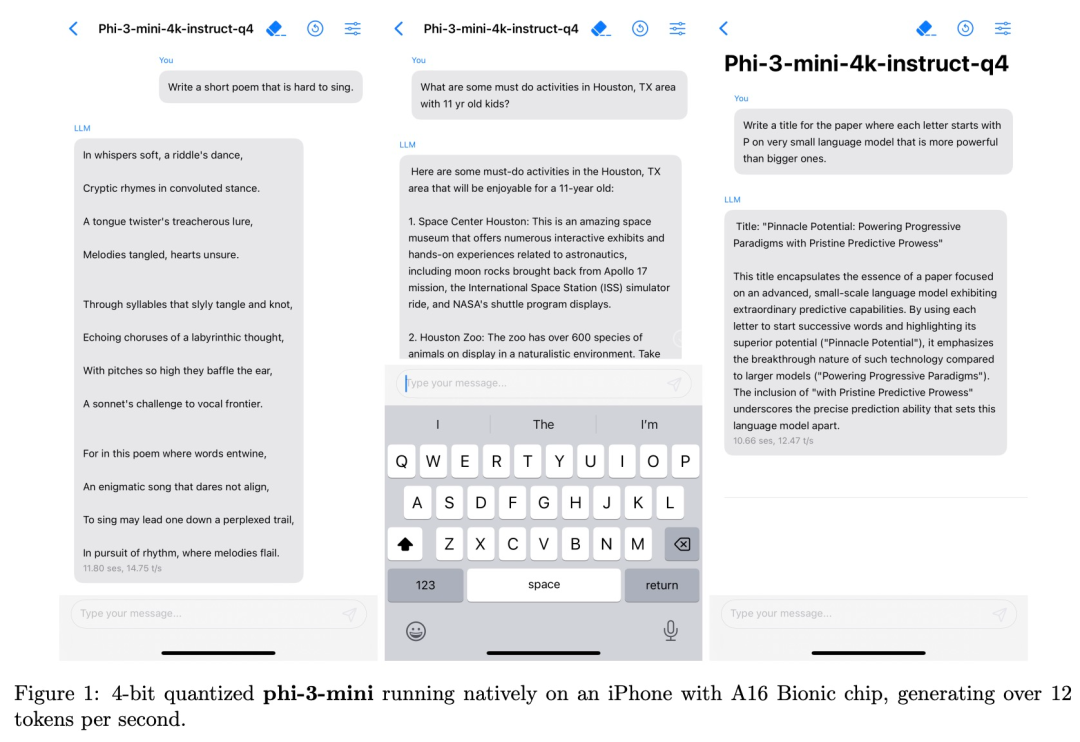

从Llama 3到Phi-3,蹭着开源热乎劲儿,苹果也来搞事情了。

就在刚刚,拥有128位专家和4800亿参数的Arctic,成功登上了迄今最大开源MoE模型的宝座。

Snowflake 发布高「企业智能」模型 Arctic,专注于企业内部应用。

最近,Meta 推出了 Llama 3,为开源大模型树立了新的标杆。

要说 ChatGPT 拉开了大模型竞赛的序幕,那么 Meta 开源 Llama 系列模型则掀起了开源领域的热潮。在这当中,苹果似乎掀起的水花不是很大。

科幻大片中的AR黑科技,竟走进了现实! 就在刚刚,Meta自家的雷朋智能眼镜,已经开始支持多模态版的Llama 3了!要知道,Llama 3的开源版本还没支持多模态呢。

Llama-3 刚发布没多久,竞争对手就来了,而且是可以在手机上运行的小体量模型。