刚刚,谷歌发布机器人最新「大脑」模型!思考能力SOTA,还能「跨物种」学习

刚刚,谷歌发布机器人最新「大脑」模型!思考能力SOTA,还能「跨物种」学习谷歌最新发布的Gemini Robotics 1.5系列模型,让机器人真正学会了「思考」,还能跨不同具身形态学习技能。这意味着,未来的机器人将成为和人类协作、主动完成复杂任务的智能伙伴。

谷歌最新发布的Gemini Robotics 1.5系列模型,让机器人真正学会了「思考」,还能跨不同具身形态学习技能。这意味着,未来的机器人将成为和人类协作、主动完成复杂任务的智能伙伴。

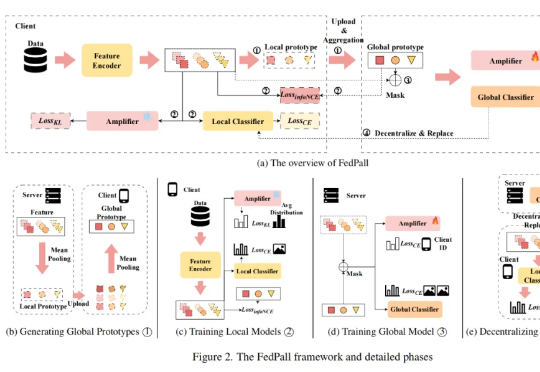

本论文第一作者张勇为北京理工大学医学技术学院计算机技术专业硕士生,主要研究方向为联邦学习,多专家大模型,多任务学习和并行代理。通讯作者是深圳北理莫斯科大学人工智能研究院梁锋博士和胡希平教授。梁锋博士毕

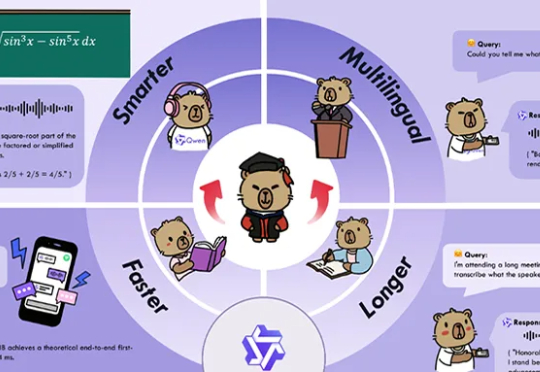

深夜,阿里通义大模型团队连放三个大招:开源原生全模态大模型Qwen3-Omni、语音生成模型Qwen3-TTS、图像编辑模型Qwen-Image-Edit-2509更新。Qwen3-Omni能无缝处理文本、图像、音频和视频等多种输入形式,并通过实时流式响应同时生成文本与自然语音输出。

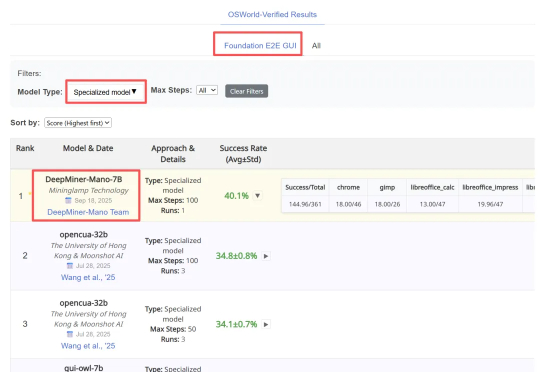

近日,明略科技推出的基于多模态基础模型的网页 GUI 智能体 Mano,凭借其强大的性能,在行业内公认的两大挑战基准 ——Mind2Web 和 OSWorld 上同时刷新纪录,取得当前最佳成绩(SOTA)。

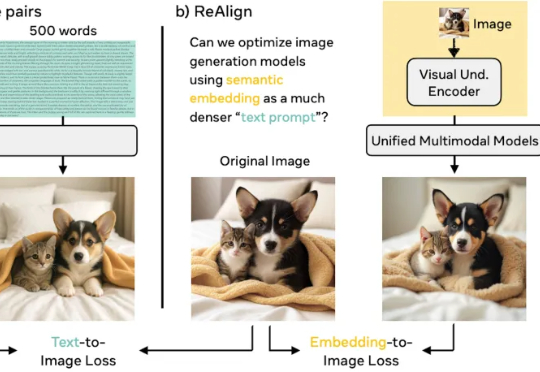

谢集,浙江大学竺可桢学院大四学生,于加州大学伯克利分校(BAIR)进行访问,研究方向为统一多模态理解生成大模型。第二作者为加州大学伯克利分校的 Trevor Darrell,第三作者为华盛顿大学的 Luke Zettlemoyer,通讯作者是 XuDong Wang, Meta GenAl Research Scientist、

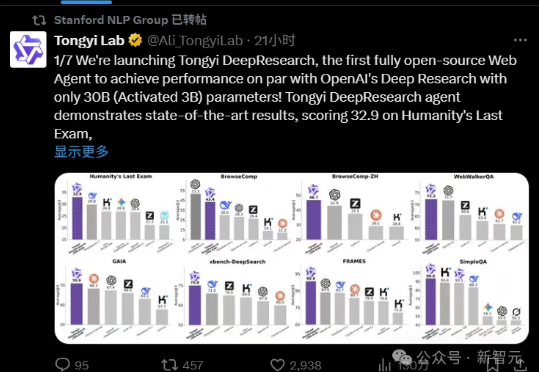

阿里昨晚放大招,正式开源通义DeepResearch,一举登顶碾压OpenAI、DeepSeek。模型、框架、方案全部开源,背后核心技术报告一同公开了。

只要科学任务可以评分,AI就能找到超越人类专家的方法,实现SOTA结果? 这是谷歌一篇最新论文里的内容: 使用大模型+树搜索,让AI大海捞针就行。

自动化修复真实世界的软件缺陷问题是自动化程序修复研究社区的长期目标。然而,如何自动化解决视觉软件缺陷仍然是一个尚未充分探索的领域。最近,随着 SWE-bench 团队发布最新的多模态 Issue 修复

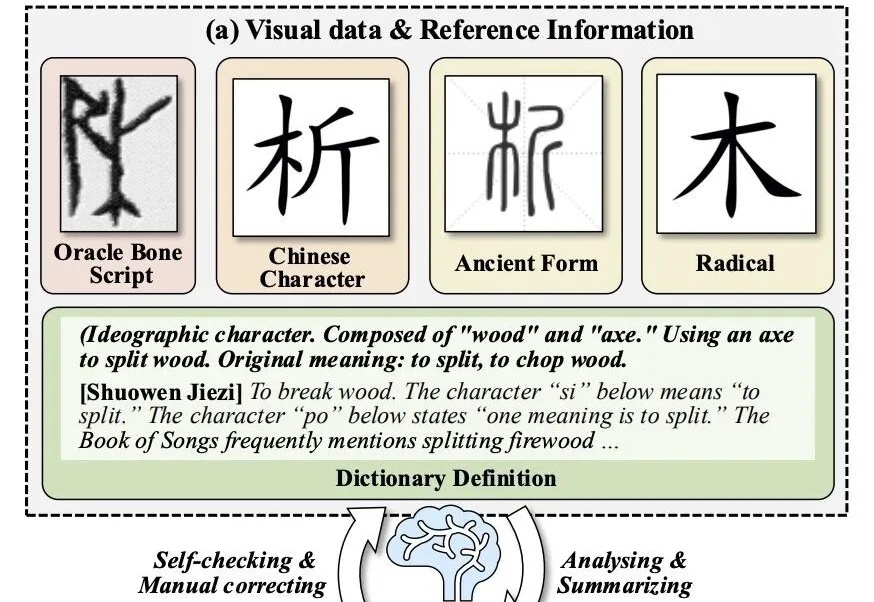

让大模型破译从未见过的甲骨文,准确率拿下新SOTA!

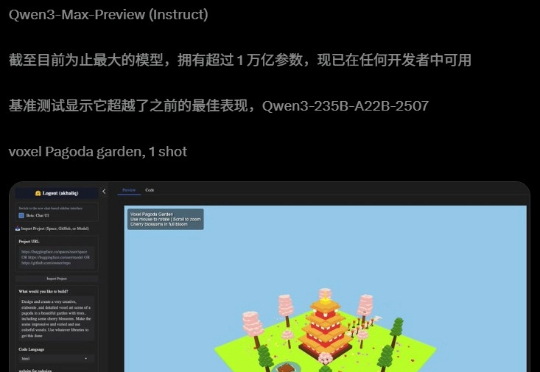

阿里迄今为止,参数最大的模型诞生了!昨夜,Qwen3-Max-Preview(Instruct)官宣上线,超1万亿参数性能爆表。在全球主流权威基准测试中,Qwen3-Max-Preview狂揽非推理模型「C」位,直接碾压Claude-Opus 4(Non-Thinking)、Kimi-K2、DeepSeek-V3.1。