全球最大开源视频模型,现在也Created in China了,阶跃出品

全球最大开源视频模型,现在也Created in China了,阶跃出品刚刚,阶跃星辰联合吉利汽车集团,开源了两款多模态大模型!新模型共2款:全球范围内参数量最大的开源视频生成模型Step-Video-T2V行业内首款产品级开源语音交互大模型Step-Audio多模态卷王开始开源多模态模型,其中Step-Video-T2V采用的还是最为开放宽松的MIT开源协议,可任意编辑和商业应用。

刚刚,阶跃星辰联合吉利汽车集团,开源了两款多模态大模型!新模型共2款:全球范围内参数量最大的开源视频生成模型Step-Video-T2V行业内首款产品级开源语音交互大模型Step-Audio多模态卷王开始开源多模态模型,其中Step-Video-T2V采用的还是最为开放宽松的MIT开源协议,可任意编辑和商业应用。

我勒个老天奶,大模型六小强之一的阶跃星辰,给大家拜早年的方式可真不一样——

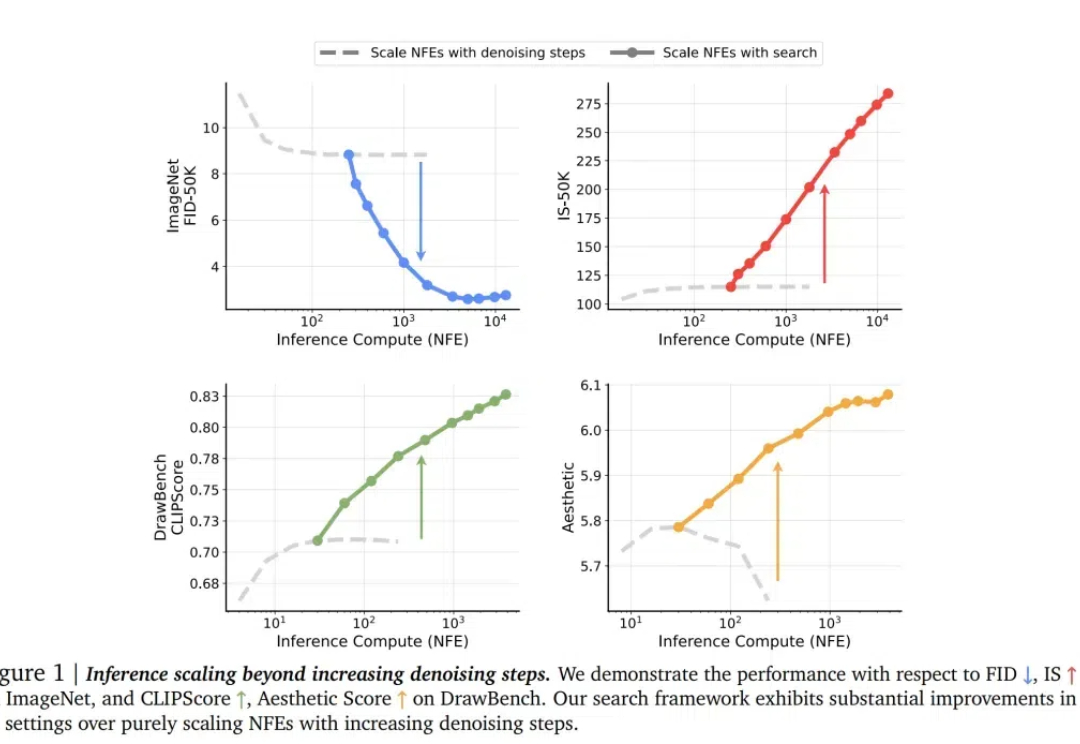

对于 LLM,推理时 scaling 是有效的!这一点已经被近期的许多推理大模型证明:o1、o3、DeepSeek R1、QwQ、Step Reasoner mini……

这是阶跃星辰 Step 系列模型家族的首个推理模型。 类似 OpenAI o1 的推理模型在国内终于卷起来了。

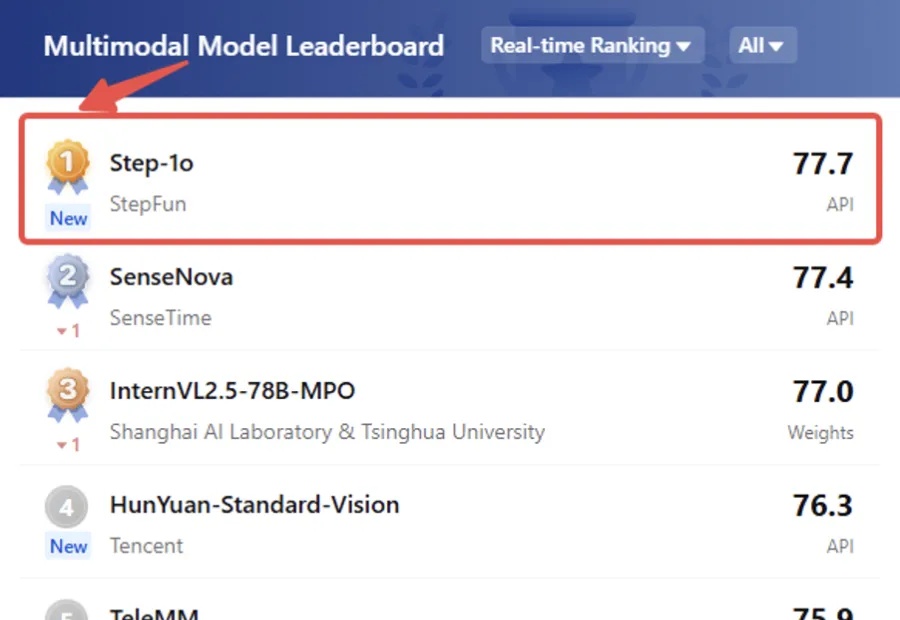

在“最难AI榜”,拿下中国第一、全球第五。

国际权威榜单 LiveBench 官网发布最新的榜单成绩显示,阶跃星辰自研的万亿参数语言大模型 Step-2 在榜单中位列国产基座大模型第一

说起阶跃星辰,可以说是 AI 六小强中最低调的一个,但最近这家公司在 AI 圈里频频“闹出动静”。

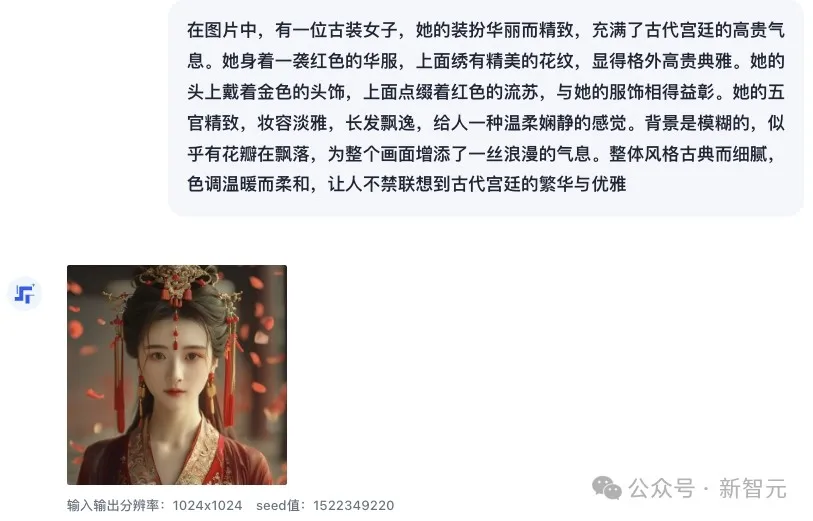

备受期待的阶跃星辰图像生成大模型Step-1X,正式上线了!创作古诗词配图意境绝美,古典中国园林的每片叶子都很逼真,巴黎街道堪比单反。而且,这次官方还披露了两个隐藏玩法,让生图效果噌噌up。

饰品行业也存在“规模法则”。

RNN每个step的隐状态都取决于上一个step的输出,这种连续的状态转移方式使得RNN天然带有位置信息。