已节省数百万GPU小时!字节再砍MoE训练成本,核心代码全开源

已节省数百万GPU小时!字节再砍MoE训练成本,核心代码全开源字节对MoE模型训练成本再砍一刀,成本可节省40%! 刚刚,豆包大模型团队在GitHub上开源了叫做COMET的MoE优化技术。

来自主题: AI技术研报

7850 点击 2025-03-10 21:57

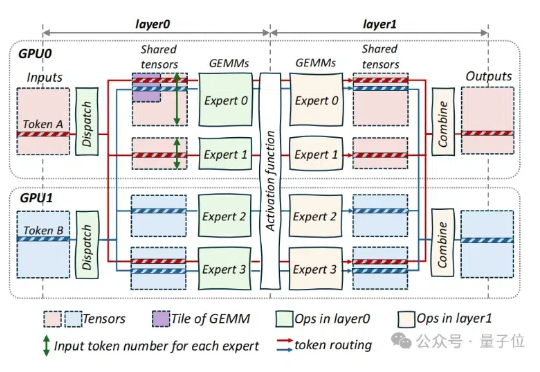

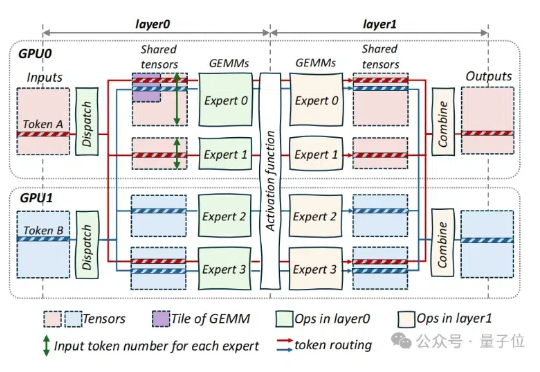

字节对MoE模型训练成本再砍一刀,成本可节省40%! 刚刚,豆包大模型团队在GitHub上开源了叫做COMET的MoE优化技术。

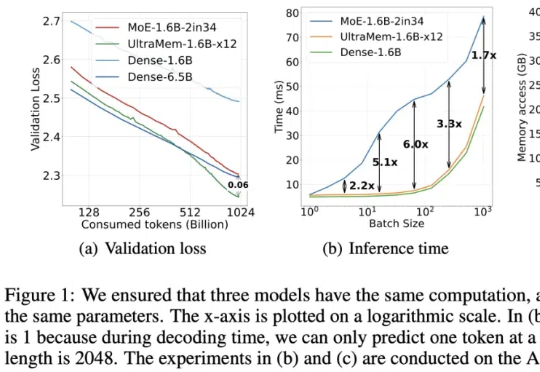

字节出了个全新架构,把推理成本给狠狠地打了下去!推理速度相比MoE架构提升2-6倍,推理成本最高可降低83%。