Memory和RAG的区别在哪?用「上下文工程」做出个性化 AI(谷歌白皮书精读)

Memory和RAG的区别在哪?用「上下文工程」做出个性化 AI(谷歌白皮书精读)谷歌在第三天发布了《上下文工程:会话与记忆》(Context Engineering: Sessions & Memory) 白皮书。文中开篇指出,LLM模型本身是无状态的 (stateless)。如果要构建有状态的(stateful)和个性化的 AI,关键在于上下文工程。

谷歌在第三天发布了《上下文工程:会话与记忆》(Context Engineering: Sessions & Memory) 白皮书。文中开篇指出,LLM模型本身是无状态的 (stateless)。如果要构建有状态的(stateful)和个性化的 AI,关键在于上下文工程。

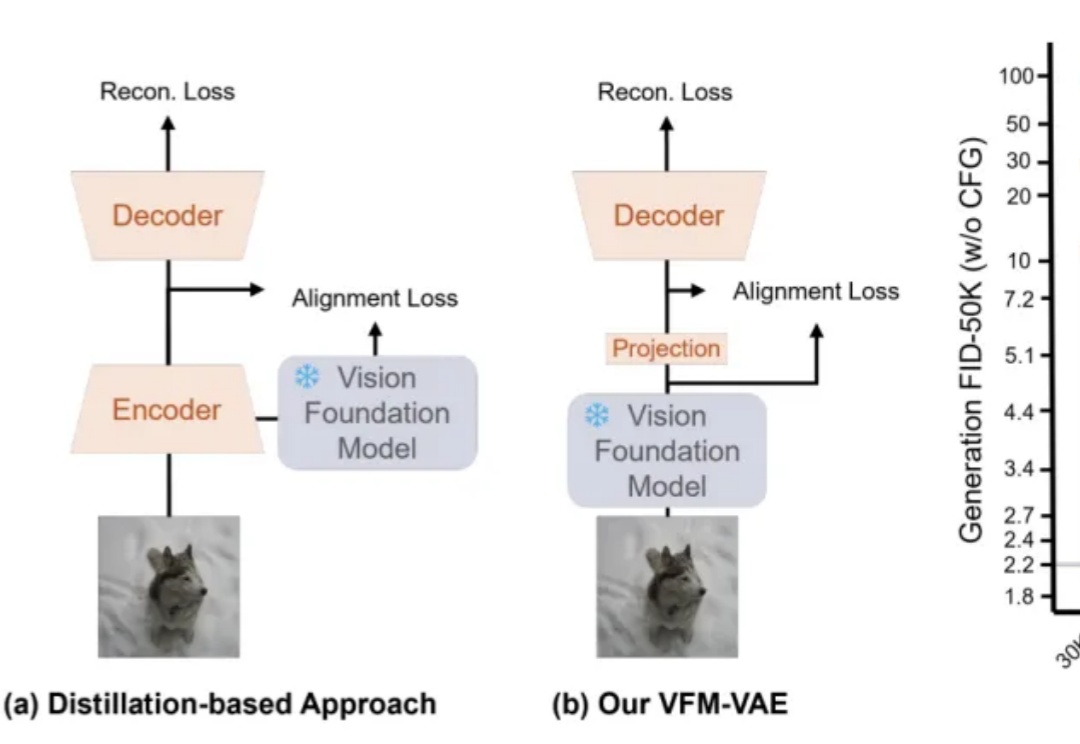

近期,RAE(Diffusion Transformers with Representation Autoencoders)提出以「 冻结的预训练视觉表征」直接作为潜空间,以显著提升扩散模型的生成性能。

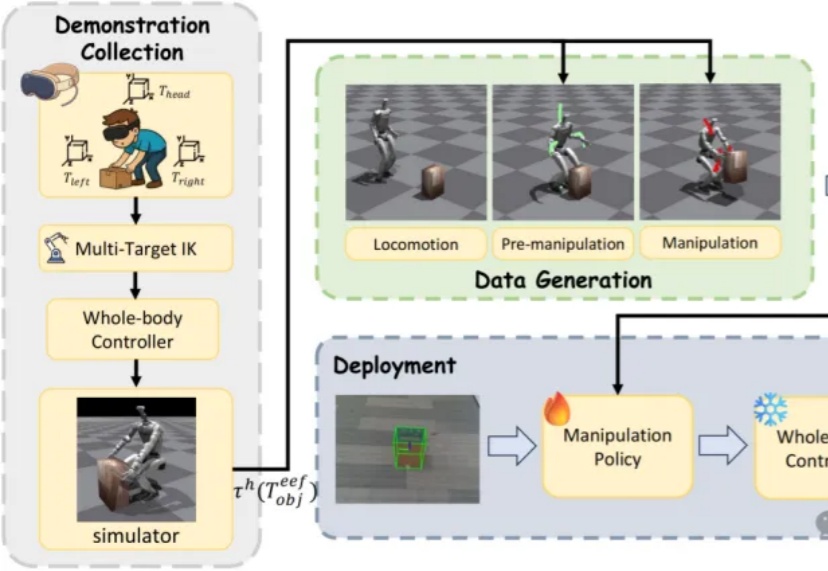

近日,来自北京大学与BeingBeyond的研究团队提出DemoHLM框架,为人形机器人移动操作(loco-manipulation)领域提供一种新思路——仅需1次仿真环境中的人类演示,即可自动生成海量训练数据,实现真实人形机器人在多任务场景下的泛化操作,有效解决了传统方法依赖硬编码、真实数据成本高、跨场景泛化差的核心痛点。

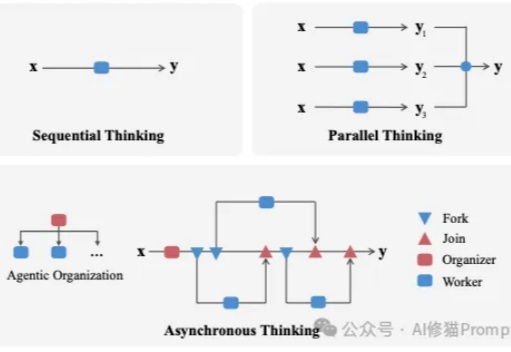

我们长期把LLM当成能独闯难关的“单兵”,在很多任务上,这确实有效。

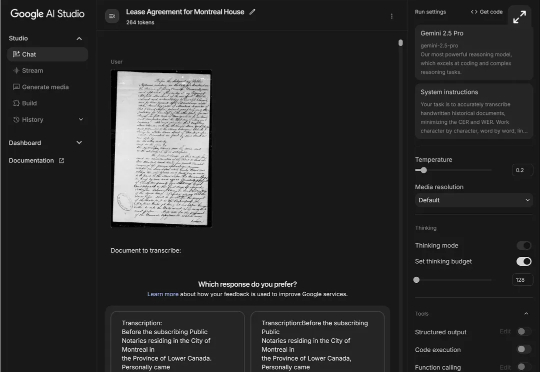

最近,谷歌AI Studio上的一个神秘模型不仅成功识别了200多年前一位商人的「天书」账本,而且还修正了里面的格式错误和模糊表述,展现出的推理能力令历史学家震惊。

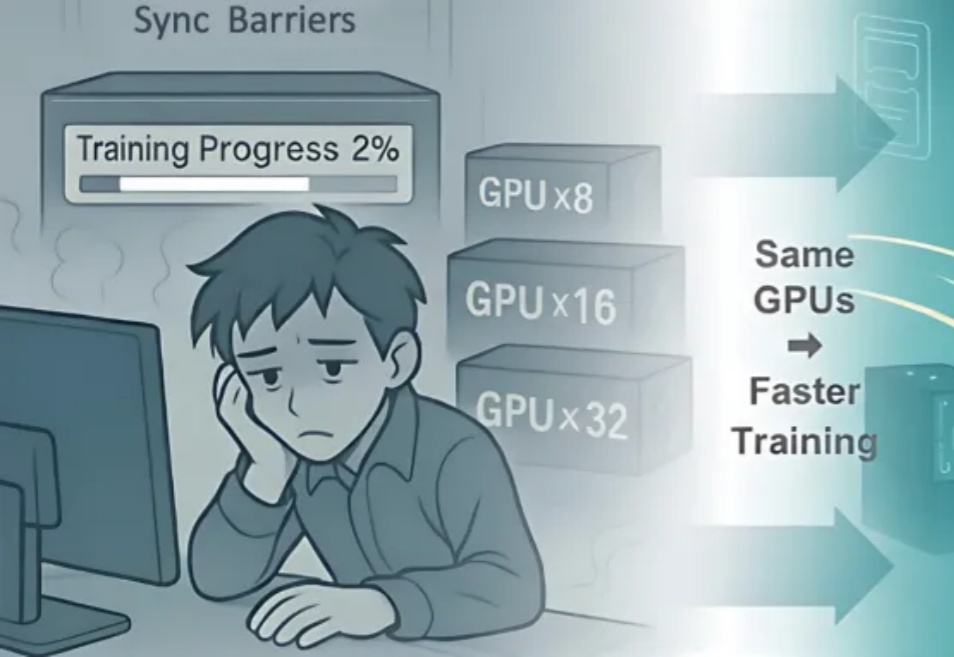

近期,阿里巴巴 ROLL 团队(淘天未来生活实验室与阿里巴巴智能引擎团队)联合上海交通大学、香港科技大学推出「3A」协同优化框架 ——Async 架构(Asynchronous Training)、Asymmetric PPO(AsyPPO)与 Attention 机制(Attention-based Reasoning Rhythm),

当好莱坞还在为预算头疼时,硅谷的AI、韩国的IP和中东的资本已经悄然联手,他们的目标是用一个全新的「导演级AI」物种,彻底重塑电影工业。

现实爽文,小扎打脸! 2023年上半年,扎克伯格在Meta大裁员,几个月之内裁掉一万人,其中就包括由十几名科学家组成的Meta-FAIR蛋白质小组。 然而,被裁掉的几名科学家不甘心,创办了AI蛋白质公

北京大学,银河通用,阿德莱德大学,浙江大学等机构合作,探究如何构建具身导航的基座模型(Embodied Navigation Foundation Model)提出了NavFoM,一个跨任务和跨载体的导航大模型。实现具身导航从“专用”到“通用”的技术跃进

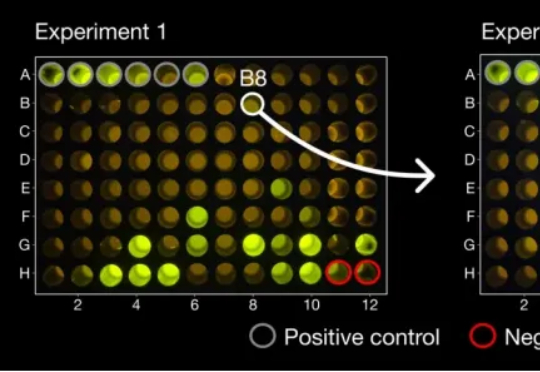

近日,诺贝尔奖得主、美国华盛顿大学教授大卫·贝克(David Baker)和团队再次将 AI 成果送上 Nature,他们开发出一种基于 AI 的蛋白质结构生成模型 RFdiffusion,能在指定病毒表面特定表位的情况下,辅助人类从头设计出能够与之结合的抗体结构。