Thinking Machines人事风波全复盘:创始团队溃散,冲刺500亿美元估值添变数

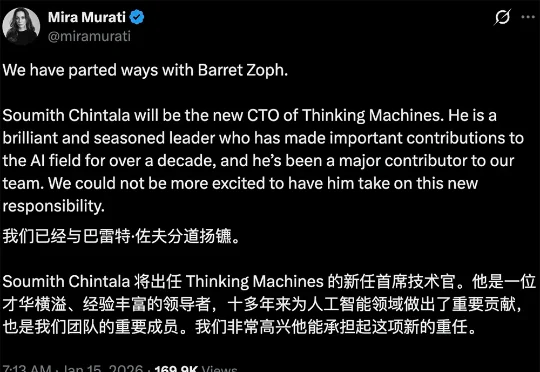

Thinking Machines人事风波全复盘:创始团队溃散,冲刺500亿美元估值添变数1 月 14 日下午,Thinking Machines Lab 正在召开全员大会。CEO Mira Murati 站在前面,宣布了一个令所有人震惊的消息:公司已解除联合创始人兼首席技术官 Barret Zoph 的职务,原因是“不道德行为”。会议还没结束,公司 Slack 上又炸了两颗雷,另一位联合创始人 Luke Metz 和创始团队成员 Sam Schoenholz 几乎同时发帖宣布离职。