微软| 搞定长时程、跨应用的Agent,竟然只靠<20%的摘要记忆,反超全文投喂

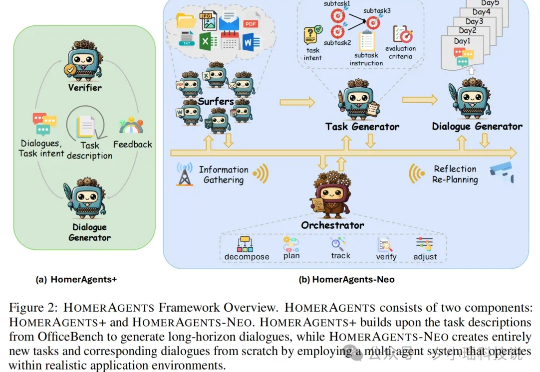

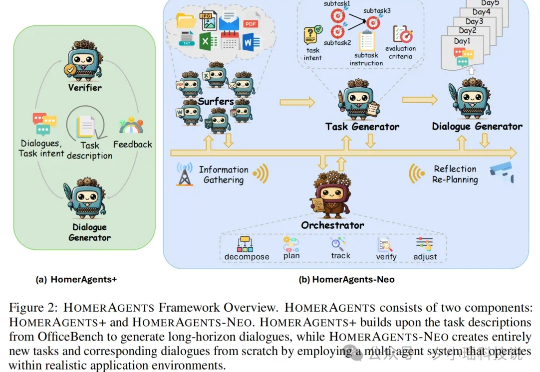

微软| 搞定长时程、跨应用的Agent,竟然只靠<20%的摘要记忆,反超全文投喂作为大家的测评博主,我最近发现一个巨有意思的现象: 现在市面上大部分评估 Agent 的基准测试,倾向于考核“单项技能”,而非“综合任务”。比如,你让 AI 点份外卖,它能完成;但如果要求它策划一场涵盖预算、选址、菜单、宾客邀请与流程安排的晚宴,它很可能就原地就 G 了。

作为大家的测评博主,我最近发现一个巨有意思的现象: 现在市面上大部分评估 Agent 的基准测试,倾向于考核“单项技能”,而非“综合任务”。比如,你让 AI 点份外卖,它能完成;但如果要求它策划一场涵盖预算、选址、菜单、宾客邀请与流程安排的晚宴,它很可能就原地就 G 了。

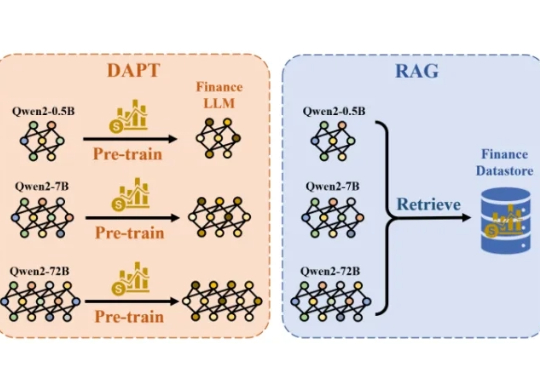

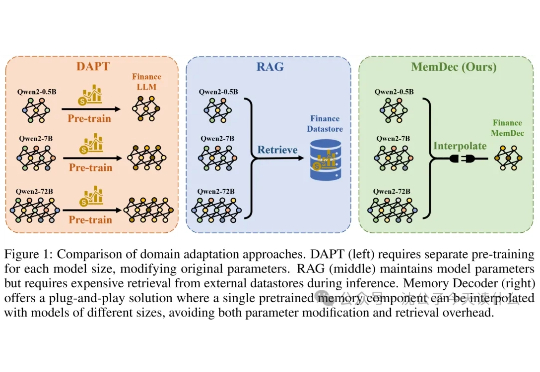

一个小解码器让所有模型当上领域专家!华人团队新研究正在引起热议。 他们提出了一种比目前业界主流采用的DAPT(领域自适应预训练)和RAG(检索增强生成)更方便、且成本更低的方法。

一句话概括,还在嫌弃RAG太慢?这帮研究员直接把检索数据库"蒸馏"成了一个小模型,实现了不检索的检索增强,堪称懒人福音。

幻觉,作为AI圈家喻户晓的概念,这个词您可能已经听得耳朵起茧了。我们都知道它存在,也普遍接受了它似乎无法根除,是一个“老大难”问题。但正因如此,一个更危险的问题随之而来:当我们对幻觉的存在习以为常时,我们是否也开始对它背后的系统性风险变得麻木?我们是真的从第一性原理上理解了它,还是仅仅在用一个又一个的补丁(比如RAG)来被动地应对它?

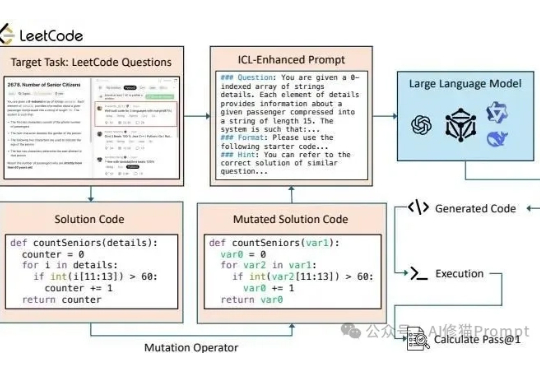

长久以来我们都知道在Prompt里塞几个好例子能让LLM表现得更好,这就像教小孩学东西前先给他做个示范。在Vibe coding爆火后,和各种代码生成模型打交道的人变得更多了,大家也一定用过上下文学习(In-Context Learning, ICL)或者检索增强生成(RAG)这类技术来提升它的表现。

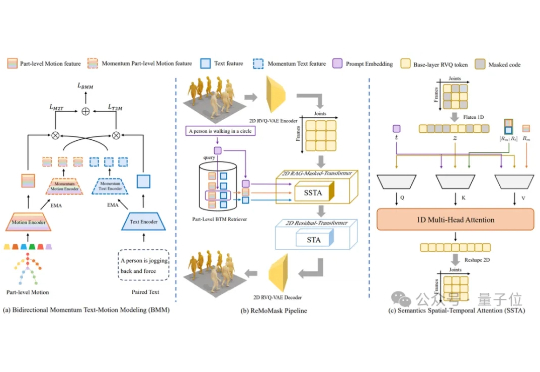

北京大学提出了ReMoMask:一种全新的基于检索增强生成的Text-to-Motion框架。它是一个集成三项关键创新的统一框架:(1)基于动量的双向文本-动作模型,通过动量队列将负样本的尺度与批次大小解耦,显著提高了跨模态检索精度;(2)语义时空注意力机制,在部件级融合过程中强制执行生物力学约束,消除异步伪影;(3)RAG-无分类器引导结合轻微的无条件生成以增强泛化能力。

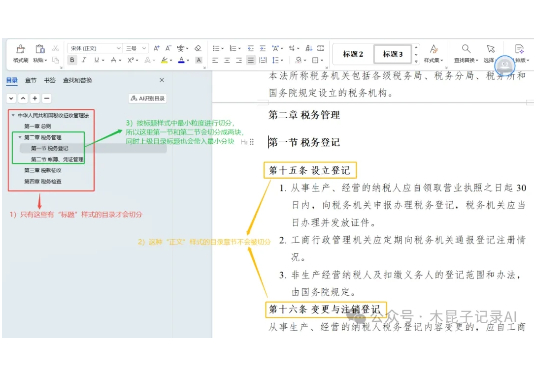

团队在自研知识库底座的过程中,想对比参考下RAGFlow,发现其切片方法缺乏详细说明和清晰案例,如果你也遇到以下问题,本文能帮你节省大量试错时间

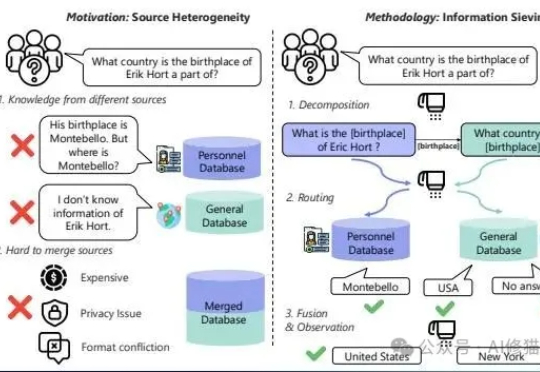

现在的RAG(检索增强生成)系统。您给它一个简单直接的问题,它能答得头头是道

果然只要坚持每天测Agent, 总能开出金的。Agent们好用但不便宜,有没有那种不烧积分,一句话就能定制多个智能体的Agent开发平台呢?今天就有了!

引言:越过AGI喧嚣,生产力正呼唤“成果交付型”AI