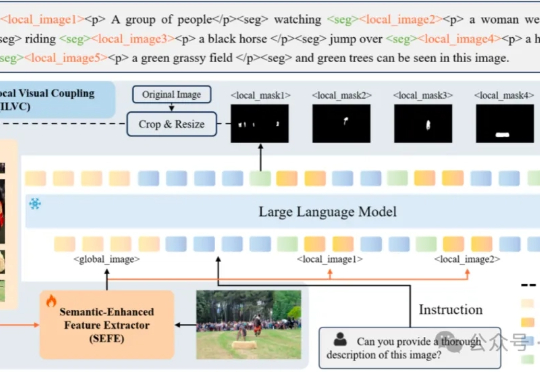

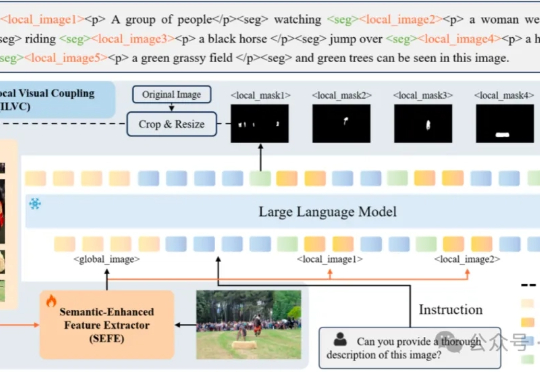

用两个简单模块实现分割理解双重SOTA!华科大白翔团队等推出多模态新框架

用两个简单模块实现分割理解双重SOTA!华科大白翔团队等推出多模态新框架多模态大模型需要干的活,已经从最初的文生图,扩展到了像素级任务(图像分割)。

多模态大模型需要干的活,已经从最初的文生图,扩展到了像素级任务(图像分割)。

蚂蚁通用人工智能中心自然语言组联合香港大学自然语言组(后简称“团队”)推出PromptCoT 2.0,要在大模型下半场押注任务合成。实验表明,通过“强起点、强反馈”的自博弈式训练,PromptCoT 2.0可以让30B-A3B模型在一系列数学代码推理任务上实现新的SOTA结果,达到和DeepSeek-R1-0528, OpenAI o3, Gemini 2.5 Pro等相当的表现。

昨天,深度求索刚刚开源 DeepSeek-V3.2-Exp。今天,另一国产大模型之光智谱 AI 也正式发布了旗下新一代旗舰模型 GLM-4.6,刚好撞车 Claude Sonnet 4.5。但有一点不同,智谱的 GLM-4.6 会继续开源,它即将上线 Hugging Face、ModelScope 等平台,遵循 MIT 协议。

凌晨1点,OpenAI突然扔出Sora 2核弹,AI视频迎来「GPT-3.5时刻」!一大批惊艳Demo放出,物理智能提升一大截,首次实现音画同步,人物一致性、可控性刷新SOTA。但最绝的还是Sora App,它的问世,或将彻底重塑短视频社交媒体的交互逻辑与社区互动方式。

由华中科技大学与小米汽车提出了业内首个无需 OCC 引导的多模态的图像 - 点云联合生成框架 Genesis。该算法只需基于场景描述和布局(包括车道线和 3D 框),就可以生成逼真的图像和点云视频。

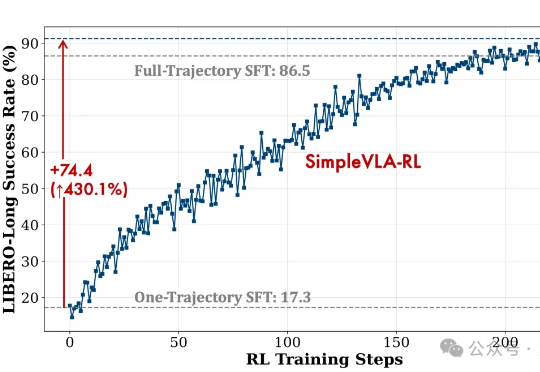

视觉-语言-动作模型是实现机器人在复杂环境中灵活操作的关键因素。然而,现有训练范式存在一些核心瓶颈,比如数据采集成本高、泛化能力不足等。

谷歌最新发布的Gemini Robotics 1.5系列模型,让机器人真正学会了「思考」,还能跨不同具身形态学习技能。这意味着,未来的机器人将成为和人类协作、主动完成复杂任务的智能伙伴。

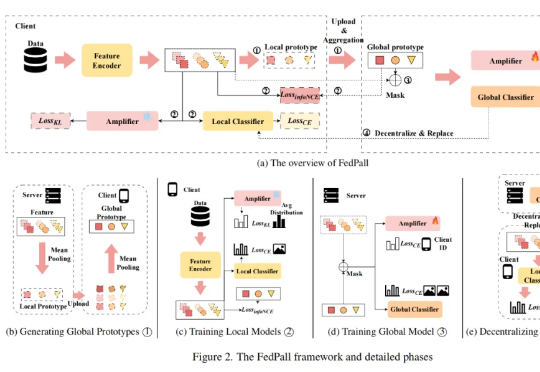

本论文第一作者张勇为北京理工大学医学技术学院计算机技术专业硕士生,主要研究方向为联邦学习,多专家大模型,多任务学习和并行代理。通讯作者是深圳北理莫斯科大学人工智能研究院梁锋博士和胡希平教授。梁锋博士毕

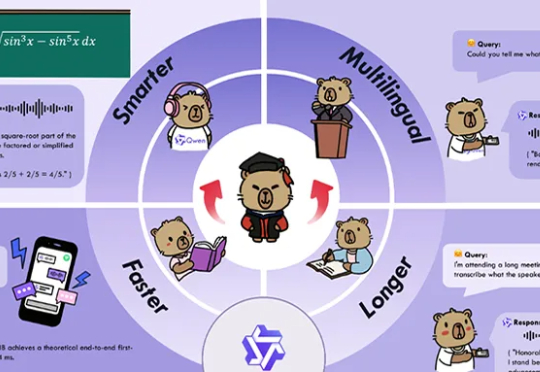

深夜,阿里通义大模型团队连放三个大招:开源原生全模态大模型Qwen3-Omni、语音生成模型Qwen3-TTS、图像编辑模型Qwen-Image-Edit-2509更新。Qwen3-Omni能无缝处理文本、图像、音频和视频等多种输入形式,并通过实时流式响应同时生成文本与自然语音输出。

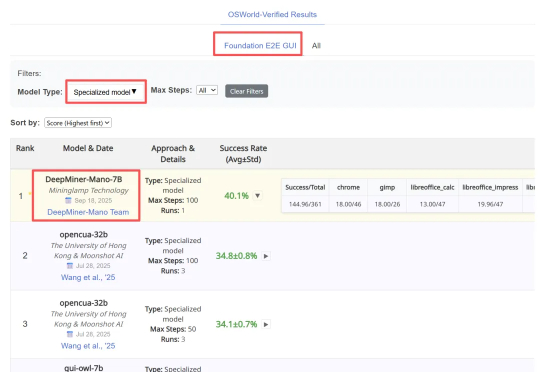

近日,明略科技推出的基于多模态基础模型的网页 GUI 智能体 Mano,凭借其强大的性能,在行业内公认的两大挑战基准 ——Mind2Web 和 OSWorld 上同时刷新纪录,取得当前最佳成绩(SOTA)。