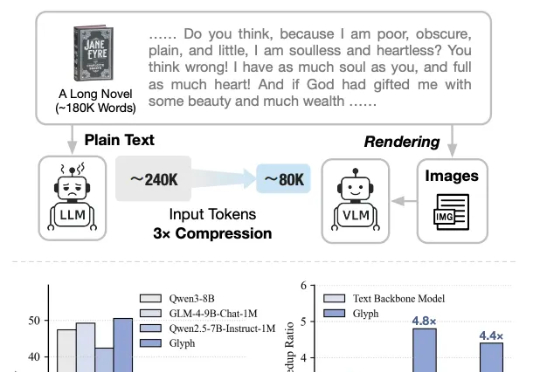

智谱运气是差一点点,视觉Token研究又和DeepSeek撞车了

智谱运气是差一点点,视觉Token研究又和DeepSeek撞车了太卷了,DeepSeek-OCR刚发布不到一天,智谱就开源了自家的视觉Token方案——Glyph。既然是同台对垒,那自然得请这两天疯狂点赞DeepSeek的卡帕西来鉴赏一下:

太卷了,DeepSeek-OCR刚发布不到一天,智谱就开源了自家的视觉Token方案——Glyph。既然是同台对垒,那自然得请这两天疯狂点赞DeepSeek的卡帕西来鉴赏一下:

魔幻啊魔幻。 全球顶级咨询公司麦肯锡,居然收到了OpenAI最近给Tokens消耗大客户颁发的奖牌。 麦肯锡自己还怪自豪的,第一时间就把奖牌po到了领英上。

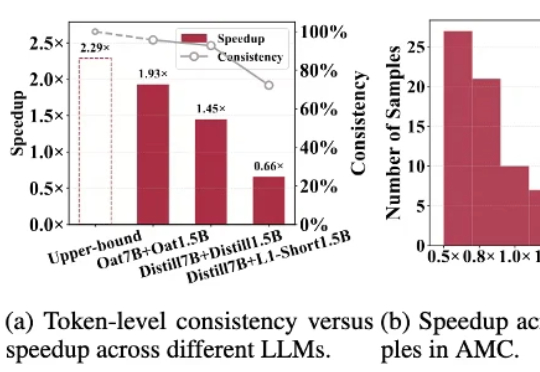

针对「大模型推理速度慢,生成token高延迟」的难题,莫纳什、北航、浙大等提出R-Stitch框架,通过大小模型动态协作,衡量任务风险后灵活选择:简单任务用小模型,关键部分用大模型。实验显示推理速度提升最高4倍,同时保证高准确率。

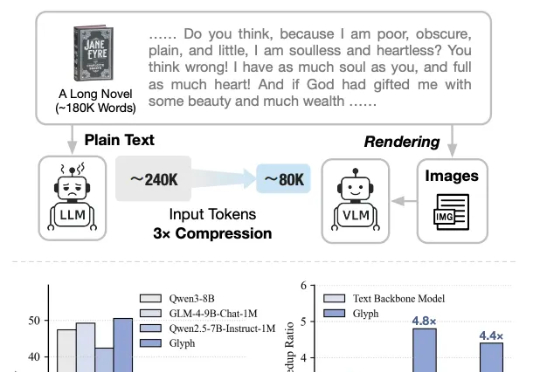

目前,所有主流 LLM 都有一个固定的上下文窗口(如 200k, 1M tokens)。一旦输入超过这个限制,模型就无法处理。 即使在窗口内,当上下文变得非常长时,模型的性能也会急剧下降,这种现象被称为「上下文腐烂」(Context Rot):模型会「忘记」开头的信息,或者整体推理能力下降。

在AI浪潮中,蚂蚁集团重磅推出万亿参数思考模型Ring-1T,不仅在数学竞赛上刷新开源SOTA,还在逻辑推理和医疗问答中脱颖而出。实测显示,其推理能力直逼闭源巨头,开源AI迈入万亿参数时代。

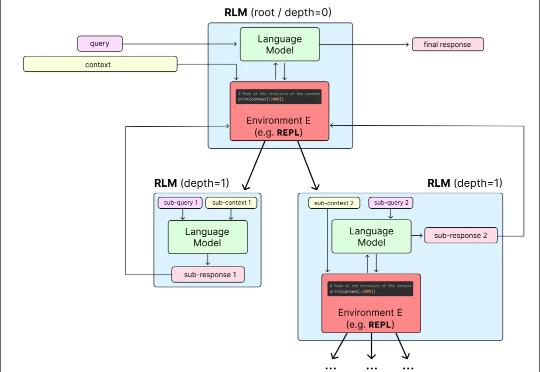

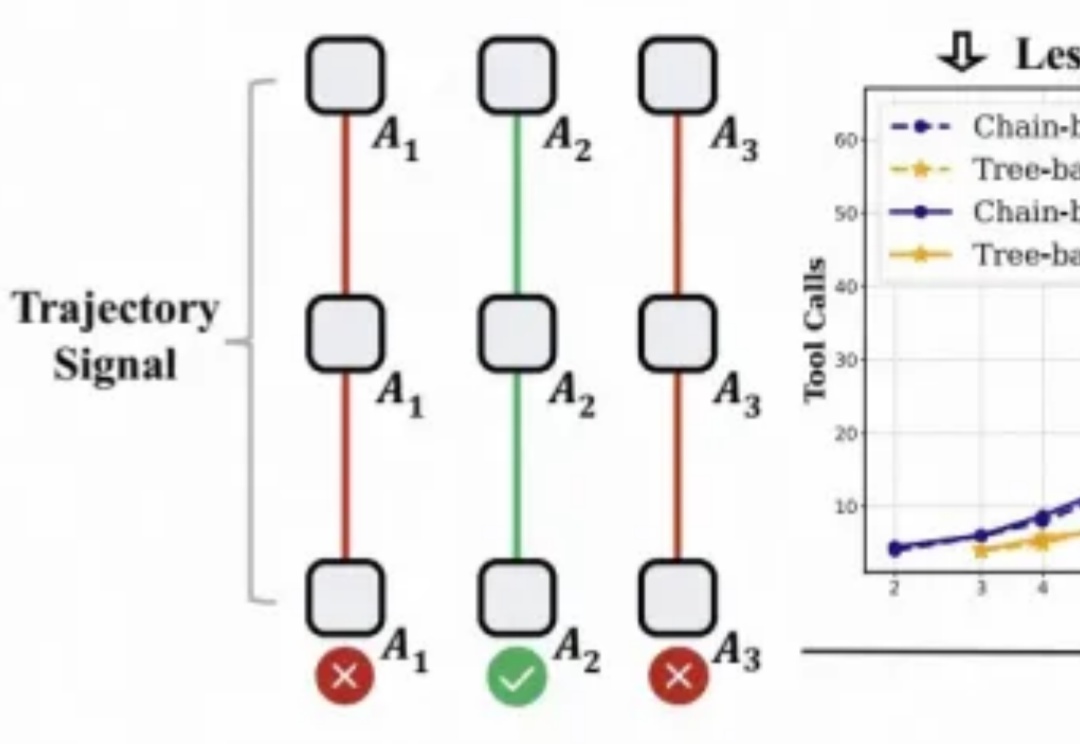

对于大模型的强化学习已在数学推理、代码生成等静态任务中展现出不俗实力,而在需要与开放世界交互的智能体任务中,仍面临「两朵乌云」:高昂的 Rollout 预算(成千上万的 Token 与高成本的工具调用)和极其稀疏的「只看结果」的奖励信号。

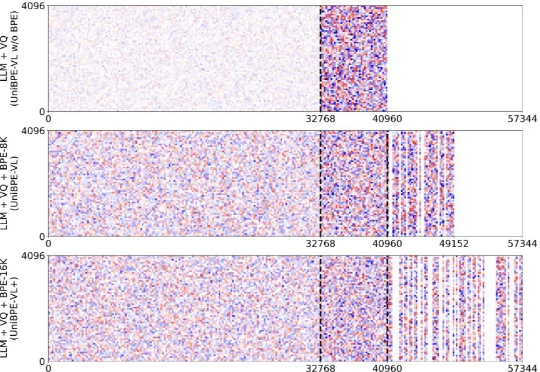

为此,北大、UC San Diego 和 BeingBeyond 联合提出一种新的方法——Being-VL 的视觉 BPE 路线。Being-VL 的出发点是把这一步后置:先在纯自监督、无 language condition 的设定下,把图像离散化并「分词」,再与文本在同一词表、同一序列中由同一 Transformer 统一建模,从源头缩短跨模态链路并保留视觉结构先验。

既然后训练这么重要,那么作为初学者,应该掌握哪些知识?大家不妨看看这篇博客《Post-training 101》,可以很好的入门 LLM 后训练相关知识。从对下一个 token 预测过渡到指令跟随; 监督微调(SFT) 基本原理,包括数据集构建与损失函数设计;

1.3千万亿,一个令人咂舌的数字。这就是谷歌每月处理的Tokens用量。据谷歌“宣传委员”Logan Kilpatrick透露,这一数据来自谷歌对旗下各平台的内部统计。那么在中文世界里,1.3千万亿Tokens约2.17千万亿汉字。换算成对话量,一本《红楼梦》的字数在70-80万左右,相当于一个月内所有人和谷歌AI聊了近30亿本《红楼梦》的内容。

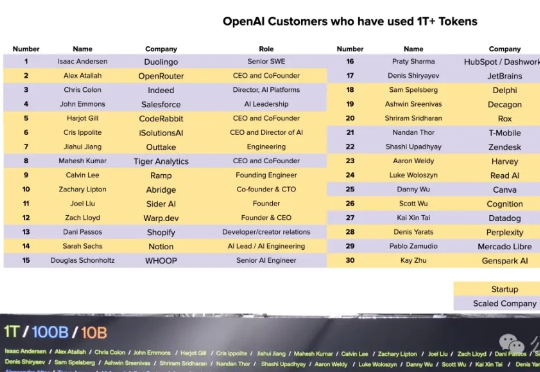

什么AI应用公司和方向是OpenAI看好的?这不,OpenAI公布了30家Tokens消耗破万亿的“大金主”。榜单按每家公司接入OpenAI API挂名人的姓氏排序,排名不分先后,初创公司多数由联合创始人亲自挂名,而大型企业则由专门的AI部门负责人负责对接。