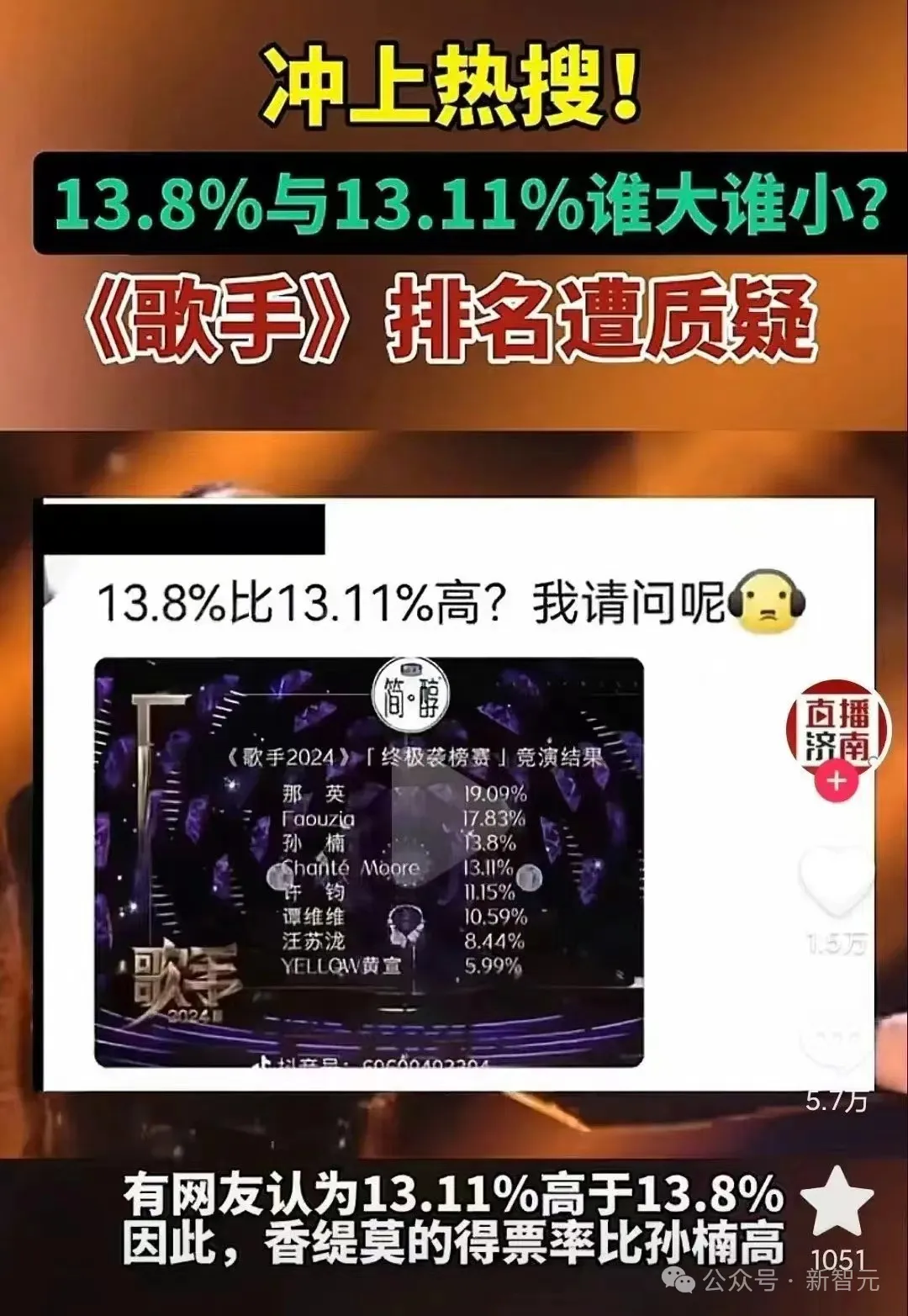

「13.11>13.8」冲上热搜,一道题让人类AI集体降智?所有LLM致命缺点曝光

「13.11>13.8」冲上热搜,一道题让人类AI集体降智?所有LLM致命缺点曝光13.8和13.11哪个大?这个问题不光难倒了部分人类,还让一票大模型折戟。AI如今都能做AI奥数题了,但简单的常识问题对它们依然难如登天。其实,无论是比大小,还是卷心菜难题,都揭示了LLM在token预测上的一个重大缺陷。

13.8和13.11哪个大?这个问题不光难倒了部分人类,还让一票大模型折戟。AI如今都能做AI奥数题了,但简单的常识问题对它们依然难如登天。其实,无论是比大小,还是卷心菜难题,都揭示了LLM在token预测上的一个重大缺陷。

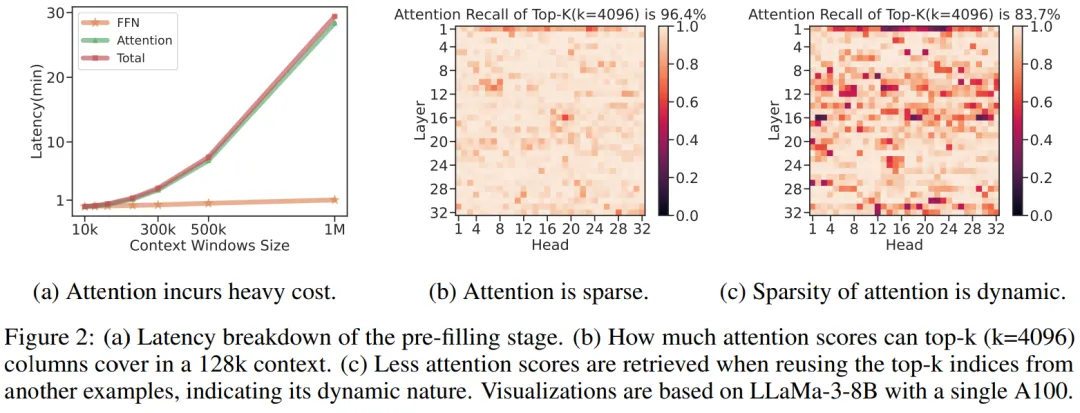

为什么说理解长视频难如 “大海捞针”?

微软的这项研究让开发者可以在单卡机器上以 10 倍的速度处理超过 1M 的输入文本。

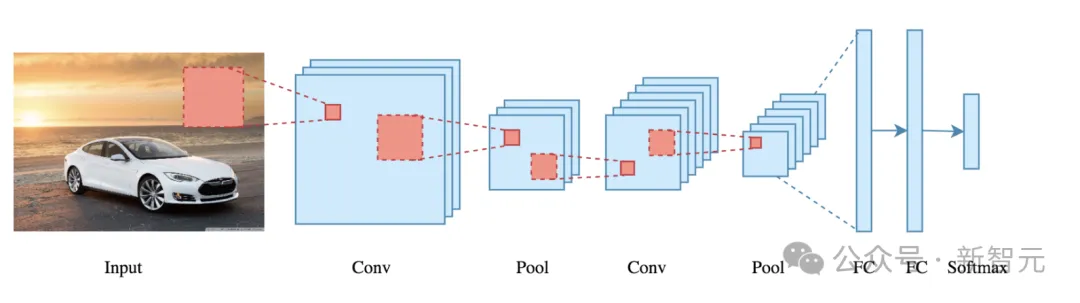

下一代视觉模型会摒弃patch吗?Meta AI最近发表的一篇论文就质疑了视觉模型中局部关系的必要性。他们提出了PiT架构,让Transformer直接学习单个像素而不是16×16的patch,结果在多个下游任务中取得了全面超越ViT模型的性能。

大模型之争,到了不只是拼技术的时刻。

只需Image Tokenizer,Llama也能做图像生成了,而且效果超过了扩散模型。

该来的还是来了。

今天凌晨,OpenAI 突然宣布终止对中国提供 API 服务,进一步收紧国内开发者访问 GPT 等高水平大模型。国内开发者真是太难了。

在人工智能领域的发展过程中,对大语言模型(LLM)的控制与指导始终是核心挑战之一,旨在确保这些模型既强大又安全地服务于人类社会。早期的努力集中于通过人类反馈的强化学习方法(RLHF)来管理这些模型,成效显著,标志着向更加人性化 AI 迈出的关键一步。

在生成式模型的迅速发展中,Image Tokenization 扮演着一个很重要的角色,例如Diffusion依赖的VAE或者是Transformer依赖的VQGAN。这些Tokenizers会将图像编码至一个更为紧凑的隐空间(latent space),使得生成高分辨率图像更有效率。