机器人不只会抓和放!北京大学X银河通用「世界-动作模型」赋能全面泛化的非抓握技能

机器人不只会抓和放!北京大学X银河通用「世界-动作模型」赋能全面泛化的非抓握技能尽管当前的机器人视觉语言操作模型(VLA)展现出一定的泛化能力,但其操作模式仍以准静态的抓取与放置(pick-and-place)为主。相比之下,人类在操作物体时常常采用推动、翻转等更加灵活的方式。若机器人仅掌握抓取,将难以应对现实环境中的复杂任务。

尽管当前的机器人视觉语言操作模型(VLA)展现出一定的泛化能力,但其操作模式仍以准静态的抓取与放置(pick-and-place)为主。相比之下,人类在操作物体时常常采用推动、翻转等更加灵活的方式。若机器人仅掌握抓取,将难以应对现实环境中的复杂任务。

还有人没被《大展鸿图》洗脑吗? 反正今天一睁眼,朋友圈里就有人形机器人“别墅里面唱K”开始刷屏,给我看得一愣一愣的——

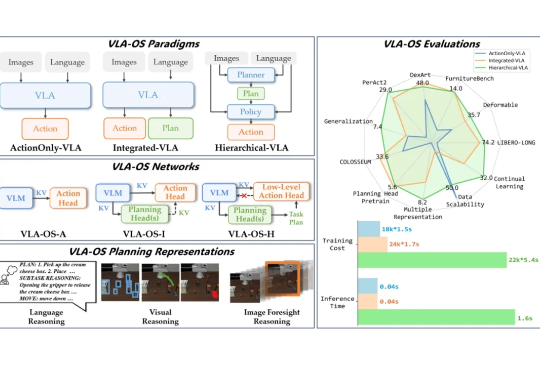

为什么机器人能听懂指令却做不对动作?语言大模型指挥机器人,真的是最优解吗?端到端的范式到底是不是通向 AGI 的唯一道路?这些问题背后,藏着机器智能的未来密码。

打通机器人智能化的关键:眼+脑+手。

如今的具身智能,早已爆红AI圈。数据瓶颈、难以多场景泛化等难题,一直困扰着业界的玩家们。就在WAIC上,全新具身智能平台「悟能」登场了。它以世界模型为引擎,能为机器人提供强大感知、导航、多模态交互能力。

在 7 月 26 日召开的 WAIC 世界人工智能大会上,AI Agent、具身智能被推上了 C 位:从行业论坛到展台

WAIC大会上,这个机器人凭惊艳实力引起了层层围观!叠衣服、分拣物品、听指令取货,他们研发的Mech-GPT多模态大模型和「眼脑手」系统,让机器人的高难度操作性能暴增。现在,这家公司已经成为市占率连续五年的行业冠军了。

腾讯一口气发布3个具身模型,包括动态感知、规划、感知行动联合模型,分别对应人类的左脑、右脑和小脑。

陈建宇(星动纪元创始人)、高阳(千寻智能联合创始人)、吴翼(蚂蚁集团强化学习实验室首席科学家)、许华哲(星海图联合创始人)的分享(题图从左至右),基本代表了国内具身智能领域最先进的成果展示。

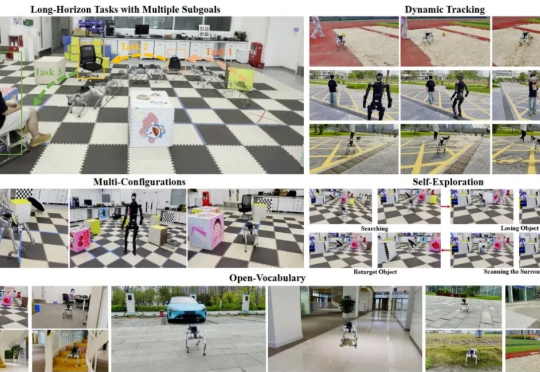

在复杂的开放环境中,让足式机器人像人类一样自主完成「先跑到椅子旁,再快速接近行人」这类长程多目标任务,一直是 robotics 领域的棘手难题。传统方法要么局限于固定目标类别,要么难以应对运动中的视觉抖动、目标丢失等实时挑战,导致机器人在真实场景中常常「迷路」或「认错对象」。