大模型竞赛转向:决胜关键为何是“后训练”?

大模型竞赛转向:决胜关键为何是“后训练”?随着基础大模型在通用能力上的边际效益逐渐递减、大模型技术红利向产业端渗透,AI的技术范式也开始从原来的注重“预训练”向注重“后训练”转移。后训练(Post-training),正从过去锦上添花的“调优”环节,演变为决定模型最终价值的“主战场”。

随着基础大模型在通用能力上的边际效益逐渐递减、大模型技术红利向产业端渗透,AI的技术范式也开始从原来的注重“预训练”向注重“后训练”转移。后训练(Post-training),正从过去锦上添花的“调优”环节,演变为决定模型最终价值的“主战场”。

美国AI初创公司 Perplexity 的联合创始人兼首席执行官Aravind Srinivas今日在社交平台发文,首次公开评价中国大模型“月之暗面”Kimi K2。他表示,Kimi K2 在内部测试中表现良好,Perplexity 正在考虑在其基础上进行后训练。

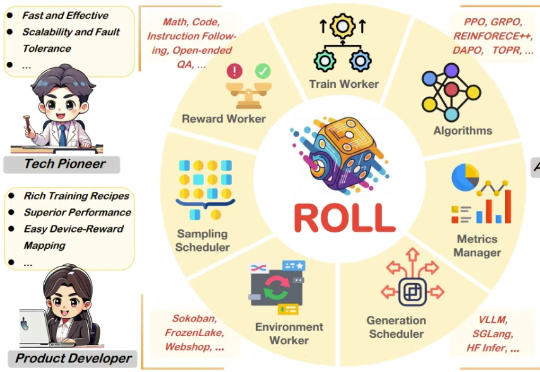

强化学习改变了大语言模型的后训练范式,可以说,已成为AI迈向AGI进程中的关键技术节点。然而,其中奖励模型的设计与训练,始终是制约后训练效果、模型能力进一步提升的瓶颈所在。

扎克伯格又从奥特曼手里挖走4名顶尖AI人才,这次四位都是华人研究员。

过去几年,随着基于人类偏好的强化学习(Reinforcement Learning from Human Feedback,RLHF)的兴起,强化学习(Reinforcement Learning,RL)已成为大语言模型(Large Language Model,LLM)后训练阶段的关键技术。

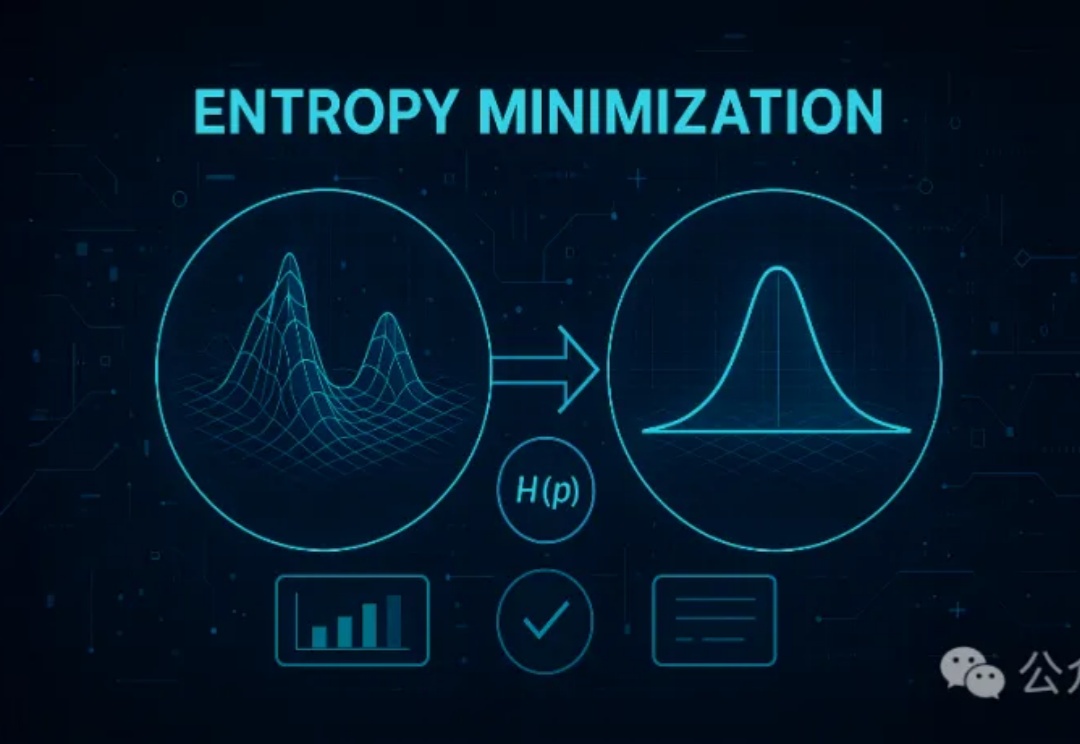

无监督的熵最小化(EM)方法仅需一条未标注数据和约10步优化,就能显著提升大模型在推理任务上的表现,甚至超越依赖大量数据和复杂奖励机制的强化学习(RL)。EM通过优化模型的预测分布,增强其对正确答案的置信度,为大模型后训练提供了一种更高效简洁的新思路。

第一财经「新皮层」独家获得消息称,小红书已将内部大模型技术与应用产品团队升级为「hi lab」(人文智能实验室,Humane Intelligence Lab)。同时,小红书今年年初开始组建「AI人文训练师」团队,邀请有深厚人文背景的研究者与AI领域的算法工程师、科学家共同完成对AI的后训练,以训练AI具有更好的人文素养以及表现上的一致性。而这个「AI人文训练师」团队也隶属于「hi lab」。

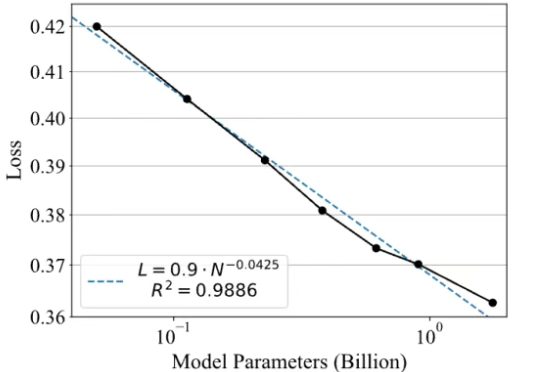

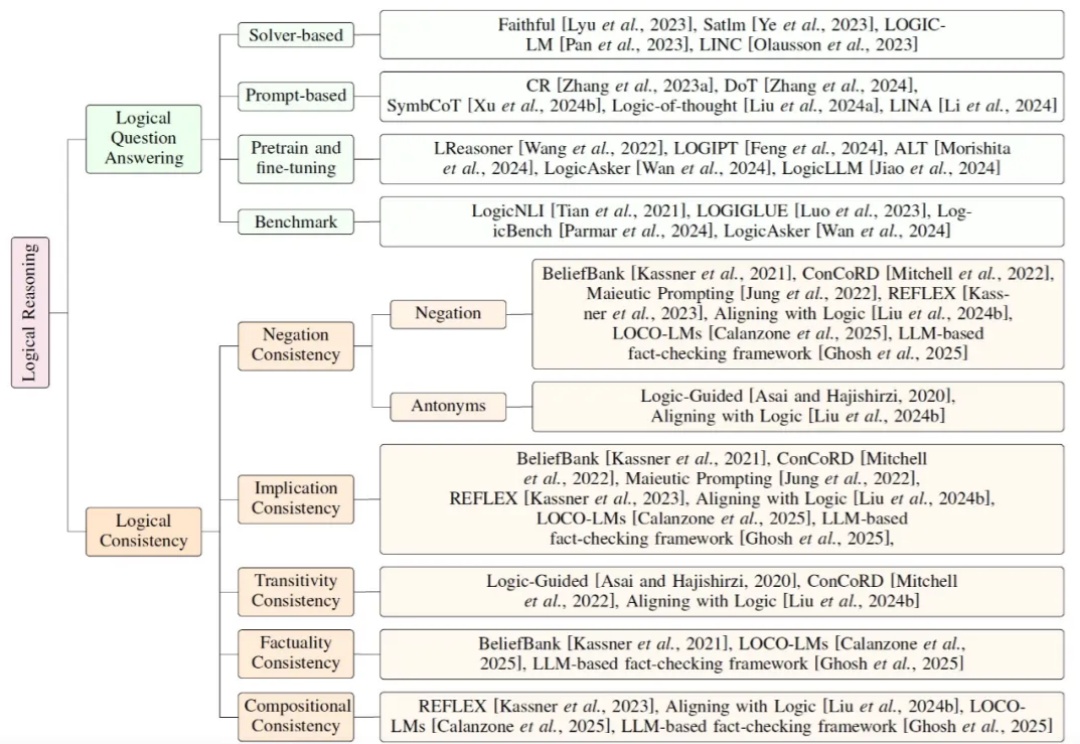

当前大模型研究正逐步从依赖扩展定律(Scaling Law)的预训练,转向聚焦推理能力的后训练。鉴于符号逻辑推理的有效性与普遍性,提升大模型的逻辑推理能力成为解决幻觉问题的关键途径。

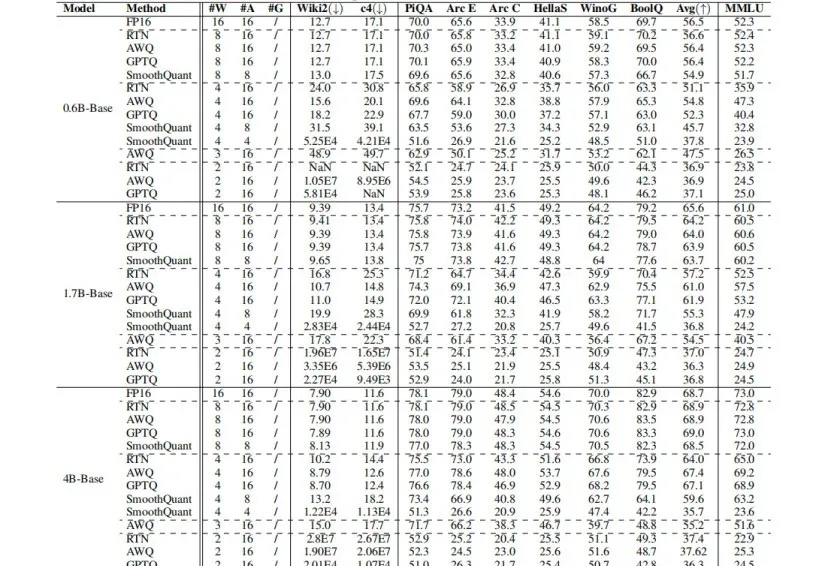

Qwen3强势刷新开源模型SOTA,但如何让其在资源受限场景中,既能实现低比特量化,又能保证模型“智商”不掉线?

南加州大学团队只用9美元,就能在数学基准测试AIME 24上实现超过20%的推理性能提升,效果好得离谱!而其核心技术只需LoRA+强化学习,用极简路径实现超高性价比后训练。