开源免费!推荐一款基于DeepSeek大模型RAG知识库与知识图谱平台,打通飞书、企业微信、钉钉

开源免费!推荐一款基于DeepSeek大模型RAG知识库与知识图谱平台,打通飞书、企业微信、钉钉语析Yuxi-Know 是基于大模型RAG知识库与知识图谱技术构建的智能问答平台,支持多种知识库文件格式,如PDF、TXT、MD、Docx,支持将文件内容转换为向量存储,便于快速检索。

语析Yuxi-Know 是基于大模型RAG知识库与知识图谱技术构建的智能问答平台,支持多种知识库文件格式,如PDF、TXT、MD、Docx,支持将文件内容转换为向量存储,便于快速检索。

怎样做一个爆款大模型应用?这恐怕是2026年AI开发者们都在关注的问题。当算力和性能不再是唯一的护城河,“爆款”意味着大模型要能精准地“抓住”每一名具体的用户,而个性化正是其中的关键技术之一。

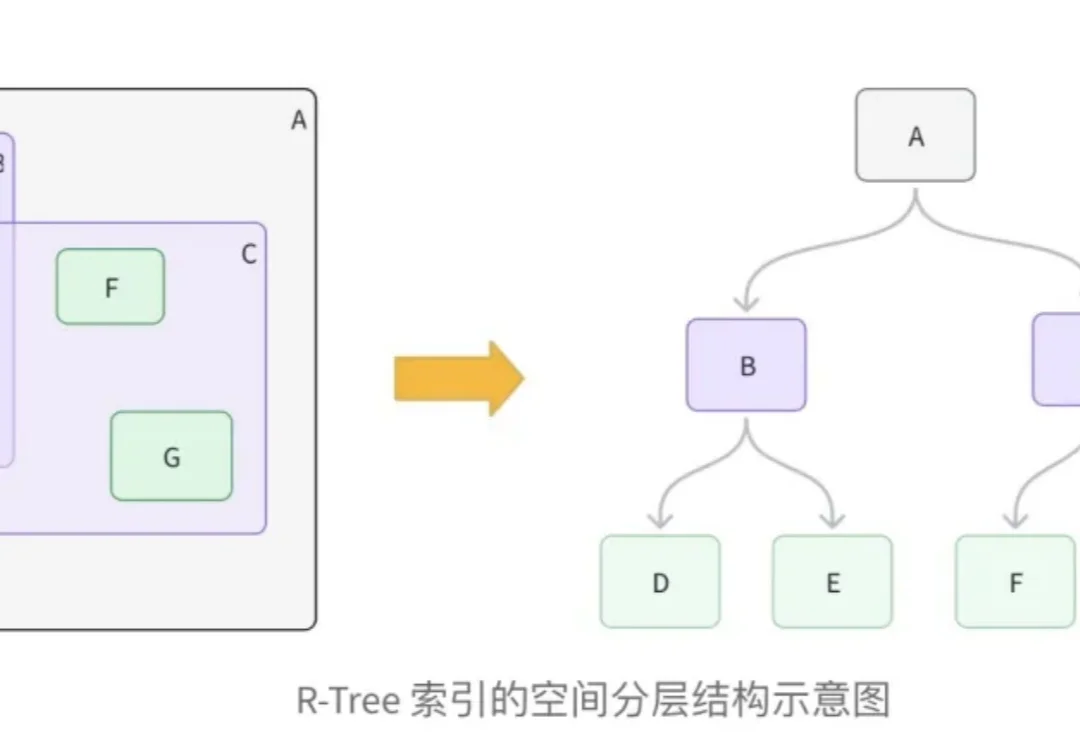

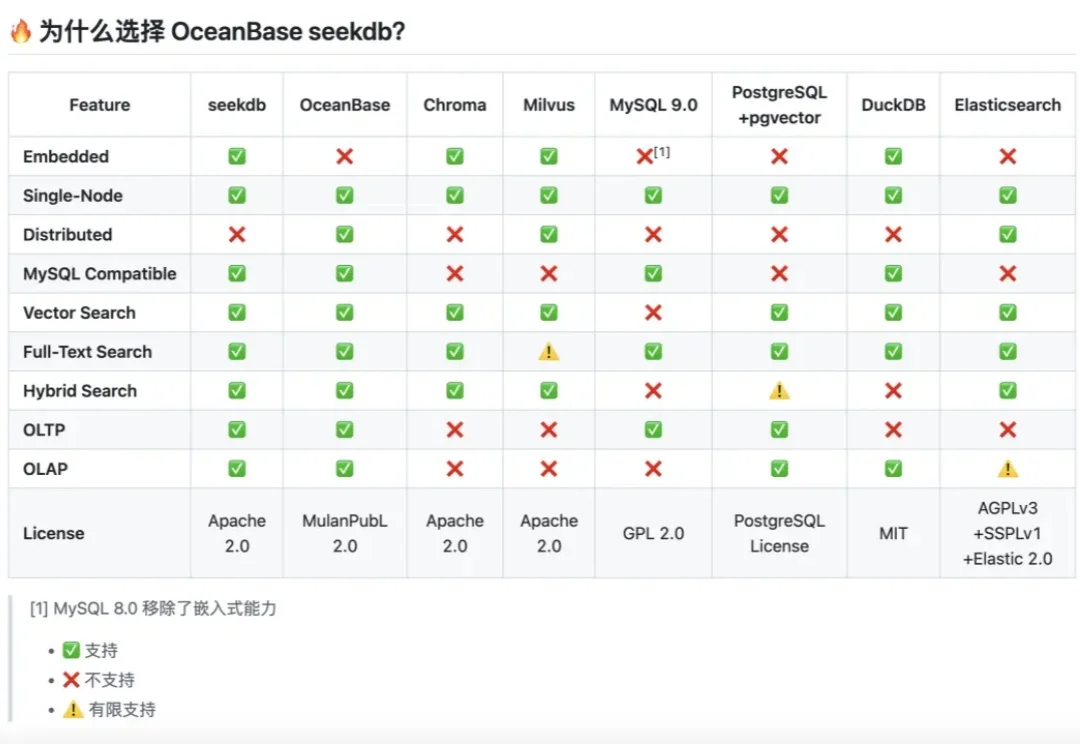

在向量数据库的工程实践中,处理多模态数据,特别是结合地理位置(LBS)与非结构化语义数据,一直是一个复杂的架构挑战。

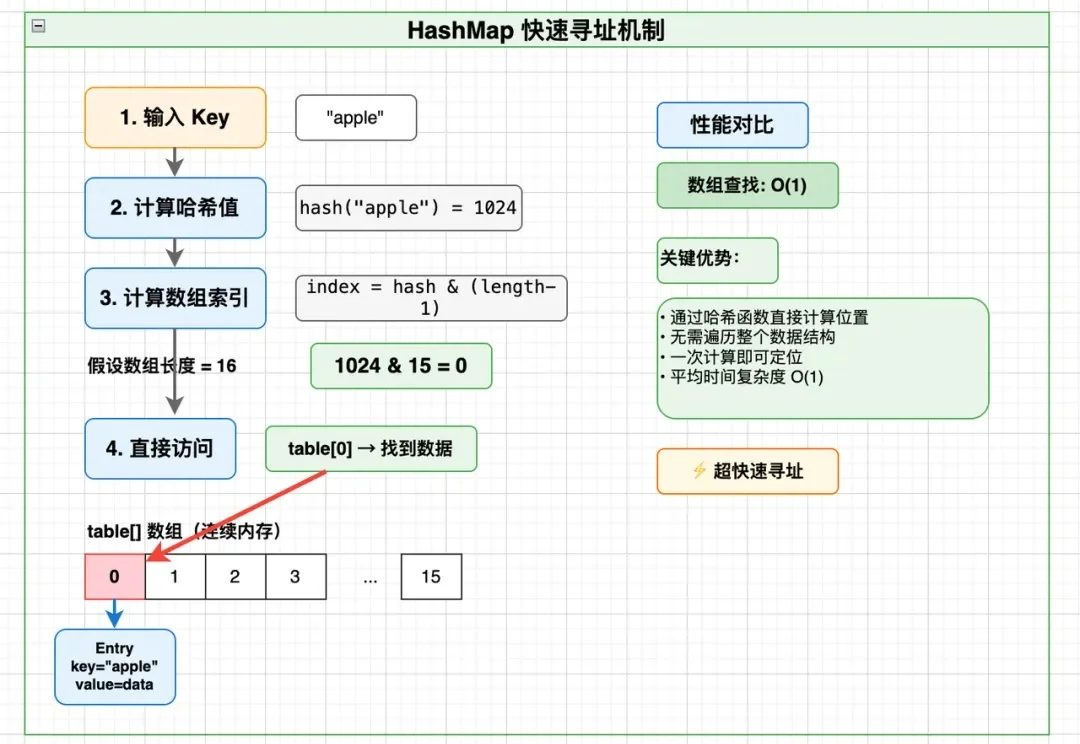

做后端、大数据、分布式存储的同学,大概率都遇到过这样的问题:

故事得从我们那个行业交流群说起。

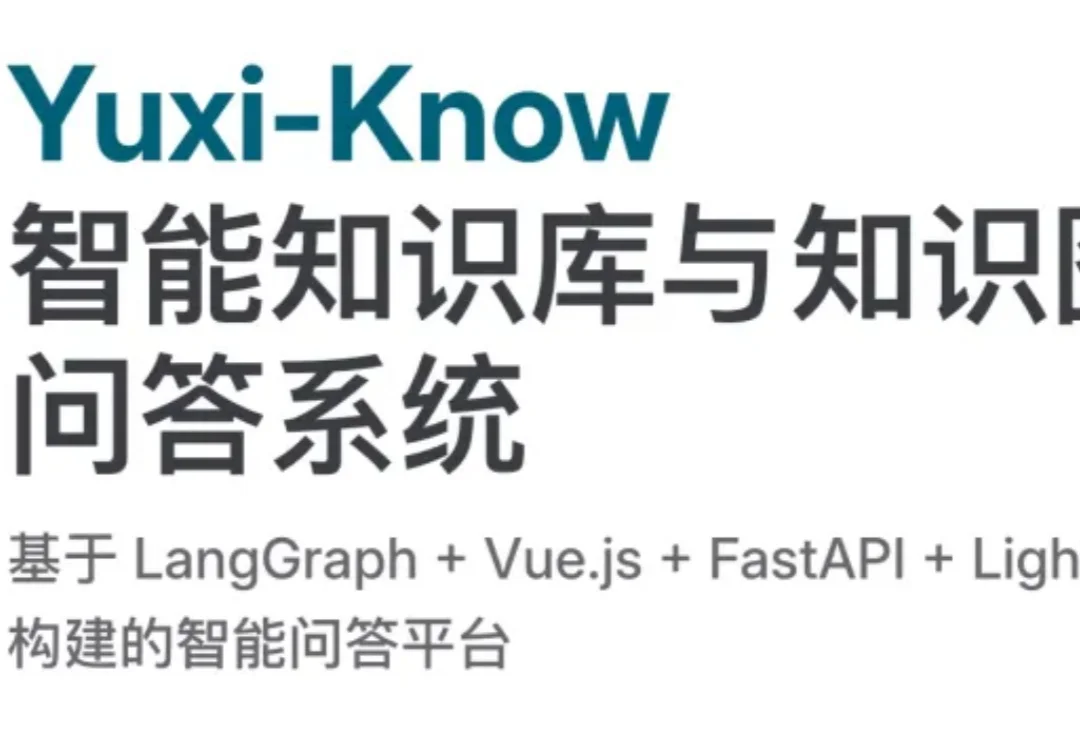

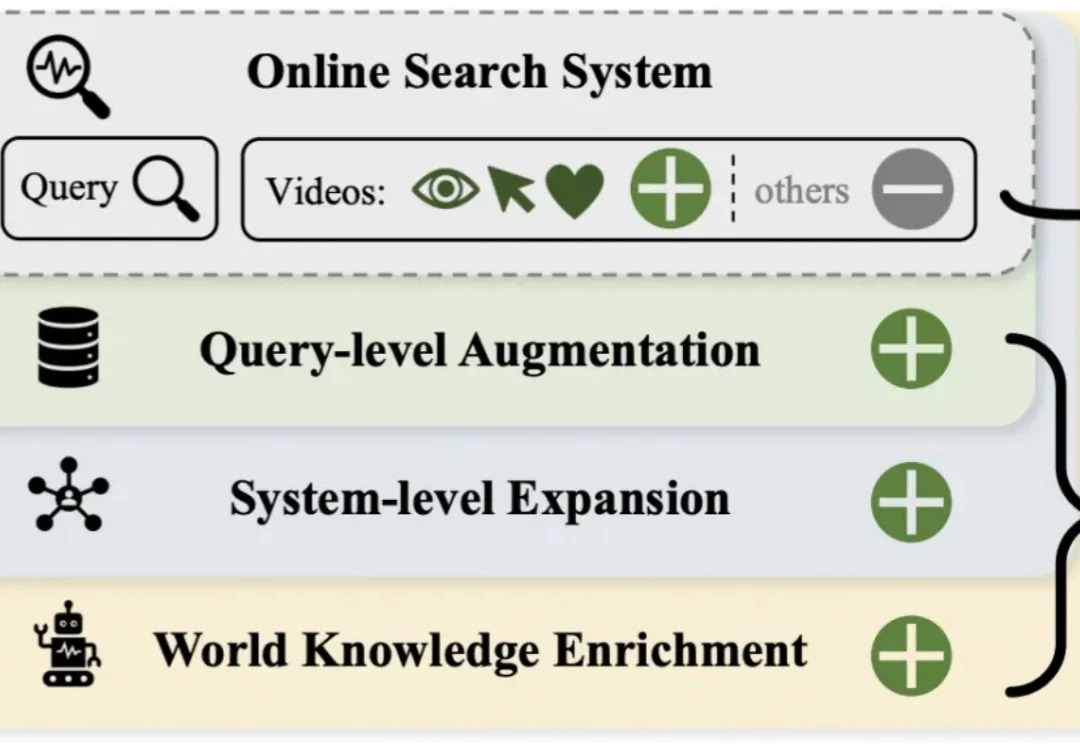

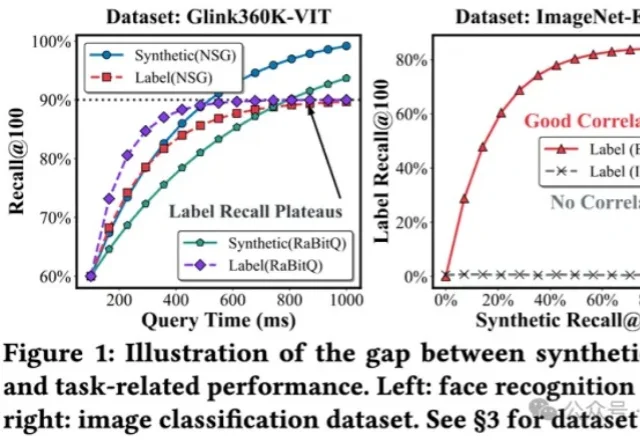

短视频搜索业务是向量检索在工业界最核心的应用场景之一。然而,当前业界普遍采用的「自强化」训练范式过度依赖历史点击数据,导致系统陷入信息茧房,难以召回潜在相关的新鲜内容。

今天,Qwen 家族新成员+2,我们正式发布 Qwen3-VL-Embedding 和 Qwen3-VL-Reranker 模型系列,这两个模型基于 Qwen3-VL 构建,专为多模态信息检索与跨模态理解设计,为图文、视频等混合内容的理解与检索提供统一、高效的解决方案。

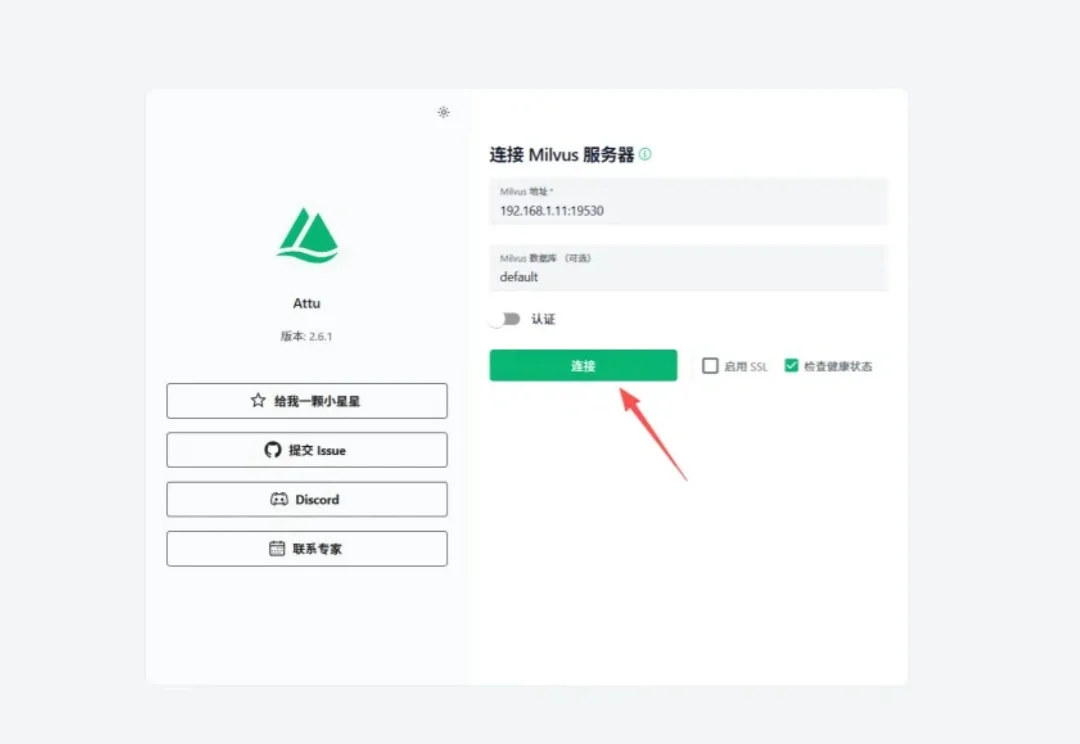

今天在讲Milvus的Attu之前,我们先来唠一段计算机行业的八卦。

不久前,Zilliz 研发VP栾小凡受邀做客英文播客节目Innovator Coffee,深度分享了 Zilliz 的创业历程、Milvus 产品的构建逻辑与核心设计思路,以下为本次分享的重点内容摘编。

将多模态数据纳入到RAG,甚至Agent框架,是目前LLM应用领域最火热的主题之一,针对多模态数据最自然的召回方式,便是向量检索。