Llama也能做图像生成!港大字节推出开源自回归文生图模型,在线体验已开放

Llama也能做图像生成!港大字节推出开源自回归文生图模型,在线体验已开放只需Image Tokenizer,Llama也能做图像生成了,而且效果超过了扩散模型。

只需Image Tokenizer,Llama也能做图像生成了,而且效果超过了扩散模型。

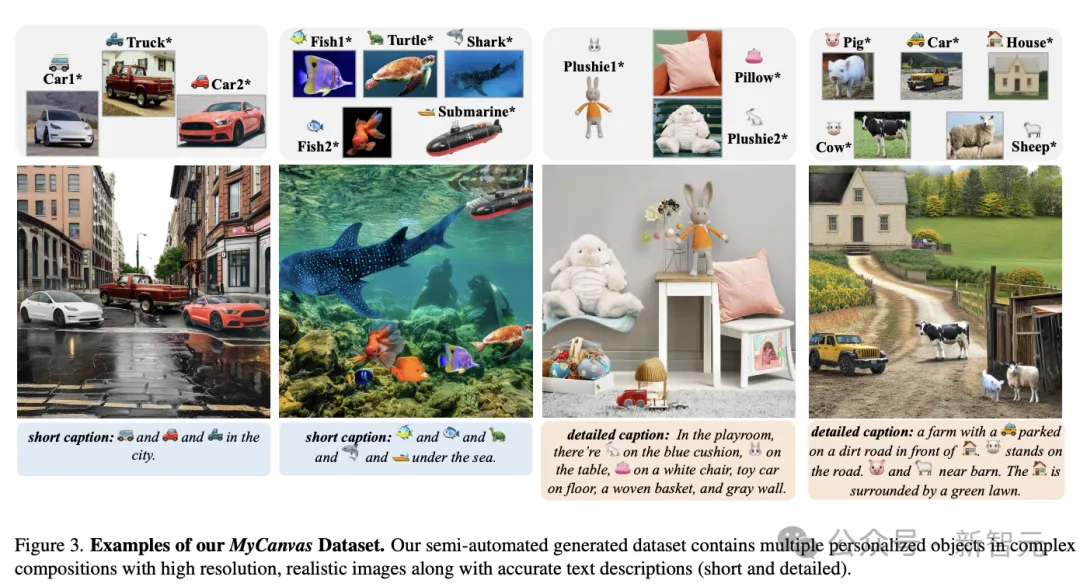

面对层出不穷的个性化图像生成技术,一个新问题摆在眼前:缺乏统一标准来衡量这些生成的图片是否符合人们的喜好。对此,来自清华、西交大、伊利诺伊厄巴纳-香槟分校、中科院、旷视的研究人员共同推出了一项新基准DreamBench++。

超越扩散模型!自回归范式在图像生成领域再次被验证——

北航的研究团队,用扩散模型“复刻”了一个地球? 在全球的任意位置,模型都能生成多种分辨率的遥感图像,创造出丰富多样的“平行场景”。 而且地形、气候、植被等复杂的地理特征,也全都考虑到了。

基于人工智能的数字内容生成,即 AIGC 在二维图像生成领域取得了很大的成功,但在三维生成方面仍存在挑战。智能化生成三维模型在 AR/VR、工业设计、建筑设计和游戏影视等方面都有应用价值,现有的智能化三维生成方法已经可以生成高质量的三维模型,但如何对生成结果进行精确控制,并对真实模型或生成的模型进行细节的修改,从而让用户自由定制高质量的三维模型仍然是一个待解决的问题。

在图像生成领域占据主导地位的扩散模型,开始挑战强化学习智能体。

首届ICLR时间检验奖,颁向变分自编码器VAE

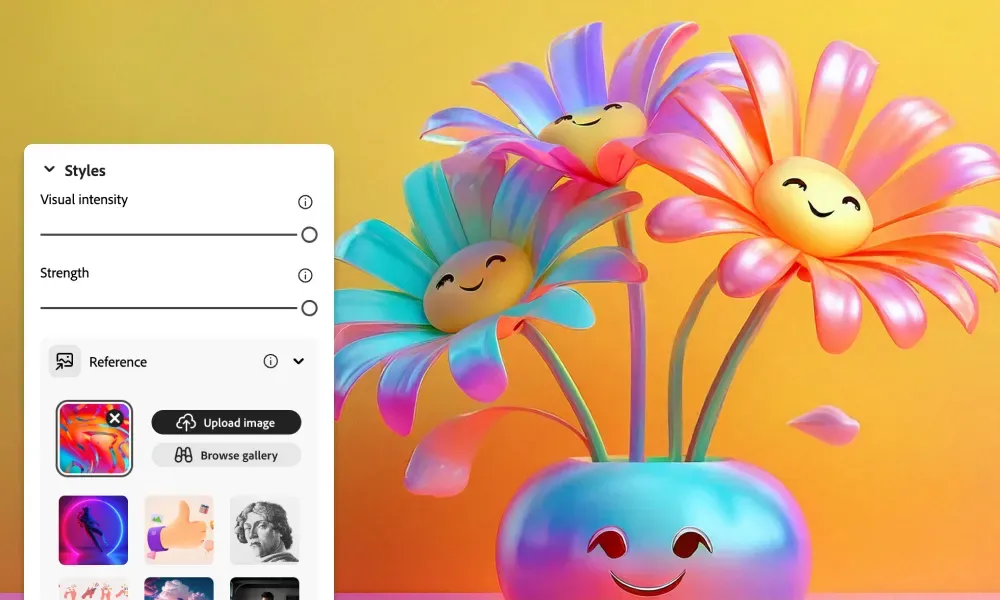

刚刚,Adobe 正式宣布推出新的图像生成模型 Firefly Image 3,即日起在 Firefly Web 应用程序、Adobe Photoshop 和 Adobe InDesign 中提供测试版,并在「今年晚些时候」全面上市,旨在让创作者能够提高工作效率,生成更高质量、更详细的图像。

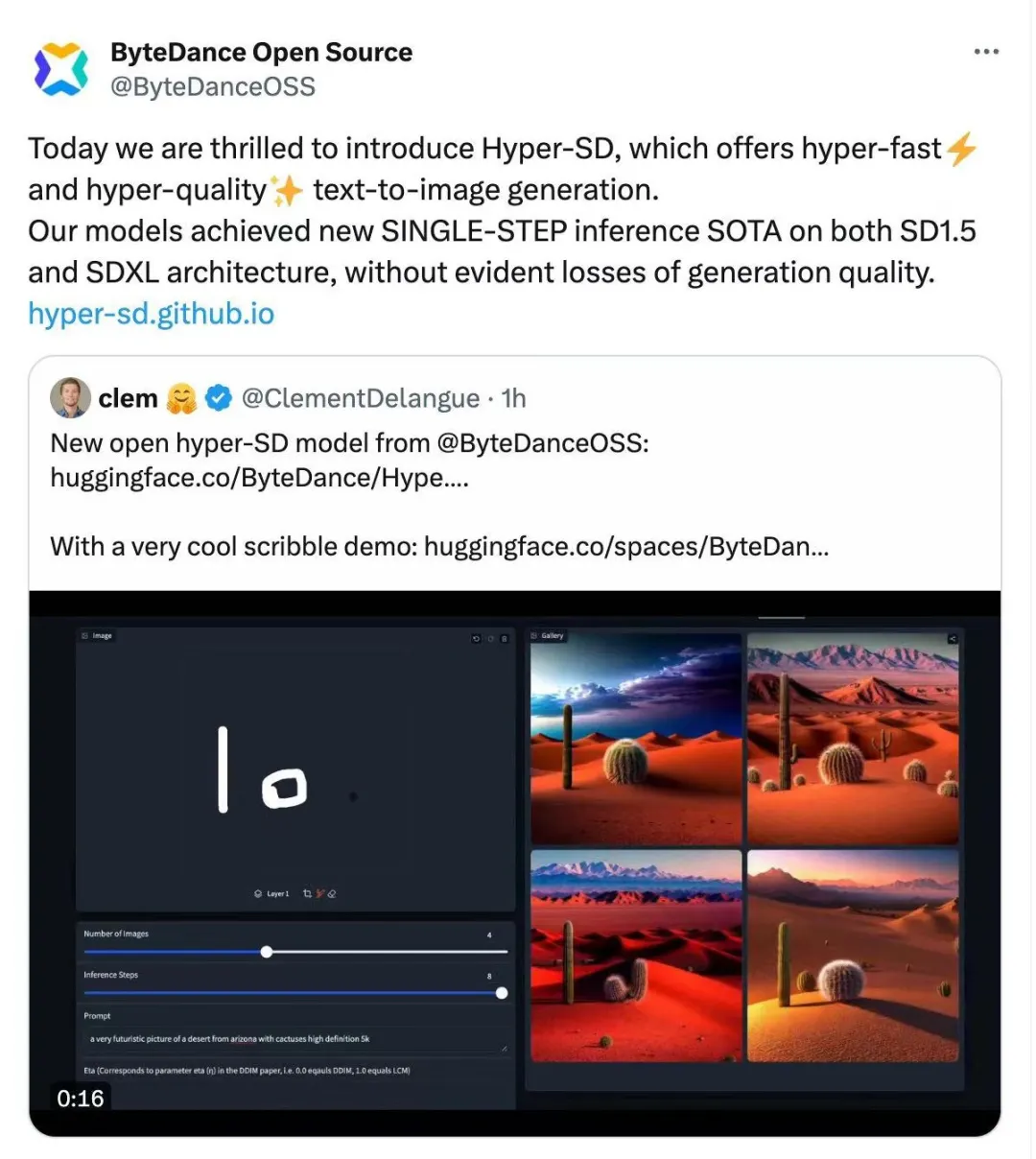

最近,扩散模型(Diffusion Model)在图像生成领域取得了显著的进展,为图像生成和视频生成任务带来了前所未有的发展机遇。尽管取得了令人印象深刻的结果,扩散模型在推理过程中天然存在的多步数迭代去噪特性导致了较高的计算成本。

过去几年里,基于文本来生成图像的扩散模型得到了飞速发展,生成能力有了显著的提升,可以很容易地生成逼真的肖像画,以及各种天马行空的奇幻画作。