揭秘Sora:用大语言模型的方法理解视频,实现了对物理世界的“涌现”

揭秘Sora:用大语言模型的方法理解视频,实现了对物理世界的“涌现”简单粗暴的理解,就是语言能力足够强大之后,它带来的泛化能力直接可以学习图像视频数据和它体现出的模式,然后还可以直接用学习来的图像生成模型最能理解的方式,给这些利用了引擎等已有的强大而成熟的视频生成技术的视觉模型模块下指令,最终生成我们看到的逼真而强大的对物理世界体现出“理解”的视频。

简单粗暴的理解,就是语言能力足够强大之后,它带来的泛化能力直接可以学习图像视频数据和它体现出的模式,然后还可以直接用学习来的图像生成模型最能理解的方式,给这些利用了引擎等已有的强大而成熟的视频生成技术的视觉模型模块下指令,最终生成我们看到的逼真而强大的对物理世界体现出“理解”的视频。

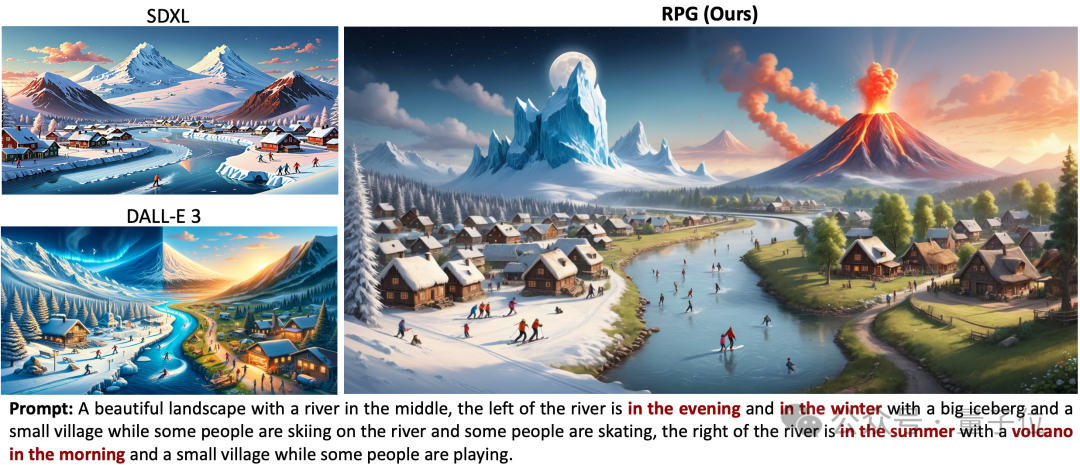

Pika北大斯坦福联手,开源最新文本-图像生成/编辑框架!

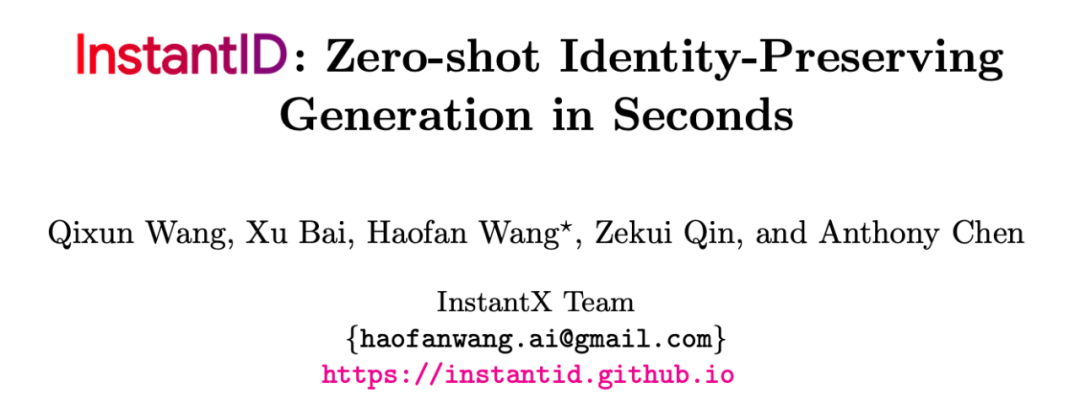

主题驱动的文本到图像生成,通常需要在多张包含该主题(如人物、风格)的数据集上进行训练,这类方法中的代表工作包括 DreamBooth、Textual Inversion、LoRAs 等,但这类方案因为需要更新整个网络或较长时间的定制化训练,往往无法很有效地兼容社区已有的模型,并无法在真实场景中快速且低成本应用。

将2D扩散模型的强大图像生成能力与再绘策略的纹理对齐能力结合起来,Repaint123能够在2分钟内从零开始生成具有多视角一致性和精细纹理的高质量3D内容。

谷歌新设计的一种图像生成模型已经能做到这一点了!通过引入指令微调技术,多模态大模型可以根据文本指令描述的目标和多张参考图像准确生成新图像,效果堪比 PS 大神抓着你的手助你 P 图。

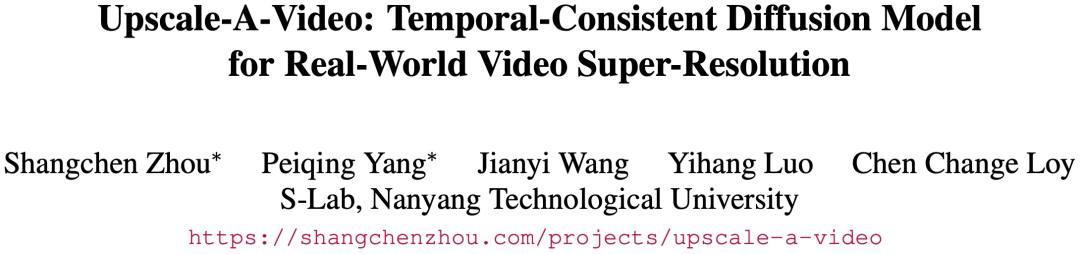

扩散模型在图像生成方面取得了显著的成功,但由于对输出保真度和时间一致性的高要求,将这些模型应用于视频超分辨率仍然具有挑战性,特别是其固有的随机性使这变得复杂。

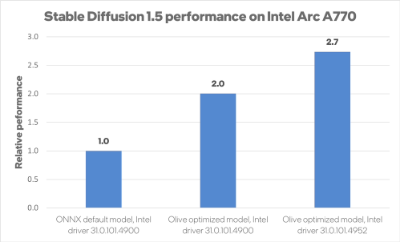

在 Microsoft Ignite 开发者大会上,英特尔和微软宣布将合作对英特尔 Arc 图形解决方案的 DirectML 进行优化。结果表明,英特尔更新 Arc Alchemist 驱动程序后,在 AI 图像生成器 Stable Diffusion 中实现了 2.7 倍的性能提升。

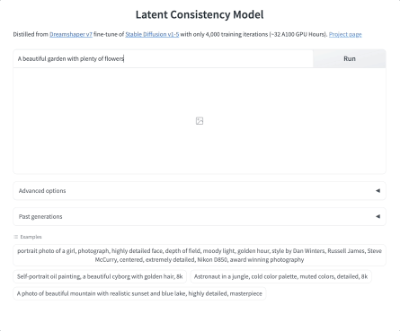

AI图像生成,已经进入了秒速级别,只要4步推理就能完成绘制,最快更是能在1秒之内完成。现在,清华大学联合HuggingFace的研究人员,推出了全新的绘图模型加速模块。

Stability AI是一家人工智能 (AI) 初创公司,因其 Stable Diffusion 图像生成软件而闻名,据报道已筹集约 5000 万美元融资。

开源图像生成大模型 Stable Diffusion(SD) 的开发商 Stability AI 今天宣布了其 Stable Diffusion 平台的多项新增强功能。 这些更新不仅提供了令人兴奋的文本转图像新功能,而且还涉足 3D 内容创建领域。