35天,版本之子变路人甲:AI榜单太残酷!

35天,版本之子变路人甲:AI榜单太残酷!o1从榜首暴跌至#56,Claude 3 Opus坠入#139。LMSYS榜单揭示残酷真相:大模型的「霸主保质期」只有35天!这不是技术迭代,这是对所有应用层开发者的降维屠杀。

o1从榜首暴跌至#56,Claude 3 Opus坠入#139。LMSYS榜单揭示残酷真相:大模型的「霸主保质期」只有35天!这不是技术迭代,这是对所有应用层开发者的降维屠杀。

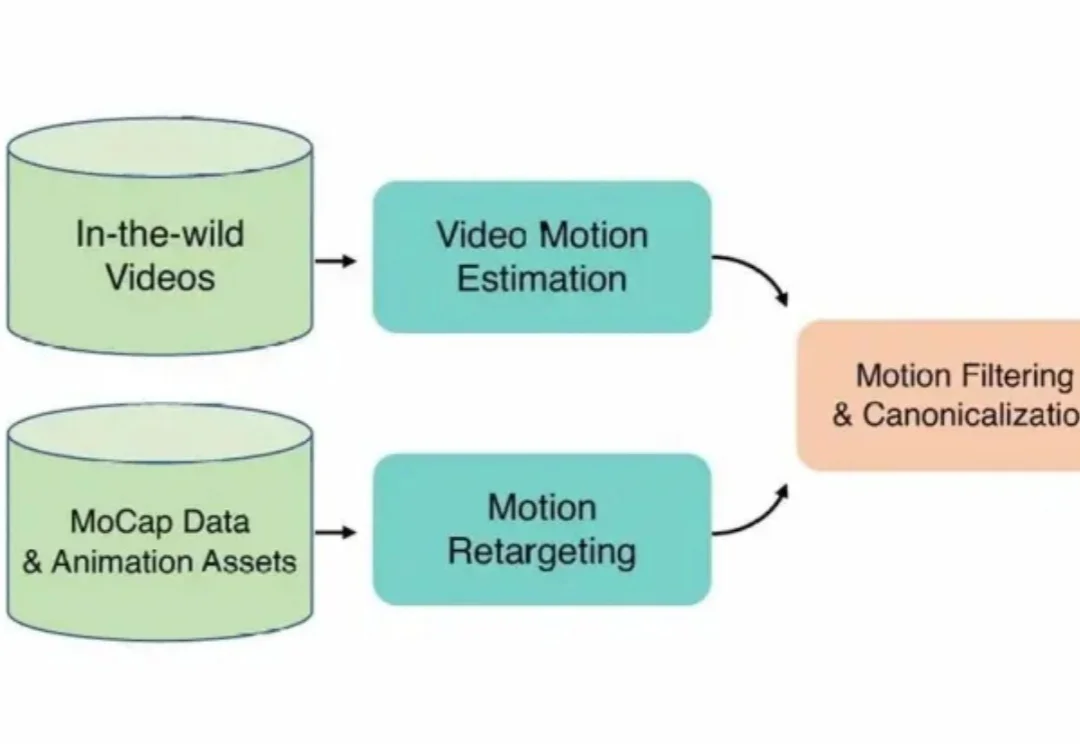

在3D角色动画创作领域,高质量动作资产的匮乏长期制约着产出的上限。

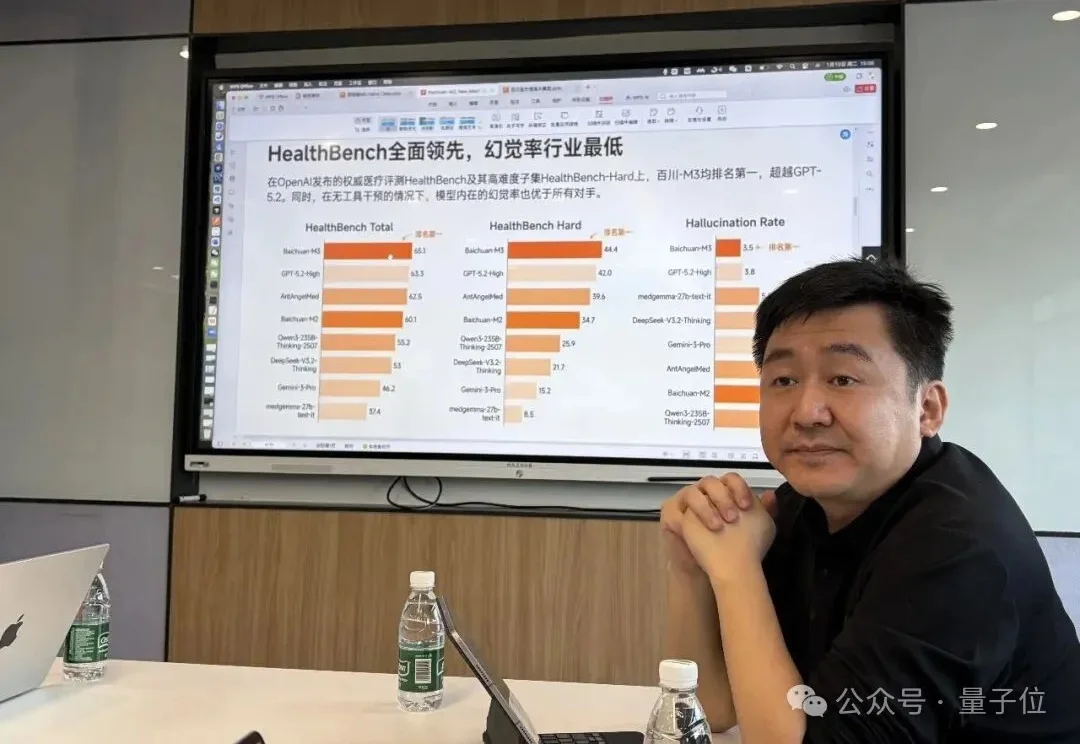

“我们没有能力一会儿金融、一会儿娱乐、一会儿医疗,只能深耕一条主线。”

提高大模型记忆这块儿,美国大模型开源王者——英伟达也出招了。

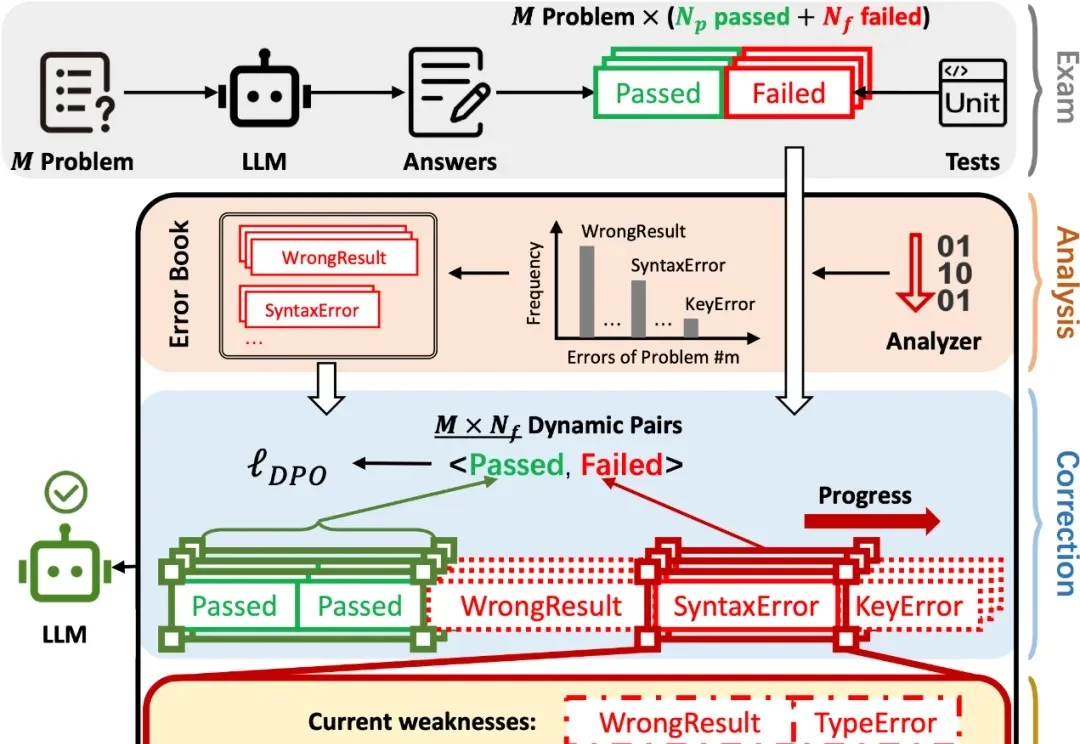

在 AI 辅助 Coding 技术快速发展的背景下,大语言模型(LLMs)虽显著提升了软件开发效率,但开源的 LLMs 生成的代码依旧存在运行时错误,增加了开发者调试成本。

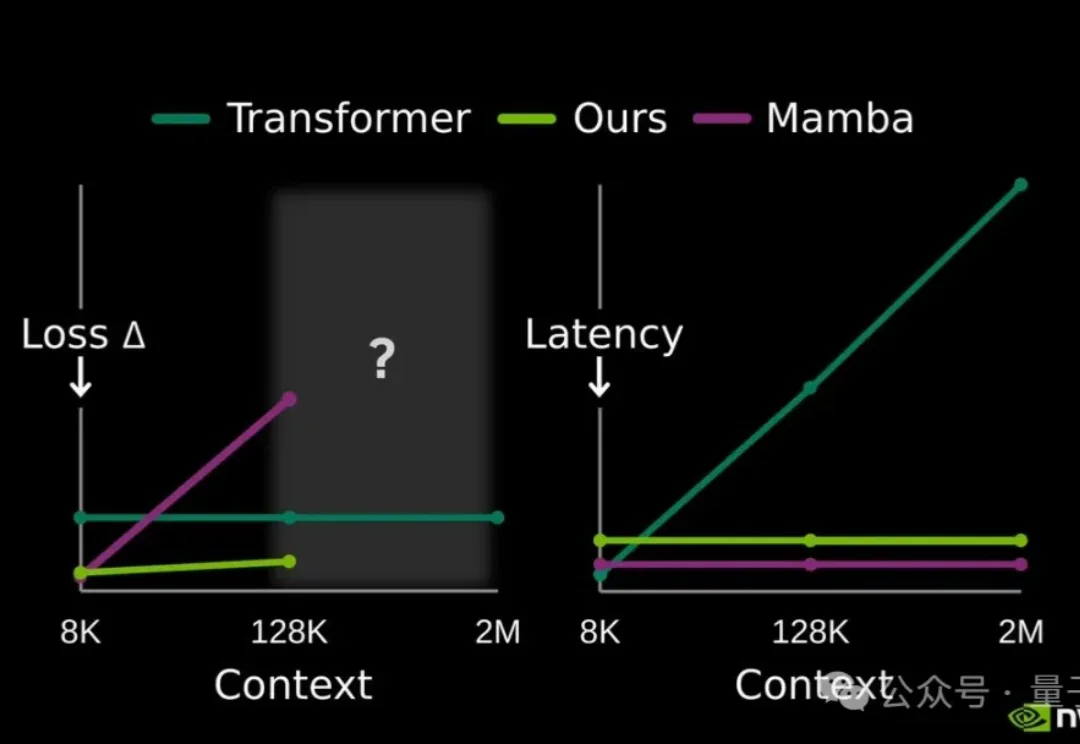

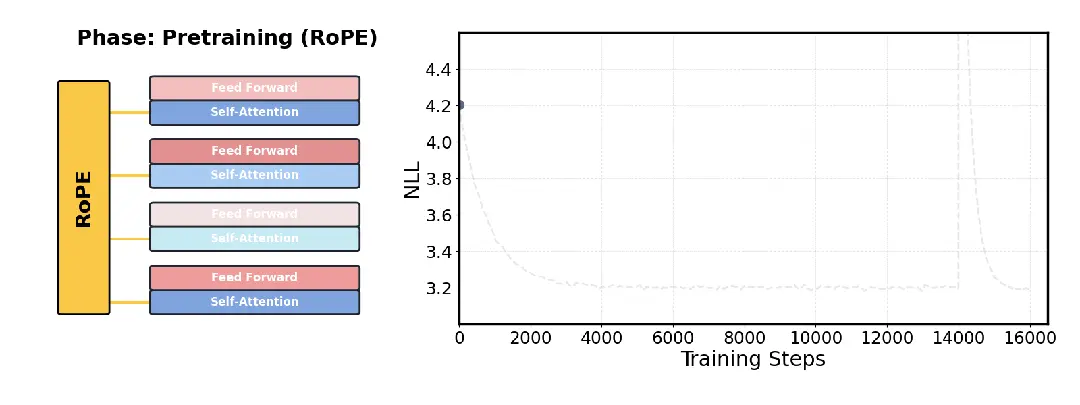

针对大模型长文本处理难题,Transformer架构的核心作者之一Llion Jones领导的研究团队开源了一项新技术DroPE。

一份大模型中标数据报告,揭示了产业重心转移的清晰轨迹:应用类项目占比近六成,市场用真金白银为 “落地” 投票。2025 年,中国大模型产业在招投标市场上演了一场令人瞠目的 “狂飙”。智能超参数的监测数据显示,全年大模型相关中标项目数量达到 7539 个,披露金额 295.2 亿元,较 2024 年分别激增 396% 与 356%。市场正以前所未有的速度,将技术潜力兑换为商业订单。

现在,我们越来越多地将大语言模型应用于搜索、编程、内容生成和决策辅助等现实场景中。尽管每天有数百万人使用大模型,但它的问题也随之而来,例如有时会产生幻觉,甚至在特定情境下表现出误导或欺骗用户的倾向。

机器人终于迎来自己的「iOS时刻」,全球首个具身Agentic OS来了:不是装个更聪明的大模型,而是给机器人配上一套真正的「操作系统」。

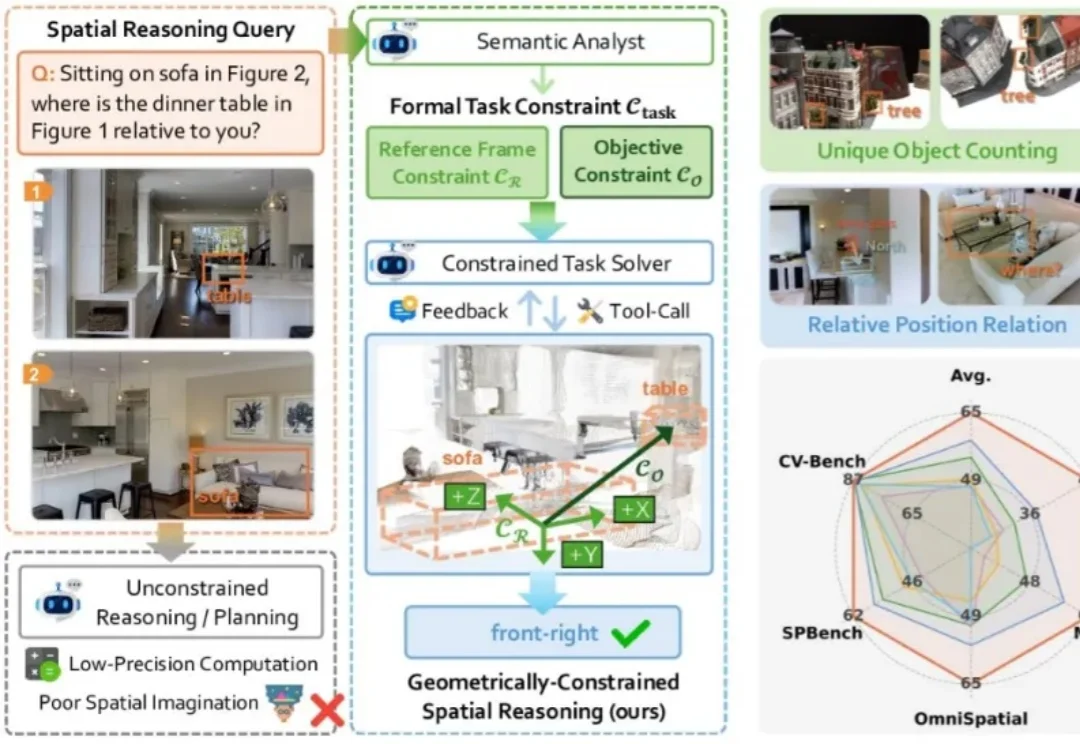

现有的视觉大模型普遍存在「语义-几何鸿沟」(Semantic-to-Geometric Gap),不仅分不清东南西北,更难以处理精确的空间量化任务。例如问「你坐在沙发上时,餐桌在你的哪一侧?」,VLM 常常答错。